С каждым годом инструменты на базе искусственного интеллекта для помощи программистам становятся всё более востребованными. Одним из таких инструментов является Cursor — редактор кода, который интегрирует AI для улучшения продуктивности и автоматизации рутины. Однако недавно в сообществе разработчиков появилась дискуссия, вызванная необычным поведением этого сервиса. Один из пользователей заметил, что при редактировании небольшой Swift-программы в 1200 токенов Cursor затратил на обработку более 269 тысяч токенов. Такая ситуация озадачила многих и вызвала волну вопросов о причинах и стоимости использования данного инструмента.

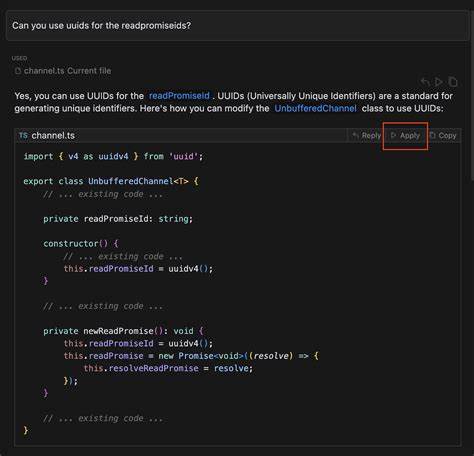

В основе работы Cursor лежит концепция токенизации — процесс разбиения текста на мелкие элементы, или токены, для анализа и обработки моделью. В контексте AI, с каждым запросом или генерацией текста система подсчитывает количество задействованных токенов, что напрямую влияет на ценообразование и тарификацию сервиса. Пользователь, столкнувшийся с аномалией, присоединился к своей истории ссылку на официальную систему токенов OpenAI для подсчёта — его 192 строки кода Swift действительно составляли около 1213 токенов. Однако с Dashboard Cursor было зарегистрировано расходование около 269 тысяч токенов, что в десятки раз превышало ожидаемый уровень. Пользователь выразил обеспокоенность, особенно учитывая, что он является подписчиком Pro-плана.

Сравнение с предыдущими нормами расхода токенов показало существенные изменения в работе платформы. Это вызвало подозрения, что мог произойти сбой в системе учёта токенов или изменения в механизме тарификации, о которых пользователи не были информированы заранее. В ответ на этот пост несколько участников сообщества отметили наличие похожих наблюдений. Одни предположили, что в подсчёт могут включаться не только непосредственные токены запроса и ответа, но и так называемые кеш-токены — данные, используемые для индексации, хранения и поиска по всему коду. Другие объясняли, что масштабное количество токенов связано с механизмами обработки большого объёма внутренней информации, включая множественные операции чтения и записи кеша.

На самом деле, в современных AI-инструментах, таких как Cursor, задействованы сложные архитектуры, включающие работы с векториальными представлениями кода (embedding), которые служат для быстрого поиска соответствий и контекста в кодовой базе. Такой подход спасает время пользователя и позволяет оперативно получить релевантные предложения и исправления. Но при этом напрямую увеличивает расход токенов в системе и потенциально влияет на тариф. В обсуждениях прозвучали две ключевые динамики. Первая – техническая, связанная с тем, что токены кэширования и индексирования стоят существенно меньше обычных.

Это означает, что фактическая стоимость, несмотря на количество токенов, может оставаться в рамках плана или даже быть выгоднее, чем у конкурентов. Вторая – пользовательская обеспокоенность, выраженная в необходимости понять, насколько такие расходования токенов оправданы и насколько прозрачен механизм их подсчёта. Важно отметить, что сама архитектура Cursor включает динамическое индексирование всей кодовой базы пользователя для улучшения качества подсказок и исправлений. В случае редактирования небольшого файла, особенно если он частью большого проекта, система может запускать параллельное сканирование множества связанных сегментов кода, что приводит к увеличению общего количества обрабатываемых токенов. Из-за такой особенности многие пользователи высказали просьбу к разработчикам об увеличении прозрачности в механизмах тарификации и отчётности.

Возможность детального просмотра разделённых на типы токенов позволяет больше понять, за что именно начисляются расходы. Например, выделение отдельно токенов запросов, ответов, кеша и внутренних вычислений даёт ценную информацию для оценки экономической составляющей использования Cursor. Одновременно с этим вопрос возник, насколько это повлияет на масштабы использования платформы в долгосрочной перспективе. Большое потребление токенов может стать преградой для пользователей с ограниченным бюджетом, что вынудит задуматься о распределении ресурсов и выборе оптимальных сценариев применения. Кроме того, некоторые высказали опасения, что если система действительно «пожирает» токены из-за бага, это может привести к непредсказуемым счетам и подрыву доверия.

Для тех, кто активно пользуется AI-инструментами для программирования, важным становится понимание не только функциональности и эффективности, но и структуры оплаты. Обоснованный расход токенов всегда предпочтительнее непонятных и неожиданных затрат. В этом контексте запросы сообщества по улучшению визуализации и детализации отчётов в дашборде Cursor выглядят логично и своевременно. В целом ситуация с перерасходом токенов показывает, как новые технологии требуют адаптации не только в плане интерфейсов и алгоритмов, но и в экономическом плане. Сегодня AI-инструменты активно интегрируются в рабочие процессы программистов, и важно, чтобы пользователи чувствовали прозрачность и контроль над своим временем и затратами.

![How do Graphics Cards Work? [video]](/images/348CE4DB-A96C-4627-B734-F29E349C2D36)