Современный мир программирования постоянно развивается, и на передний план выходят новые технологии, способные значительно улучшить работу разработчиков. Одним из таких направлений является использование больших языковых моделей (LLM), которые упрощают написание кода, ускоряют поиск ошибок и помогают в автоматизации многих рутинных задач. Сам редактор Vim, известный своей мощью и гибкостью, давно полюбился профессионалам за способность адаптироваться под любые запросы. Интеграция LLM с Vim открывает целый спектр возможностей для создания более эффективных и интеллектуальных рабочих процессов. В данной статье рассмотрим, как можно использовать AI-помощников в Vim, с какими инструментами столкнулись пользователи, а также обсудим особенности их настройки и применения в реальной практике.

Vim & LLM: союз для продуктивности Vim традиционно ценится за простоту, скорость и невероятную кастомизацию. Именно эти свойства делают его привлекательным при интеграции с LLM, поскольку большие языковые модели требуют корректной настройки взаимодействия, чтобы приносить пользу, а не мешать. Интеграция AI в Vim позволяет выполнять множество задач, начиная от автодополнения и заканчивая генерацией целых блоков кода и даже проведением анализа существующего — весь этот функционал становится доступным без переключения между окнами или приложениями. Каким образом это реализовать на практике? Ответ строится на использовании плагинов и сторонних сервисов. Обзор популярных инструментов для AI в Vim Одним из наиболее обсуждаемых в профессиональной среде инструментов является CodeCompanion — расширение, совместимое с различными языковыми моделями, включая Gemini.

Пользователи отмечают, что CodeCompanion позволяет не только вести диалог с моделью для объяснения и проверки кода, но и настраивать область контроля — например, ограничиваться одним файлом или расширять взаимодействие на весь проект. Такой уровень гибкости обеспечивает возможность использования AI как советчика или полноценного помощника для рефакторинга и генерации кода. Другой интересный вариант — союз Vim с помощью Aider, обладающего возможностью работать в отдельных вкладках вместе с редактором. Это разделение позволяет держать AI-инструмент наготове, не мешая основному процессу программирования, но при этом иметь мгновенный доступ к подсказкам, генерации или переформулированию частей текста. Есть и альтернативные подходы, например, использование редактора Zed в режиме Vim.

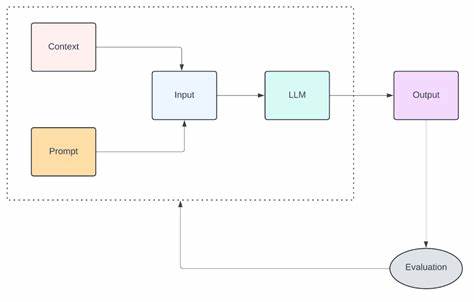

Дело в том, что некоторые современные редакторы изначально создаются с интегрированными AI-сервисами, и возможность работать с ними в стиле Vim может стать золотой серединой для тех, кто хочет применить преимущества AI без отрыва от привычного интерфейса. Практические советы по внедрению LLM в Vim Первый важный момент — определиться с целями использования AI. Разные команды и индивидуальные разработчики ищут разные функции: кому-то достаточно автодополнения, кто-то хочет генерировать тесты или документацию, а третьим нужны рекомендации по оптимизации архитектуры приложения. Исходя из этого, нужно выбирать соответствующие плагины и конфигурации. Если говорить о настройке, немаловажно заранее определить, как будет происходить взаимодействие с моделью: напрямую через API, через промежуточные инструменты или локальные серверы.

Многим понравилась концепция с отдельной вкладкой для диалога с AI, поскольку она не мешает основному коду и позволяет продуктивно использовать советы AI без отключения от среды разработки. Также стоит учитывать производительность и время отклика — мощные модели требуют ресурсов, и в зависимости от конфигурации ПК или сервера важно настроить минимальную нагрузку. Практический опыт пользователей Из обсуждений на популярных технических форумах, таких как Hacker News, можно отметить, что интеграция больших языковых моделей с Vim уже перестала быть теоретическим вопросом и получила конкретные внедрения. Некоторые разработчики отмечают полное погружение в AI-помощника как в случае с Cursor, который предлагает интегрированную среду с поддержкой AI. Другие же выбирают гибридные модели с отдельными инструментами, где можно стартапить из привычного Vim.

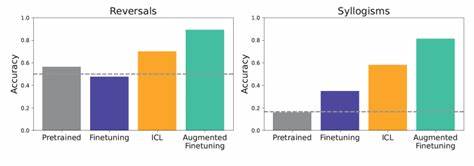

Очевидно, что пользователи делятся позитивным опытом в том, что AI помогает справляться с проблемами кода быстрее, предлагает интересные варианты реализации функций и облегчает процесс изучения новых языков программирования и библиотек. Искусственный интеллект уже не воспринимается как отдельная технология, а становится частью повседневного инструментария. Тонкости и подводные камни Конечно, с внедрением LLM в Vim связаны и определённые вызовы. В первую очередь это безопасность: поскольку многие решения требуют подключения к облачным сервисам, важно не допускать утечек конфиденциального кода. Также качество ответов моделей не всегда беспрекословно, поэтому критический подход к рекомендациям AI сохраняется.