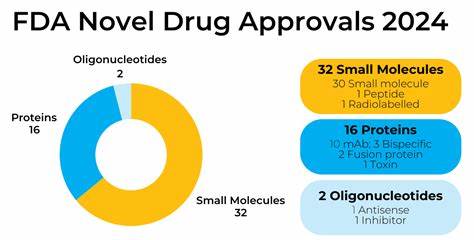

В эпоху стремительного развития технологий искусственный интеллект (ИИ) становится неотъемлемой частью множества отраслей, включая медицину и фармацевтику. Министерство здравоохранения и социальных служб США (HHS) под руководством Роберта Ф. Кеннеди-младшего продвигает использование генеративных ИИ-решений в различных агентствах, включая Управление по контролю качества пищевых продуктов и лекарств (FDA). В частности, в FDA был внедрен ИИ-инструмент под названием Elsa, призванный повысить эффективность сотрудников и ускорить процессы одобрения новых лекарств. Однако недавний отчет журнала CNN выявил серьезные проблемы с точностью и достоверностью данных, генерируемых этой системой, что вызывает обоснованные опасения по поводу безопасности и надежности использования подобных технологий в столь критически важной сфере как здравоохранение.

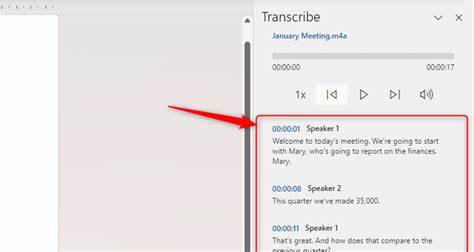

Elsa была запущена в FDA в июне 2025 года с целью помочь в выполнении повседневных задач — создании заметок для встреч, кратких отчетов и прочей документации, что теоретически должно облегчить работу специалистов и сократить временные затраты на рутинные операции. Однако шесть текущих и бывших сотрудников FDA, опрошенных CNN, поделились неоднозначными впечатлениями. Трое из них отметили, что использование Elsa принесло определенную пользу, помогая структурировать информацию и создавать черновики текстов. Тем не менее, трое других сотрудников заявили, что алгоритм регулярно «галлюцинирует» — создает полностью вымышленные исследования и неверно интерпретирует существующие научные работы. Такой эффект, свойственный многим большим языковым моделям, вызывает тревогу, ведь в фармацевтической сфере любая неточность может иметь тяжелые последствия для качества лекарств, безопасности пациентов и общественного здоровья.

Опасность применения ИИ в процессе одобрения лекарств заключается в том, что сотрудники FDA часто вынуждены доверять сгенерированным алгоритмом сводкам и анализам, не имея возможности оперативно проверить каждое заявление на достоверность. Например, Elsa может составить аннотацию к 20-страничному исследованию о новом препарате, при этом пропуская важные предупреждающие моменты или искажая ключевые данные. Такие ошибки сложно выявить без глубокого профессионального анализа, что ставит под угрозу объективность и надежность решений, принимаемых на основе этих материалов. Дополнительным источником проблем служит недавний отчет комиссии Make America Healthy Again (MAHA), возглавляемой Кеннеди-младшим. В документе были обнаружены многочисленные ссылки на исследования, которые на самом деле не существовали или были искажены.

Анализ, осуществленный некоммерческой организацией NOTUS, выявил как минимум семь полностью фиктивных источников. Хотя точное участие Elsa в создании этого отчета пока остается неясным, ситуация лишь подчеркивает существующие риски использования ИИ без адекватного контроля и верификации данных. Для финансирования проекта Elsa было выделено всего 12 тысяч долларов на первые четыре недели работы, что крайне мало для серьезной разработки и внедрения высокотехнологичных решений в такой ответственной сфере. Внутренние документы FDA, попавшие в распоряжение Gizmodo, хвастались «экономичностью» и преимуществами низкой стоимости проекта. Однако экономия в данном случае стоит потенциально слишком дорого: сокращение расходов приводит к повышению рисков появления ложной информации и неправильных решений при одобрении новых медицинских препаратов.

В частности, сотрудники FDA протестировали Elsa, задавая ей цепочку простых вопросов, например, о количестве одобренных для детей препаратов определенного класса. ИИ не только выдал неверные ответы, но и делал это с уверенностью, позже прося прощения, что, разумеется, не исправляет реальных ошибок. Такая ситуация иллюстрирует базовую проблему генеративного ИИ — уверенное создание искаженной или вымышленной информации, называемой в индустрии термином «галлюцинации». Несмотря на озвученные претензии, представители FDA настаивают, что использование Elsa соответствует стандартам и что явления галлюцинаций ИИ не являются чем-то принципиально новым или уникальным для этого инструмента. Комиссар FDA Марти Макари подчеркивает, что проблемы с генерацией фиктивных данных характерны для всех современных языковых моделей и генеративного ИИ, и что организации следует воспринимать их с осторожностью.

Тем не менее, многие специалисты и общественные фигуры говорят о том, что ИИ пока что не готов самостоятельно принимать решения такого уровня ответственности. Эксперты подчеркивают, что широко распространенное мнение о том, что искусственный интеллект значительно экономит время и увеличивает эффективность, может быть обманчивым. Исследования показывают, что задачи у программистов, использующих ИИ, выполнялись на 20% дольше, даже несмотря на их субъективное ощущение большей продуктивности. Аналогично и в медицине — если нет возможности тщательно перепроверить результаты, в том числе полученные с помощью ИИ, использование таких инструментов может лишь увеличить нагрузку и риск допустить ошибку. Роберт Ф.

Кеннеди-младший на слушаниях в Конгрессе неоднократно заявлял о намерениях активно внедрять ИИ для ускорения процессов одобрения лекарств, а также анонсировал планы мониторинга здоровья американцев с помощью носимых устройств. Один из союзников Кеннеди, назначенный президентом Трампом кандидат в должность Главного хирурга США Кейси Минс, владеет компанией Levels, производящей устройства для постоянного мониторинга уровня глюкозы у здоровых людей, что вызывает вопросы у экспертов о необходимости и пользе таких технологий вне контекста диабета. В ответ на критику FDA выпустило официальное заявление, в котором отмечалось, что материалы CNN были «искажены и вырваны из контекста», а источники — недовольные бывшие сотрудники, которые якобы не работали с актуальной версией Elsa. Также в заявлении осуждалась журналистика CNN, названная «галлюцинирующей». Несмотря на это, мнения аналитиков индустрии и здравоохранения говорят о том, что подробные и прозрачные оценки работы ИИ необходимы и крайне важны для дальнейшего развития технологий и их надежного применения.

Ситуация с Elsa иллюстрирует более широкую проблему использования ИИ в сложных сферах, где цена ошибки крайне высока. Автоматизация рутинных операций и помощь в анализе данных безусловно востребованы, однако повсеместное внедрение генеративных моделей без способностей к точной проверке информации и без понимания потенциальных рисков может поставить под угрозу фундаментальные основы научной и клинической деятельности. Остается надеяться, что регулирующие органы уделят должное внимание качеству и достоверности данных при использовании ИИ и что внедрение таких технологий будет происходить постепенно, с усиленными мерами контроля и обязательной верификацией каждого решения, затрагивающего здоровье миллионов людей. При правильном подходе искусственный интеллект может стать мощным помощником в разработке новых лекарств и улучшении медицинской практики, но на данном этапе его использование требует крайней осторожности и критического отношения.