В последние годы развитие искусственного интеллекта (ИИ) развивается с поразительной скоростью, особенно в области обработки естественного языка. Современные языковые модели (ЯМ) становятся всё мощнее, но при этом продолжают испытывать серьёзные трудности с ресурсопотреблением и эффективностью обучения. Одним из ключевых ограничений современных моделей является огромный объём данных, необходимых для их тренировки — зачастую это триллионы слов, что существенно превышает количество информации, с которым сталкивается человек за всю жизнь. Несмотря на впечатляющие достижения, такой подход к обучению вызывает вопросы о его устойчивости и целесообразности. Именно поэтому всё больше учёных обращают внимание на природу человеческого обучения, в частности на способы, которыми младенцы овладевают языком в условиях ограниченного доступа к данным и при разнообразных сенсорных стимулах.

Младенцы, обучающиеся языку, не получают триллионы слов для анализа, однако за первые 13 лет жизни они способны освоить грамматику, лексику и даже нюансы коммуникации, используя данные, на порядок меньшие, чем современные модели. Таким образом, у исследователей возникает справедливый вопрос: каким способом младенцы учатся так быстро и эффективно? Можно ли воссоздать или адаптировать эти механизмы для обучения ИИ, чтобы снизить зависимость от объемных, энергетически затратных и зачастую неустойчивых наборов данных?Один из интересных проектов, стремящихся ответить на эти вопросы, — BabyLM Challenge. Этот международный конкурс предлагает исследователям обучать языковые модели на объемах данных, сопоставимых с тем, что слышит ребёнок до подросткового возраста — порядка 10 или 100 миллионов слов. В сравнении с триллионом слов, используемых классическими ЯМ, это — исследование в условиях экстремальной экономии ресурсов. Цель BabyLM — разработать методы, позволяющие добиться высокой производительности моделей при минимальных объемах тренировочных данных, приближаясь к человеческому уровню обучения.

Особый интерес в рамках BabyLM вызывает подход, вдохновлённый развитием младенцев. В естественной среде дети не получают готовую, идеально структурированную информацию, а обучаются через сочетание простых и сложных стимулов, звуков и образов. Ученые заметили, что многие современные модели упускают из вида такой фактор, как постепенное усложнение материала или смешение различных типов подачи информации. Примером вдохновляющей идеи является куррикулумное обучение — метод, при котором обучение начинается с простого материала и постепенно усложняется. В рамках BabyLM эксперименты с куррикулумом дали интересные результаты, особенно в части применения программы на уровне слов, а не целых предложений.

Исследовательская группа из Кембриджского университета предложила новую методику, в которой обучение модели структурировалось по частям речи — сначала маскировались существительные и глаголы, затем — другие виды слов. Такой подход имитирует этапы, через которые проходит ребёнок, постепенно расширяя круг знакомых и осваиваемых понятий. Итогом стал заметный прирост качества языковых моделей, что подтверждает — изучение естественных паттернов освоения языка младенцами может быть эффективным для искусственного интеллекта.Не менее важным аспектом является разнообразие входных данных. Дети учатся не только через слова, но и используя визуальные и другие сенсорные сигналы — звуки, прикосновения, запахи.

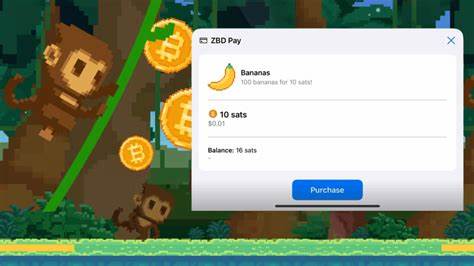

Этот мультимодальный опыт способствует формированию более богатого восприятия мира и, соответственно, более глубокому пониманию языка. В рамках последних BabyLM вызовов появилась категория моделей, работающих с несколькими типами данных: изображениями и текстами. Хотя на данный момент эти модели пока не превзошли классические методы, теоретическая основа свидетельствует о большом потенциале именно такого синтеза данных. Одна из главных задач будущих исследований — найти оптимальные алгоритмы мультимодального обучения, которые позволят искусственному интеллекту овладевать знанием более естественным и эффективным способом.Другим любопытным подходом к улучшению работы с ограниченными данными стали методы «ремикса» текстов.

Участники BabyLM 2023 года создали новые тренировочные примеры через перестановку и комбинирование предложений из исходного набора данных. Таким образом, модель получала расширенный опыт без привлечения внешнего корпуса текстов. Это можно сравнить с внутренним «монологом», который человек ведёт для закрепления и уточнения своих мыслей — своего рода самобеседой, способствующей академической и творческой активности. Однако подобные техники требуют тонкой настройки, чтобы не «перегрузить» модель избыточной или нерелевантной информацией.Кроме непосредственных алгоритмических новшеств, BabyLM Challenge стимулирует важные дискуссии в научном сообществе, касающиеся эффективности и устойчивости современных языковых моделей.

Тренировка моделей на огромных объемах данных требует значительных энергетических затрат, что порождает экологические вопросы. Для академических и независимых исследователей с ограниченным финансированием такой подход может быть недоступен, что препятствует развитию инноваций вне крупных технологических корпораций. BabyLM создает пространство, где можно экспериментировать с ограниченными ресурсами, обмениваясь идеями и ошибками, стимулируя открытые и более устойчивые подходы к обучению ИИ.Интересно отметить, что новые модели, разработанные в рамках BabyLM Challenge, интегрируют сочетание техник предсказания следующего слова — типичных для GPT и предсказания скрытых слов — как в BERT. Такое объединение, представлено в модели GPT-BERT, показало лучшие результаты и подходит под наблюдения психолингвистики о том, как люди обрабатывают и предугадывают язык.

Люди постоянно делают предположения о словах, которые услышат дальше, и корректируют свои ожидания на ходу. Маскирование слов в предложении — хоть и не так распространено в живом общении — также помогает выявлять пробелы и восстанавливать смысл. В совокупности эти методы дают баланс между предсказательной и восстановительной стратегиями, что отражает реальный процесс освоения языка у младенцев.Путь к созданию более эффективных и устойчивых алгоритмов машинного обучения лежит через глубокое понимание биологических основ познания. Обогащение технологий ИИ наблюдениями из развития младенцев может привести к созданию систем, которые учатся с минимальной потребностью в данных, более гибко адаптируются к окружающей среде и способны превзойти существующие решения по эффективности.

Проекты вроде BabyLM Challenge играют ключевую роль в объединении знаний из психологии, лингвистики и компьютерных наук, открывая новые перспективы для будущего искусственного интеллекта.В ближайшие годы развитие этого направления обещает стать не только академическим вызовом, но и практическим прорывом — возможность создавать языковые модели, способные обучаться в условиях ограниченных ресурсов и строить более глубокое понимание мира. Такой подход не только поможет снизить негативное воздействие на окружающую среду за счет меньших энергозатрат, но и приблизит нас к созданию ИИ, который действительно учится и развивается по-детски, осваивая язык со свойственной нам любознательностью и адаптивностью.