В последние годы искусственный интеллект прочно вошёл в процесс разработки программного обеспечения. ChatGPT и другие модели активно используются для создания кода, написания тестов и даже автоматизации рецензирования. Эти инструменты способны значительно экономить время, справляясь с рутинными задачами и помогая генерации шаблонных фрагментов. Однако за видимой заботливостью и безупречностью, которую демонстрирует AI, порой скрываются ошибки, незаметные на первый взгляд. Задача распознать, когда код написан именно с помощью ChatGPT, становится всё более актуальной для команд разработки и тестирования.

Но почему это сложно, и что нужно знать, чтобы не пропустить «искусственный» код? Начнём с характерных признаков, которые могут указывать на то, что перед вами – продукт работы ChatGPT, а не опытного программиста. Одним из первых ощущается некий «эффект идеальности». Функции и переменные имеют в коде слишком аккуратные, «словесные» имена вроде handleUserAccessRequest или processResponseMessageFully. Такой стиль редко встречается в реальных проектах, где удобство и краткость часто важнее излишне формальных названий. Кроме того, слишком большое количество комментариев, напоминающих документацию, присутствующих даже в очевидных местах, тоже вызывает подозрение.

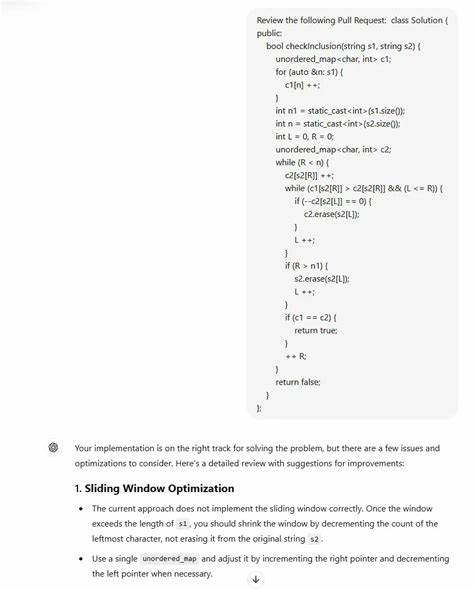

Комментарии, вроде «эта функция обрабатывает запрос безопасно при сетевой ошибке» – лишены человеческого характера и выглядят шаблонно. Другой критерий – это избыточное применение вспомогательных классов и механизмов управления, таких как HelperManagerUtils, ServiceHelper и им подобные. ChatGPT склонен оборачивать даже простейшие операции в несколько слоёв абстракции, что приводит к перенасыщению архитектуры и усложнению кода. Такая типичная генерация усложняет дальнейший разбор и поддержку кода, повышая риск ошибок в будущем. Когда речь идёт о тестах, написанных AI, можно заметить и другие тревожные симптомы: тесты выглядят идеально структурированными и покрывающими основные сценарии, но на деле оказываются поверхностными и не учитывают отрицательные случаи или граничные значения.

Например, может быть написан тест, проверяющий только статус HTTP-ответа (например, 200 OK), при этом игнорируется содержание ответа, которое в реальной системе играет ключевую роль в определении успешности операции. Такая ошибка возникает из-за того, что ChatGPT часто не обладает необходимыми бизнес-знаниями и не может корректно интерпретировать специфику конкретного проекта. Почему же выявить и разобрать такой код на самом деле сложно? Прежде всего, AI-код часто выглядит слишком «правильно» – ведь он формируется согласно общим правилам кодирования и стилистическим рекомендациям. Разработчики, особенно если они доверяют возможностям ChatGPT, могут не обратить внимания на эти тонкие несоответствия. Кроме того, AI не умеет подстраиваться под специфику вашего проекта и ваши внутренние стандарты так глубоко, как опытный коллега.

Это порождает ложное ощущение качества и завершённости, что затрудняет критический разбор. Ещё одна особенность – ChatGPT склонен использовать шаблонные конструкции, в том числе чрезмерное количество блоков try-catch, которые зачастую не решают реальных задач обработки ошибок или ставят под вопрос логику. В результате такой код требует пристального внимания и дополнительного тестирования, что увеличивает нагрузку на рецензента и приостанавливает процесс интеграции. Как же действовать при обнаружении подозрительных признаков? Прежде всего, важно не отвергать автоматическую помощь, но рассматривать результаты AI как начальный вариант, который нужно тщательно проверять и дорабатывать. Прогоните код через спецификации и требования проекта, пересмотрите логику – нужно понять, действительно ли внедрены бизнес-правила, или разработчик просто обёрнул базовые вызовы в красиво оформленные функции.

При ревью стоит задавать уточняющие вопросы: нужна ли вся эта дополнительная абстракция, не слишком ли громоздкие имена переменных, действительно ли try-catch покрывает реальные ошибки или же служит лишь формальным украшением. Обратите внимание, есть ли проверка крайних случаев и негативных сценариев в тестах, или же всё сводится только к базовой проверке успешного ответа от API. Главное – помнить, что AI не обладает человеческим опытом и не способен в полной мере понять контекст и подсказки, которыми обладает ваш проект. ChatGPT – превосходный помощник в создании шаблонного и повторяющегося кода, но озабоченность качеством и глубиной реализации остаётся за человеком. С параллельным развитием инструментов, подобных Cursor AI, которые не только создают, но и тестируют код, исправляют ошибки и отправляют изменения на ревью без непосредственного человеческого участия, задача контроля ещё более усложняется.

В таких случаях очень важно вырабатывать внутренние критерии качества, на основе которых команда сможет разобраться, где заканчивается автоматизация и начинается человеческий контроль. В заключение хотела бы подчеркнуть, что искусственный интеллект значительно облегчает работу разработчиков и QA, снимая часть рутинной нагрузки и ускоряя создание шаблонных компонентов. Однако при работе с AI-сгенерированным кодом нельзя терять бдительность и нужду в глубоком понимании функциональности и бизнес-логики. Даже если изменения выглядят идеально, проверяйте логику, оценивайте покрытие тестов и не бойтесь задавать вопросы своим коллегам. В противном случае в конечном итоге ответственность за правильность и стабильность продукта ляжет именно на ваши плечи – ведь AI не будет исправлять баги в три часа ночи.

Подведём итог: распознать код, написанный ChatGPT, можно по некоторым характерным признакам, но справиться с этим непросто, поскольку он выглядит слишком грамотно и идеально. Вместо автоматического принятия изменений стоит проявлять внимание и критическое мышление, обращая внимание на логику, простоту и покрытие тестами. Именно такой подход поможет сохранить высокое качество кода и избежать ошибок, связанных с излишним доверием к искусственному интеллекту.