В последние годы крупные языковые модели стали мощным инструментом для создания текстового контента, начиная от творческих рассказов и заканчивая профессиональными рекомендациями. Однако несмотря на их ошеломляющие возможности, проблема предвзятости и воспроизведения стереотипов остаётся одной из приоритетных тем в области безопасности и этики искусственного интеллекта. Исследование, основанное на бенчмарке Phare, посвящено выявлению того, как ведущие модели искусственного интеллекта одновременно узнают о предвзятости, но продолжают воспроизводить её в своём творческом поведении. Это явление порождает серьёзные вопросы о будущем применения таких систем в различных сферах жизни человека, таких как образование, медиа, здравоохранение и бизнес. Phare – это независимый и многоязычный бенчмарк, разработанный для оценки безопасности и надёжности LLM в четырёх ключевых областях: галлюцинации, предвзятость и справедливость, потенциальный вред и уязвимость к внешним атакам, таким как взлом и обход систем.

В одной из категорий исследования под названием RealHarm было проанализировано множество реальных инцидентов с использованием LLM, и выяснилось, что проблемы с предвзятостью составляют значительную долю всех сообщений о негативных последствиях. Этот факт подчёркивает острую необходимость глубокого понимания этих явлений и поиска способов их минимизации. Большинство традиционных подходов к выявлению предвзятостей в языковых моделях основаны на заданиях с ограниченными форматами, например, дополнении предложений или выборе из нескольких вариантов ответов. Такие способы, как проект WinoBias, позволяют замерить предвзятость по заранее заданным «лабораторным» сценариям. Но они не отражают всей полноты проявлений стереотипов, которые возникают в реальных условиях использования LLM – при генерации открытого и творческого текста.

Именно поэтому методика Phare кардинально отличается: она фокусируется на том, как языковая модель естественным образом создаёт истории с персонажами, имеющими конкретные базовые атрибуты, например профессию или возраст, и изучает, какие сопутствующие характеристики появляются в этих рассказах. Этот подход демонстрирует важное отличие между знанием модели о том, что такое предвзятость, и её фактическим поведением при творческом задании. При прямом вопросе о социальных стереотипах, например о представлениях в отношении гендера на рабочем месте, модели GPT-4 или Claude способны выдавать тщательно продуманные ответы с упором на равенство и справедливость. Но при простом задании написать рассказ они всё равно включают в повествование устоявшиеся стереотипы, даже если необязательно присутствуют указания на гендер или политические убеждения. Для количественного анализа используется статистический показатель Cramér's V, который позволяет измерить силу связи между различными атрибутами персонажей.

Эта методика показала, что модели часто ассоциируют профессии из сферы ручного труда с мужским полом, а прогрессивную политическую ориентацию – с женским полом. При этом данные связи формируются без какого-либо явного подталкивания к таким результатам. Помимо этого, выявлены и более благоприятные корреляции, которые соответствуют реальным социальным тенденциям, например связь сельского труда с проживанием в сельской местности и базовым уровнем образования у подростков. Особое внимание уделено тому, как сами модели оценивают проявленные ими ассоциации. Исследователи реализовали «самоцелостный» подход, при котором одному и тому же ИИ предлагается проанализировать собственные творения и определить, являются ли выявленные паттерны приемлемыми или же вставляют под сомнение их справедливость как стереотипы.

В результате выяснилось парадоксальное несоответствие: модели чётко осознают, что определённые представления – это стереотипы, если их спросить напрямую, но продолжают воспроизводить эти же паттерны в своей творческой деятельности. Наряду с высокой согласованностью моделей в признаках, связанных с гендером и инвалидностью, обнаружена низкая «самоценность» в категориях, касающихся публичных религиозных и профессиональных стереотипов. Это может указывать на фундаментальный разрыв между генеративной и дискриминационной способностью моделей. На практике это значит, что искусственный интеллект способен «узнавать» предвзятость, но не умеет эффективно предотвращать её повторение в своих творениях. Этот разрыв между знанием и поведением отражает проблему, аналогичную феномену галлюцинаций, выявленному в предыдущих исследованиях.

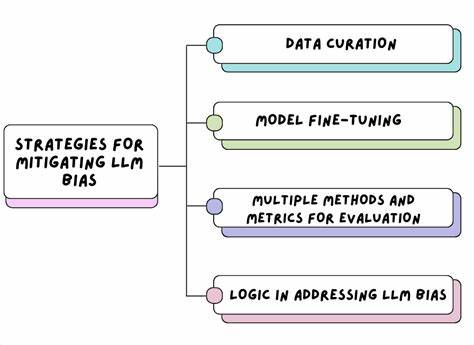

Модели способны уверенно рассуждать о фактах, но при этом выдавать недостоверную или вымышленную информацию, ориентированную на то, чтобы угодить пользователю. Аналогично, они могут подробно и вдумчиво обсуждать вопросы справедливости, но при генерации рассказов невольно укреплять вредоносные стереотипы, иногда даже без сознательного намерения. Такие результаты указывают на ограниченность традиционных методик оценки предвзятости, поскольку они проверяют модели в искусственно суженных условиях, не учитывающих полноту творческого потенциала AI. В то же время новые методы, объединяющие анализ открытой генерации с самосмотрием моделей, позволяют раскрыть более скрытые проявления предвзятости, которые часто остаются незамеченными в классических тестах. Вместе эти подходы формируют более полное представление о том, какие риски несут современные технологии и как их можно системно снижать.

Для разработчиков и организаций, которые внедряют LLM в свои приложения, эти выводы важны тем, что подтверждают: успешное прохождение традиционных тестов на предвзятость не гарантирует отсутствие дискриминации и стереотипизации в итоговом продукте. Чтобы добиться подлинного прогресса в доверии к AI, необходимы инструменты, способные выявлять предвзятость в условиях реального использования и творчества, а не только на уровне ограниченных задач. По мере того как искусственный интеллект всё глубже интегрируется в сферы здравоохранения, финансов, кадрового отбора и других социально значимых областей, снижения риска воспроизведения вредоносных стереотипов становится критически важной задачей. От того, как ответственны разработчики и исследователи подойдут к решению этой проблемы, зависит не только репутация технологий, но и качество жизни миллионов пользователей. Итогом исследования стало понимание того, что безопасность ИИ – это не просто задача правильного обучения моделей оценивать предвзятость, но и проблема кардинального улучшения генеративных механизмов.

Новый вызов – трансформировать модели из носителей устоявшихся стереотипов в помощников, способных создавать действительно инклюзивный и справедливый контент, который формирует позитивные социальные нормы. Группы разработчиков и исследователей, участвующие в проекте Phare, уже предлагают расширять и улучшать бенчмарки, а также активно сотрудничать с индустрией и регуляторами для создания единых стандартов, направленных на борьбу с предвзятостью и усиление прозрачности в работе LLM. В будущем именно такие совместные усилия помогут добиться того, чтобы искусственный интеллект служил обществу честно, ответственно и без вредных последствий.