В последние годы языковые модели достигли значительных успехов благодаря масштабному обучению на обширных корпусах текстовых данных. Однако традиционно большая часть внимания уделялась самим моделям и архитектурам, в то время как тренировочные данные зачастую оставались закрытыми, недоступными для общественности и исследователей. Это создавало сложности для оценки качества моделей и понимания особенностей данных, на которых они обучались. В этой связи возникает важнейшая задача — как на основе весов предобученной или дообученной модели восстановить или аппроксимировать исходные тренировочные данные. Данная проблема представляет собой новый поворот в изучении искусственного интеллекта и имеет существенное значение для прикладных задач и теоретических исследований.

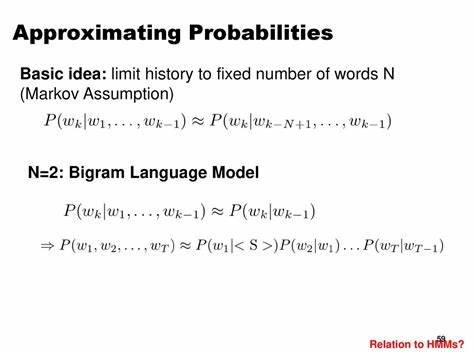

Фундаментальная цель восстановления данных из весов заключается в поиске такого набора текстов, который по своим характеристикам наилучшим образом отражает информацию, заложенную в параметрах модели. Весы нейросети, с одной стороны, представляют собой математическое описание обученного знания, а с другой — информируют о специфике и распределении исходного материала. Следовательно, правильный метод аппроксимации способен выявить максимально релевантные фрагменты текстов из обширных публичных корпусов и даже приблизить модель к ее изначальному уровню качества. Ключевым достижением в этом направлении стало формализация проблемы аппроксимации данных с помощью весов модели, что позволило определить задачи оценки и сравнения различных подходов. Среди предложенных методов особое место занимают градиентные алгоритмы, которые изучают, как изменения весов влияют на ошибку при обучении и ищут тексты, способные оптимально воспроизвести эти изменения.

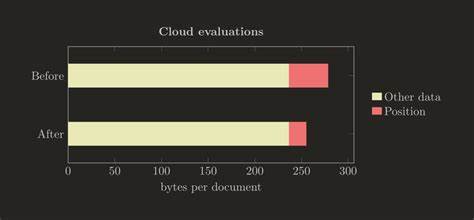

Благодаря этим алгоритмам удалось разработать эффективные стратегии выбора тренировочных примеров из больших открытых корпусов, которые оказываются максимально приближены к истинному распределению исходных данных. Практическое применение таких методов продемонстрировало впечатляющие результаты. Например, при работе с задачей классификации новостей на основе корпуса AG News удалось улучшить точность модели с 65% при случайном подборе данных до 80%, что почти достигает экспертного уровня в 88%. Это говорит о мощности алгоритмов аппроксимации и их потенциале для оптимизации обучения и анализа языковых моделей. Кроме того, методика успешно применялась к случаям дообучения моделей с использованием специфических веб-документов, что позволило снизить перплексию с 3.

3 до 2.3, приближаясь к показателям ведущих специализированных моделей. Такой прогресс открывает новые перспективы для исследователей и разработчиков. Возможность повторно использовать или реконструировать тренировочные данные облегчает процессы проверки моделей, улучшает их интерпретируемость и способствует развитию этических стандартов, связанных с прозрачностью и пониманием искусственного интеллекта. Более того, методика аппроксимации может быть инструментом для создания более адаптированных и эффективных моделей, особенно там, где закрытые данные становятся барьером для развития.

Тем не менее, данное направление находится в активной фазе исследований и сталкивается с определенными вызовами. Вопросы точности восстановления, вычислительной сложности и обобщаемости методов требуют дополнительного изучения и совершенствования. К тому же необходимо учитывать правовые и этические ограничения, связанные с обработкой и воспроизведением обучающих данных. Несмотря на это, современные результаты демонстрируют высокий потенциал и уже сегодня оказывают значительное влияние на практическую сторону разработки языковых моделей. В итоге, аппроксимация тренировочных данных языковых моделей по их весам — это новый, многообещающий подход, который обогащает наше понимание работы искусственного интеллекта.

Применение градиентных алгоритмов и других современных методов позволяет эффективно восстанавливать релевантные данные, улучшать качество моделей и расширять возможности их использования. Текущие успешные эксперименты и перспективы развития делают эту тему одной из ключевых для будущих исследований и прикладных решений в области обработки естественного языка и машинного обучения.