Современный мир искусственного интеллекта развивается с ошеломляющей скоростью, при этом ежедневно появляются новые революционные модели и инструменты генеративного ИИ. Однако именно быстрый рост и стремление к инновациям привели к тому, что фундаментальные архитектурные паттерны, обеспечивающие стабильность и масштабируемость таких систем, пока остаются на зачаточном уровне. Сегодня мы сталкиваемся с серьезным разрывом между возможностями моделей и прослойкой инфраструктуры, на которой они работают. Именно эти пробелы мешают масштабированию и безопасному развертыванию AI в ответственных отраслевых задачах, таких как медицина, финансы или юриспруденция. Отсутствие четко определённых архитектурных решений создает собой «белые пятна» — критические области, требующие немедленного внимания и стандартизации.

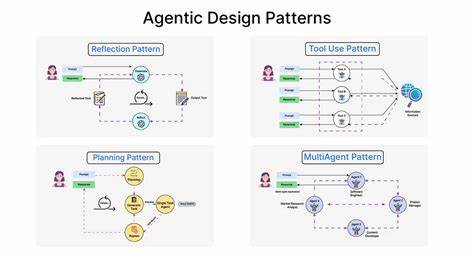

Начнем с того, что современная индустрия генеративного ИИ сформировалась стремительно и зачастую импровизационно. На пути от простых чат-ботов к автономным агентам и системам, способным принимать важные бизнес-решения, разработчики часто обходят стороной базовые архитектурные принципы, которые за десятилетия зарекомендовали себя в традиционном ПО. Появилась необходимость заполнить этот пробел, создав новые паттерны, специфичные для AI-сред, соответствующие высоким требованиям надежности, безопасности и оперативности. Одной из основных проблем является недостаток средств для детального отслеживания генерации контента на уровне отдельных токенов и мониторинга производительности в многоагентных системах. В традиционном программировании мы привыкли к развитым системам трассировки и логирования, позволяющим быстро и точно находить причины сбоев.

В генеративном ИИ же отладка зачастую сводится к примитивным логам, что серьезно затрудняет управление сложными цепочками вызовов и оптимизацию затрат. Появление открытых стандартов в области трассировки позволит создавать инструменты, аналогичные Grafana, но ориентированные именно на AI-разработку. Обеспечение безопасности AI-систем также требует стандартизации. Несмотря на рост интереса к вопросам устойчивости моделей к атакам, таких как инъекция промптов или отравление данных, пока нет универсальных инструментов для комплексного тестирования. Создание специализированных наборов для красного тестирования и пентестинга поможет выявлять уязвимости систем до момента внедрения и минимизировать риски в продакшене.

Проектирование таких решений на примере популярных стандартов в области информационной безопасности позволит наладить отраслевую практику. Неразрывно связана с этим и проблема согласованности работы многоагентных систем, когда последовательность действий необходима для корректного результата. В нынешнем виде многоуровневые AI-процессы сталкиваются с нестабильностью, когда агенты дублируют операции или теряют связь с контекстом диалога. Инновационные паттерны, подобные транзакциям из баз данных, помогут гарантировать идемпотентность и сохранение целостности обработки запросов, что жизненно важно для коммерческого применения. Еще одним серьезным архитектурным вызовом является отсутствие решений по резервному копированию и восстановлению состояния AI-сессий.

При сбоях AI-системы обычно начинают работу заново, теряя всю накопленную информацию и контекст, что ведет к потере времени и вычислительных ресурсов. Разработка механизмов моментальных снимков состояний и возможности их восстановления позволит построить устойчивые системы и минимизировать простой. Системы, основанные на векторных базах данных, сталкиваются с проблемой миграции при обновлении моделей эмбеддингов. Поскольку семантическое представление данных меняется с ростом качества моделей, отсутсвие адекватных инструментов для перехода между версиями без полной переработки индексов часто приводит к высоким затратам и потерям производительности. Решения в духе «Flyway для эмбеддингов» предоставят разработчикам возможность плавно адаптировать свои базы под новые модели, сохраняя совместимость и семантическую целостность.

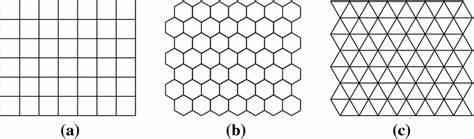

Помимо оптимизации отдельных моделей, важна надежность итоговых ответов в случае использования нескольких моделей одновременно. Несогласованность результатов и вариативность ответов затрудняют принятие критически важных решений. Для этого необходимы механизмы коллективного консенсуса, которые позволят согласовывать выводы и получать более устойчивый и проверенный результат. Разработка алгоритмов распределенного консенсуса для AI-систем поможет сформировать новые стандарты качества. В масштабировании баз данных на основе эмбеддингов требуется новая парадигма — семантический шардинг.

Простое разделение данных по традиционным критериям не может обеспечить необходимую связанность и качество поиска, так как эмбеддинги характеризуются сложной многомерной природой. Анализ и разделение данных с учетом семантических доменов позволит обеспечивать высокую производительность и точность в условиях роста объема данных. Наконец, динамическое интегрирование AI в бизнес-процессы остается сложной технической задачей. Существующие BPM-системы не рассчитаны на работу с агентами, способными адаптироваться к изменению контекста и результатам в реальном времени. Необходимо разработать архитектурные паттерны, позволяющие бесшовно интегрировать AI-агентов с управлением процессами, что откроет новые возможности для автоматизации и оптимизации рабочих потоков.

Все эти вызовы имеют особую важность именно сегодня, поскольку многие организации переходят от экспериментальных AI-проектов к масштабным промышленным развертываниям. Без прозрачных стандартов и архитектурных соглашений растет риск «закрытия» рынка под контролем нескольких крупных производителей, снижается скорость внедрения инноваций и усиливаются проблемы с квалификацией специалистов. Параллельно растут требования регуляторов, требующих прозрачности, отслеживаемости и объяснимости действий AI, что невозможно без надежной платформы. Ярким примером успешного стандартизационного прорыва стала инициатива по Model Context Protocol, которая всего за несколько недель получила широкое внедрение благодаря простоте реализации, открытости и универсальности. Аналогичный подход можно применить к каждому из описанных архитектурных пробелов.

Важно стремиться к разработке легковесных, простых в освоении и расширяемых паттернов, которые могут быстро стать отраслевым стандартом. Возможность влиять на формирование архитектуры AI-систем открыта для всех — от независимых разработчиков до крупных компаний и исследовательских групп. Путь к устойчивому и масштабируемому будущему искусственного интеллекта лежит через сотрудничество, обмен опытом и приоритетное внимание к инфраструктурным решениям, а не только к моделям. Вопрос лишь в том, кто и когда возьмет на себя ответственность за создание этих архитектурных опор. Сейчас настал момент остановиться и задуматься: продолжать ли создавать систему на нестабильных и фрагментарных основах, пытаясь закрыть трещины рабочими обходными путями, или же именно мы станем теми, кто сформирует надежные, проверенные временем паттерны, на которых будет строиться будущее AI? От этого выбора зависит не только эффективность сегодняшних проектов, но и общий уровень доверия общества к искусственному интеллекту.

Обсуждение этих тем и активное участие в формировании новых стандартов — долг каждого, кто заинтересован в развитии AI. Вызовы есть, и они действительно масштабны, но вместе мы можем создать архитектуру, которая позволит AI-решениям раскрыть весь их потенциал и стать действительно надежными помощниками в бизнесе и жизни.