В современном мире искусственный интеллект (ИИ) становится неотъемлемой частью повседневной жизни. От диагностики заболеваний до управления транспортными системами - автономные алгоритмы стремительно вживаются в самые разные сферы. Однако за комфортом и новыми возможностями скрываются вопросы контроля, доверия и прозрачности, особенно когда речь заходит о военном происхождении этих технологий. Одним из ключевых игроков в разработке автономного ИИ является Агентство перспективных оборонных научно-исследовательских проектов США, известное как DARPA. Хотя DARPA давно признана ведущей организацией в создании инновационных технологий, ее роль в формировании автономных систем вызывает растущие опасения в отношении открытости и демократии.

DARPA не только разрабатывает новые военные решения - многие из этих разработок в конечном итоге применяются в гражданских технологиях, которые мы используем ежедневно. История агентства связана с изобретением интернета, GPS и систем распознавания голоса - технологий, которые изменили мир. Сегодня DARPA активно инвестирует в автономные системы на базе ИИ, способные принимать решения без непосредственного контроля человека. Это вызывает необходимость серьезного общественного диалога о том, каким образом такие системы создаются, какие существует гарантии безопасности и какие последствия ожидают нас, когда военные технологии переходят в гражданскую плоскость. Одной из ключевых особенностей деятельности DARPA является направление по обеспечению автономности, доверия и сотрудничества человека с ИИ.

В это направление входят проекты, нацеленные на быстрый прототипинг в различных областях, разработку надежных систем, работающих с минимальным участием человека, а также изучение механизмов самосознания машин, которые способны осознавать свои ограничения. Такие исследования не ограничиваются военными целями. Напротив, все достижения DARPA постепенно интегрируются в коммерческие продукты и сервисы, стирая границы между военным и гражданским применением. Очень важным аспектом, который вызывает множество вопросов, является проблема доверия. Исследования агентства помогают определить, как объяснять логику решений ИИ, как строить доверие к автономным системам и какие пределы автономности должны соблюдаться, чтобы избежать опасных последствий.

Эти концепции влияют не только на боевые дроны, но и на голосовых помощников, системы автономного транспорта, медицинское программное обеспечение и многое другое. Именно поэтому растет требование открытости и подотчетности со стороны DARPA. Через механизм запросов по Закону о свободе информации (FOIA) активисты и исследователи стараются получить доступ к деталям, касающимся архитектуры автономных систем, моделей принятия решений, протоколов контроля и этических норм, которые используются внутри агентства. Прозрачность также важна для понимания того, как именно военные технологии передаются компаниям гражданского сектора. Двойное использование - когда изначально военные разработки находят применение в гражданской жизни - несет серьезные риски.

Автономные системы, отсутствие должного контроля и недостаточная регуляция могут привести к последствиям, которые выйдут за рамки первоначальных замыслов. Например, алгоритмы, способные самостоятельно принимать решения, уже применяются в медицинской диагностике, транспортных сетях, финансовых рынках и модерации контента в интернете. Все это требует пересмотра существующих норм и введения демократического контроля. Важно понимать, что развитие автономного ИИ финансируется за счет общественных средств, а его конечные результаты влияют на жизнь каждого человека. При этом существующие правила регулирования не всегда способны обеспечить должную подотчетность разработчиков и пользователей таких систем.

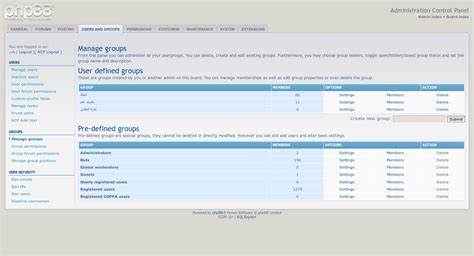

Существуют серьезные пробелы между военными и гражданскими рамками регулирования технологий с двойным назначением. Анализ работы DARPA в связке с Национальным институтом стандартов и технологий (NIST) и Национальным научным фондом (NSF) показывает, что именно эти организации формируют стандарты и рамки классификации поведения ИИ. При этом академическая и военная научно-исследовательская деятельность тесно связаны и синергично поддерживают развитие автономных систем. Важно выстроить механизм, который обеспечит общественный контроль над этими процессами, делает прозрачными принципы проектирования и внедрения технологий, и дает возможность открытого обсуждения рисков и преимуществ автономного ИИ. Демократический надзор требует участия как разработчиков, так и конечных пользователей, а также представителей общества, чтобы определить допустимые границы применения автономного ИИ, соблюдая баланс между инновациями, безопасностью и правами человека.

Несмотря на определенные опасения, развитие искусственного интеллекта остается неизбежным и необходимым. Главное - обеспечить, чтобы технологии создавались и применялись с учетом морально-этических норм и права общества на информированность. Автономные системы уже сегодня принимают решения, влияющие на жизнь миллионов людей - в здравоохранении, транспорте, финансах и социальных сервисах. Именно поэтому настало время потребовать от DARPA прозрачности, чтобы каждый мог понять, как и зачем создаются эти алгоритмы. Демократия не может заканчиваться там, где начинается автономия машин.

Открытость и подотчетность станут залогом того, что искусственный интеллект будет служить обществу, а не превращаться в инструмент, управляемый лишь узким кругом заинтересованных лиц. Вызовы, связанные с автономными системами, требуют совместных усилий ученых, законодателей, активистов и простых граждан. Только через диалог и контроль можно выработать эффективные механизмы регулирования, которые сделают развитие ИИ безопасным и прозрачным. Будущее уже наступило, и именно сегодня мы должны определить правила игры для технологий, которые будут формировать наш мир завтра. .