В последние годы компании по всему миру активно инвестируют в развитие искусственного интеллекта, совершенствуя алгоритмы и создавая мощные модели машинного обучения. Одним из заметных игроков на этом поле стала корпорация Apple, которая объявила о запуске новой опциональной программы обучения собственных AI-моделей с использованием пользовательских данных, получаемых с iPhone. Эта инициатива получила название Radar AI Training и вскоре вызвала серьезные обсуждения и вопросы вокруг конфиденциальности, методов сбора информации и прозрачности использования пользовательских данных. Традиционно Apple позиционирует себя как компания, серьезно заботящаяся о защите приватности пользователей. Поэтому новый шаг, позволяющий использовать контент прямо с устройств для обучения искусственного интеллекта посредством технологии Differential Privacy (дифференциальной приватности), привлек внимание как специалистов, так и широкой аудитории.

Обучение происходит непосредственно на устройствах пользователей, что, по мнению компании, снижает риски утечки информации и позволяет обеспечить высокие стандарты безопасности. Принцип работы Differential Privacy заключается в добавлении специального шума к данным, чтобы сделать невозможной идентификацию индивидуальных пользователей в наборах обучающих данных. Это обеспечивает формальное математическое гарантийное подтверждение сохранения конфиденциальности пользователей даже при активном использовании их информации для масштабных моделей искусственного интеллекта. Но, несмотря на эти меры, нововведение не обошлось без критики. Ключевым каналом обновленного взаимодействия между Apple и разработчиками является приложение Feedback Assistant — инструмент, через который программисты и тестировщики прямо сообщают компании о найденных ошибках и проблемах.

Однако недавние изменения в правилах отправки отчетов о багах вызвали настоящий резонанс. Сейчас при прикреплении файлов с диагностической информацией, таких как системные логи sysdiagnose, пользователю необходимо давать согласие на использование отправленных материалов для обучения AI-моделей Apple Intelligence. Данная поправка была воспринята неоднозначно. Многие эксперты и отдельные разработчики выразили возмущение из-за того, что подобное использование чувствительных данных происходит без четкого и удобного варианта отказа, и что информация, предоставляемая с хорошими намерениями для решения конкретных технических проблем, теперь становится инструментом сбора данных для глобальной тренировки ИИ. Отзывы разработчиков и пользователей достаточно строгие.

Они подчеркивают, что диагностика устройств содержит массу персональной и деликатной информации, и смешение ее с большими тренинговыми наборами вызывает вопросы к этике и уважению к приватности. Некоторые предлагают вместо того, чтобы рисковать раскрытием приватных данных, использовать специально подготовленные чистые тестовые машины при отправке таких отчетов. Кроме того, возникли недовольства и касательно того, как Apple обрабатывает полученные от сообщества баг-репорты. Многие считают, что ответственность за исправление проблем недостаточно очевидна, часть сообщений остаются без обратной связи, а обновления по статусу задач часто не приходят. Разработчики отмечают, что иногда компания вроде бы формально реагирует асинхронно, направляя запросы о подтверждении проблемы, однако реального решения или улучшения часто не происходит длительное время.

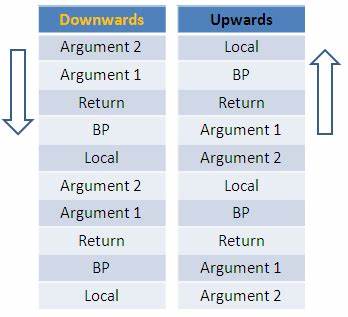

Система внутреннего трекинга багов в Apple, известная под условным названием Radar, по словам участников сообщества, работает по схеме автоматического тегирования и сопоставления багов с релизами и исправлениями. Тем не менее, в реальности фильтры и теги не всегда срабатывают корректно, а некоторые баги долго остаются без внимания. Это вызывает раздражение у активных пользователей, которые вкладывают значительные усилия в сбор и подробное описание ошибок. Акцентированное внимание на взаимодействии с сообществом и стремление к максимальной приватности расширяет фронт дискуссий вокруг этики использования данных для AI. Противоречие между инновационными технологическими возможностями и сохранением прав пользователей на конфиденциальность становится центральным фактором, определяющим развитие индустрии.

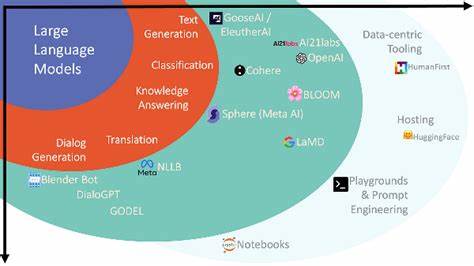

Apple же со своей стороны подчеркивает, что предоставляет пользователям возможность участия в программе на добровольной основе и старается обеспечить высокий уровень защиты их данных. При этом компания продолжает разработку технологии Differential Privacy, которая должна свести риски разглашения к минимуму, и работает над улучшением коммуникаций с сообществом. Однако вопрос прозрачности и четких гарантий безопасности остается открытым. На фоне этих событий важно понимать, что использование разнообразных данных для обучения современных AI-моделей становится в скором времени стандартом. Компании, занимающиеся ИИ, нуждаются в большом объеме фактической информации, чтобы совершенствовать алгоритмы.

В этой связи репортажи о багах и системных сбоях — одно из ценных источников таких данных. Но вместе с тем стоит помнить о необходимости разумного баланса между технологическим прогрессом и неприкосновенностью частной жизни. Стоит отметить и то, что критика, которую высказывают разработчики и пользователи относительно практик Apple, в значительной мере отражает тенденции в всей индустрии программного обеспечения. Многие организации сталкиваются с вызовами доверия со стороны аудитории, которая хочет быть уверена в том, что ее вклад не будет использован вопреки первоначальным ожиданиям. Подытоживая, внедрение Radar AI Training демонстрирует развитие искусственного интеллекта и его интеграцию в экосистему Apple, но при этом ставит в центр внимания сложные аспекты этики, приватности и взаимодействия с сообществом.

Для конечных пользователей ключевым станет право выбора участвовать или не участвовать в подобного рода программах, а также прозрачные и понятные условия оплаты и использования их данных. В будущем можно ожидать дальнейшие изменения и корректировки программ Apple, направленные на повышение доверия и удобства пользователей. Возможно появление дополнительных опций контроля, расширение объяснительных механизмов и усиление защиты конфиденциальной информации. Для специалистов и разработчиков же важно оставаться внимательными к нововведениям, активно взаимодействовать с компаниями и совместно искать решения, которые позволят объединить достижения AI с уважением к правам и пожеланиям сообщества. Развитие Radar AI Training — пример того, как современные технологии требуют не только технического мастерства, но и ответственности перед пользователями.

Именно в этом балансе и заключается будущее эффективного и этичного развития искусственного интеллекта на благо общества.