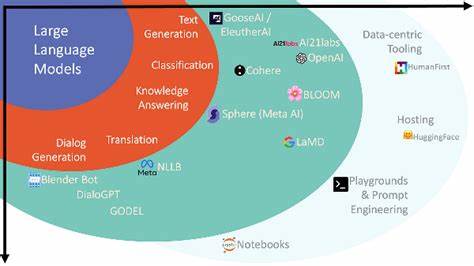

В последние годы большие языковые модели (LLM) стали неотъемлемой частью множества приложений в области обработки естественного языка. Их способность понимать и генерировать текст на высоком уровне открывает новые горизонты для решения различных задач, включая классификацию текстовых данных. Однако при попытках использовать LLM для пакетной классификации возникает ряд специфических сложностей, которые неочевидны на первый взгляд и требуют внимательного анализа. Что такое пакетная классификация и почему она важна? Пакетная классификация подразумевает обработку сразу нескольких объектов текста в одном запросе к модели, что позволяет значительно повысить скорость и эффективность работы. В традиционных методах машинного обучения такая задача решается довольно просто — модель независимо анализирует каждый элемент из набора данных, возвращая результат классификации для каждого из них.

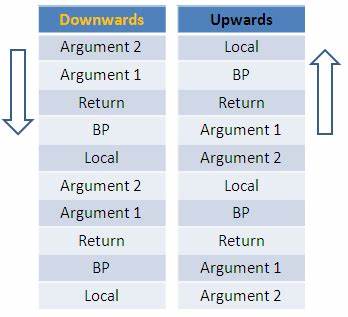

Однако в случае с большими языковыми моделями ситуация оказывается не столь тривиальной. Одной из ключевых проблем при попытке использовать LLM для пакетной классификации становится влияние соседних примеров внутри одного запроса друг на друга. Пользователь, который пытался классифицировать сразу десять текстов в одном промпте, заметил, что результат классификации для каждого отдельного текста зависел от того, какие именно другие примеры были включены в запрос. Иными словами, модель не выполняет обработку каждого текста строго изолированно, а учитывает контекст всей предоставленной информации, что приводит к нежелательному смешению данных и искажению итогового результата. Отсюда возникает вопрос: является ли такое поведение моделью ограничением, присущим архитектуре LLM? Большинство современных языковых моделей разработаны для генерации отвечающего на входной запрос текста с учетом всего контекста, в том числе и соседних запросов внутри одного промпта.

Поэтому ожидать полностью независимого анализа каждого текста при пакетной обработке чаще всего не приходится. В отличие от классических алгоритмов машинного обучения, где каждое наблюдение обрабатывается независимо, LLM стремятся эмитировать контекстуальную связанность и семантические взаимоотношения между входными данными, что часто идет во вред при необходимости независимой классификации. Опыт пользователей подтверждает подобные ограничения. Например, некоторые разработчики пытались передавать большие объемы данных по частям, используя последовательные сообщения и указывая модели обрабатывать каждый фрагмент независимо. Однако в этих случаях контекст в конечном итоге накапливается, и модель начинает смешивать информацию из разных элементов, что приводит к росту ошибок и необходимости вручную корректировать выводы.

В итоге такие попытки часто приводят к отказу от автоматизации и переходу к ручной обработке, что явно снижает эффективность работы с LLM. С другой стороны, разработчики и исследователи отмечают, что при использовании низкоуровневых библиотек или непосредственно при работе с вычислительными ресурсами на уровне нейросети существует возможность пакетной обработки данных. Это достигается за счет параллельной обработки нескольких запросов или батчирования на уровне инференса, то есть вычислений модели. Примером может служить технология vLLM, которая оптимизирует запросы округляя их в пакеты для ускорения вычислений без потери качества. Такое решение позволяет значительно сократить время обработки больших объемов текста за счет эффективного использования ресурсов без изменения логики работы самой модели.

Несмотря на это, с точки зрения простого пользователя или разработчика, использующего стандартные API, пакетная классификация с полностью независимым результатом для каждого текста обычно недоступна. Платформы, предоставляющие доступ к LLM, нацелены на максимальное удобство взаимодействия и обработку запросов в формате диалога или генерации текста, что ограничивает возможности изоляции каждого элемента классификации внутри одного вызова. Какие же выходы из ситуации может предложить разработчик, столкнувшийся с необходимостью кластерной классификации большими языковыми моделями? Первый и очевидный путь — обращаться к классификации по одному элементу, повторяя вызов LLM для каждого текста отдельно. По сравнению с массовой обработкой, такой метод может показаться менее эффективным по времени и ресурсам, но с точки зрения качества и точности результатов он пока что остается оптимальным. Параллелизация таких запросов при наличии достаточного числа вычислительных мощностей помогает частично компенсировать рост времени работы.

Другой подход связан с комбинированием LLM с классическими инструментами машинного обучения. Можно использовать традиционные модели для предварительной классификации и фильтрации, а потом подключать LLM для уточнения или анализа более сложных кейсов. Такой гибридный подход помогает загружать языковую модель только там, где это действительно необходимо, уменьшая нагрузку и повышая стабильность работы. Также в некоторых случаях оказывается эффективным построение кастомных промптов, которые минимизируют влияние соседних запросов внутри одного батча. При очень тщательном оформлении инструкции и разметке примеров можно добиться приемлемого уровня независимости классификаций.

Однако такой метод остается экспериментальным и не гарантирует стабильных результатов при большой вариативности данных. В будущем можно ожидать появления новых архитектур LLM и оптимизированных API, которые будут предлагать более продвинутую поддержку пакетной обработки с независимыми результатами. Кроме того, развитие технологий, таких как distillation и fine-tuning, способствуют созданию более специализированных моделей, способных эффективно работать в задачах классификации с минимальным вмешательством человека. Подводя итог, можно сказать, что большие языковые модели на текущем этапе обладают огромным потенциалом, но имеют свои ограничения, связанные с контекстуальной природой своей работы. Пакетная классификация с независимым анализом каждого элемента пока что остается проблематичной и требует либо использования отдельных вызовов для каждого текста, либо применения специальных методик оптимизации и гибридных моделей.

Важно учитывать эти нюансы при проектировании систем, где требуется обработка больших объемов текстовой информации, чтобы добиться баланса между скоростью, качеством и ресурсозатратами. Такой осознанный подход поможет максимально эффективно использовать возможности LLM в современных задачах анализа и классификации текстов.