Большие языковые модели (Large Language Models, LLM) стали настоящим прорывом в области искусственного интеллекта за последние несколько лет. Они нашли применение в поисковых системах, виртуальных помощниках, автоматическом написании кода, создании текстов и даже в мессенджерах. Однако, несмотря на широкую популярность и множество способов их использования, вокруг них существует множество мифов и недоразумений. Понять, как на самом деле работают такие модели, крайне важно для правильного восприятия их возможностей и ограничений. Более того, это помогает определить их уместность в различных сферах и не возлагать на них завышенных ожиданий.

Зачастую общение с чат-ботами, построенными на основе LLM, создает иллюзию живого диалога с осознанным собеседником. Кажется, что модель понимает вопрос, запоминает предыдущие реплики и способна отвечать с учетом контекста, как настоящий человек. На самом деле, принципы работы этих моделей существенно отличаются от человеческого мышления. Фактически, LLM — это алгоритмы, научившиеся предсказывать наиболее вероятные продолжения текста на основе огромного объема информации из интернета и других источников. Одна из распространенных ошибок — предположение о том, что модель «держит» разговор так, будто она осознает свою роль и пользователя.

Однако LLM на самом деле просто строит следующий фрагмент текста, опираясь на последовательность символов и слов, переданных ей в данный момент. Она не имеет собственного сознания и не различает «я» и «ты» как людей, просто предсказывает последовательность, которая с наибольшей вероятностью продолжит ввод. Когда пользователь вводит текст, например вопрос или просьбу, фактический вход для модели не является просто символами или словами. Перед обработкой текст необходимо разбить на токены — небольшие смысловые единицы, частично похожие на слова или их части. Каждый такой токен переводится в числовой вектор — набор чисел, которые отражают семантическое содержание слова с учетом контекста.

Это позволяет модели работать с текстом как с пространством чисел, где близость векторов означает схожесть значений. Понимание, что языковая модель работает с такими векторными представлениями помогает объяснить некоторые ее странности и ошибки. Например, иногда модели сложно точно посчитать количество повторений букв или символов в слове, что связано с тем, что она оперирует токенами, а не отдельными символами. Векторные представления часто строятся с использованием методик, базирующихся на соседстве слов в больших наборах текстов: слова, которые встречаются в похожем контексте, имеют близкие вектора, что объясняет, почему модели редко путают смысл слов, даже если они схожи. Результатом работы LLM никогда не является напрямую текст, а распределение вероятностей всех возможных токенов, которые могут последовать за текущей последовательностью.

Модель вычисляет, какие слова или символы наиболее вероятны для продолжения, но окончательный выбор конкретного слова делают специальные алгоритмы, называемые методами декодирования. Параметр, известный как «температура», управляет разнообразием результатов: низкая температура приводит к более предсказуемым и формальным ответам, высокая — к более творческим и разнообразным, но иногда и ошибочным. Длинные ответы в чатах с моделями формируются постепенно: каждый новый токен добавляется к предыдущему тексту и передается в модель снова для предсказания следующего шага. Этот процесс называется автогрессивным декодированием и объясняет, почему ответы появляются на экране постепенно, слово за словом. Такой подход имеет смысл, поскольку генерировать сразу весь текст крайне ресурсоемко, а потоковое отображение позволяет быстрее получать первые части ответа.

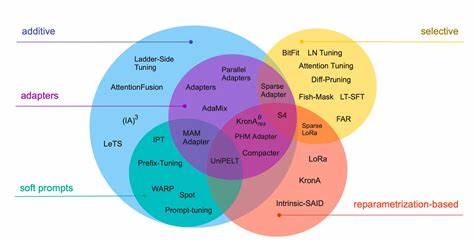

Все способности моделей — от генерации стихов до написания программного кода и перевода — возникают из одного основного обучения: предсказанию следующего слова. Эта задача кажется простой, но требует обработки огромного количества данных и сложных вычислительных операций. Модель получает примеры текста, где одно слово пропущено, и учится угадывать его, минимизируя ошибку между своей догадкой и реальным ответом. Этот процесс называется предтренировкой и сопровождается использованием сложных математических методов, таких как обратное распространение ошибки и оптимизация параметров с помощью градиентов. После основной предтренировки модель дополнительно адаптируют с помощью тонкой настройки, которая использует специальные наборы текстов, оформленных как диалог между пользователем и помощником.

Эти данные помогают модели лучше имитировать общение в чате и отвечать более полезно и релевантно. Результаты этой настройки делают взаимодействие с ИИ более приятным и продуктивным. Следующая ступень обучения — усиление с подкреплением на основе обратной связи от человека, когда отдельные ответы моделям оцениваются людьми, и эти оценки служат сигналами для улучшения поведения ИИ. Благодаря этому модель становится лучше в соблюдении инструкций и избегает неподходящих или ошибочных ответов. Очень важным и часто недооценённым ограничением LLM является их «амнезия».

Модель не способна запоминать информацию после завершения обучения. Каждое взаимодействие с ней — это изолированное событие, где память о предыдущих сообщениях поддерживается только благодаря тому, что эти сообщения повторно включаются в текущий ввод. Эффективное ведение беседы требует, чтобы вся история объединялась и подавалась в качестве единой последовательности токенов. Однако длина такой истории ограничена размером контекстного окна модели, которое может варьироваться от нескольких тысяч до миллиона токенов, в зависимости от конкретной архитектуры. С ростом количества сообщений в диалоге, объем данных, необходимых для отслеживания контекста, увеличивается линейно, что приводит к экспоненциальному росту вычислительных затрат без специальных оптимизаций.

Если же история превышает размер контекстного окна, модель перестает видеть самые ранние сообщения, что негативно сказывается на качестве ответов. Модель становится как герой фильма «50 первых поцелуев», который каждый день просыпается, не помня событий вчерашнего дня. Чтобы вести нормальную жизнь, герою приходится смотреть видео с воспоминаниями. Аналогично, чтобы ИИ «помнил» контекст, ему надо постоянно подавать переписку с самого начала, что технически обеспечивается внешним программным обеспечением и буферами памяти, а не самим языковым ядром. В результате все впечатляющие возможности диалоговых ИИ — это не признаки сознания или понимания, а строго статистические предсказания, основанные на анализе языковых структур из трендовых текстов, которые модель видела при обучении.

Знания модели ограничены моментом окончания обучения, и она не может самостоятельно обновлять информацию о мире, например, сегодняшний день или текущие события. Современные интерфейсы стараются сгладить этот недостаток, добавляя механизмы внешней памяти и обработки новых данных вне модели. Такие решения повышают удобство использования и эмуляцию эволюции ИИ, но важно помнить, что это вспомогательные функции, а не способности самой модели. Понимание настоящих принципов работы больших языковых моделей помогает оценить их место в современной технологии и избежать чрезмерных ожиданий. Они способны очень эффективно работать с текстовыми данными благодаря сложным математическим представлениям и статистическому обучению, но, при этом, они не обладают самостоятельным мышлением, воспоминаниями или пониманием в привычном человеческом смысле.

В будущем исследования в области самоадаптации и непрерывного обучения могут привести к новым версиям моделей, способных динамически обновлять свои знания, однако на сегодняшний день LLM остаются статичными системами. Они играют роль мощных инструментов, расширяющих возможности людей в работе с информацией и творчестве, а не самостоятельных интеллектуальных сущностей. Итак, развенчивая популярные мифы о больших языковых моделях, становится ясно, что это сложные статистические машины, работающие на основе анализа огромного объема текстов, использующие высокоразмерные векторные представления и предсказывающие вероятные продолжения, а не осознающие и запоминающие «живые» существа. Понимание этих реалий критично как для разработчиков, так и для пользователей ИИ, чтобы конструктивно и ответственно применять технологии и избегать обманчивых иллюзий.