Современный мир цифровых технологий переживает настоящий бум в области искусственного интеллекта, и в основе многих передовых решений лежат большие языковые модели (Large Language Models, LLM). Однако развитие AI-систем не ограничивается лишь использованием этих моделей. От базовых применений LLM до сложных автономных искусственных агентов проходит сложный путь, связанный с ростом функционала, усложнением архитектуры и увеличением возможностей. Понимание этого пути крайне важно для тех, кто планирует интегрировать искусственный интеллект в свои бизнес-процессы или просто интересуется развитием передовых технологий. В рамках этой статьи мы подробно рассмотрим стадии эволюции AI-систем на примере типичного применения – автоматизированного анализа резюме для HR-отделов, а также дадим рекомендации по выбору оптимального подхода в зависимости от задач и ресурсов.

В самом начале стоит выделить чистую большую языковую модель. Это результат обучения на огромных объемах текстовых данных, обычно охватывающих разнообразные темы из интернета и других источников. Такие модели способны выполнять задачи, основанные на накопленных знаниях: они умеют генерировать тексты, писать сочинения, объяснять сложные концепции на доступном языке, преобразовывать идеи в поэтическую форму. Все это делает их крайне полезными для создания контента, ответов на вопросы и поддержки пользователей. Но у чистых LLM есть фундаментальное ограничение – они не имеют доступа к актуальной информации или внутренним данным конкретной организации.

Например, при запросе текущей погоды в городе или информации о конкретном кандидате, они не смогут дать достоверного и свежего ответа. Для решения подобных ограничений на помощь приходят методы Retrieval Augmented Generation (RAG) — технологии, расширяющие возможности LLM за счет интеграции механизма поиска и извлечения релевантных данных в реальном времени. RAG позволяет получить доступ к разнообразным источникам информации, включая внутренние базы данных компании, актуальные документы, справочники и прецеденты. Это не просто расширение контекстного окна модели, а обеспечение живого взаимодействия с источниками, актуальными на конкретный момент времени. В рамках HR-систем, к примеру, использование RAG дает возможность анализировать актуальные кадровые политики, стандарты оценки и историю схожих вакансий, что значительно повышает качество автоматической классификации и отбора резюме.

Продолжая развитие функционала, на следующую ступень выходит концепция использования инструментов и построения AI-воркфлоу (AI Workflow). Такая система сочетает сильные стороны LLM и специализированных программных интерфейсов (API), позволяя автоматизировать бизнес-процессы с четко определенными и повторяемыми этапами. Здесь AI не располагает полной свободой действий, как в случае агента, но способен выполнять сложные задачи по заранее заданной логике и взаимодействовать с внешними сервисами. В HR-примере, это может выражаться в последовательном получении и анализе резюме, сравнении с критериями вакансии, а также отправке уведомлений кандидатам посредством электронной почты или SMS. Значительно экономится труд HR-специалистов, а процесс становится более прозрачным и прогнозируемым.

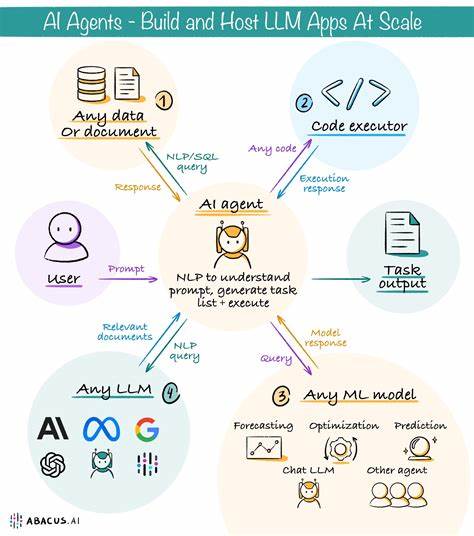

Важным элементом становится надежность и отказоустойчивость, так как для успешной работы необходимо уверенное выполнение всех этапов в тех же условиях, в которых работает система – от баз данных до почтовых сервисов. Значительным шагом вперёд становятся искусственные агенты – AI Agents, способные не просто выполнять заранее определённые операции, а принимать решения самостоятельно. Эти системы уже обладают сложными механизмами планирования, анализа промежуточных результатов, адаптации стратегий и взаимодействия с внешними инструментами не по жесткому сценарию, а динамично, исходя из обстоятельств. Агенты агрегируют логику и автономию, позволяя системам самостоятельно определять следующий шаг, запрашивать помощь человека, хранить данные или менять последовательность действий. В сфере подбора персонала это может выглядеть как самостоятельное управление всеми этапами: от анализа резюме до координации собеседований путем общения с кандидатами, изменения расписаний и уведомления участников.

Для реализации таких возможностей AI агентам необходим доступ к множеству API и систем – календарям, почте, мессенджерам, базам данных и внутренним справочникам. Главное преимущество здесь — высокая степень автоматизации, которая снижает нагрузку на сотрудников и снижает человеческие ошибки. Однако появление агента не означает, что все задачи должны решаться с его помощью. Современный опыт показывает, что в ряде случаев простые решения на основе RAG или AI Workflow достаточно и даже предпочтительнее. Сложные автономные системы требуют значительных ресурсов на разработку, тестирование и поддержку.

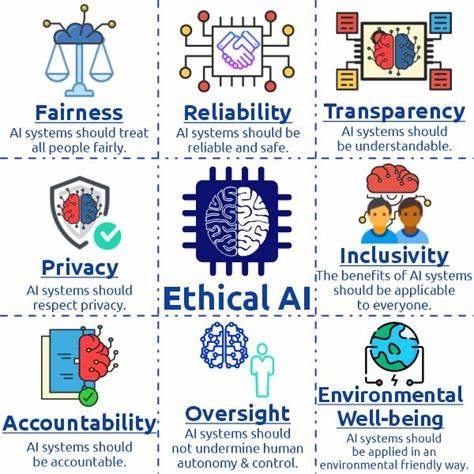

Помимо технических трудностей существенное внимание необходимо уделять надежности из-за вероятности ошибок в нелинейных решениях. Создание масштабируемого и предсказуемого AI-агента требует не только передовых технологий, но и тщательного продумывания архитектуры, внедрения методов контроля и обеспечения безопасности. Вывод из этого достаточно очевиден – выбор архитектуры AI-системы должен определяться конкретными бизнес-задачами, уровнем требуемой автономии, доступными ресурсами и необходимой степенью надежности. Важно начать с простых, но проверенных подходов, которые можно последовательно развивать и масштабировать. В условиях, когда задачи и данные четко структурированы, применения RAG или AI Workflow достаточно для качественного и эффективного результата.

По мере роста потребностей и увеличения сложности можно переходить к проектированию автономных AI-агентов, тем самым выводя свои процессы на новый уровень. Стоит также отметить важность подхода к разработке и внедрению подобных систем. Работа с LLM и сопутствующими технологиями требует постоянного экспериментирования, создания тестовых сред, внедрения методик оценки и контроля. Нелинейность и непредсказуемость поведения крупных языковых моделей обуславливают необходимость наличия надежных защит и регуляторных механизмов, которые минимизируют риски и обеспечивают стабильную работу. Без этого любая инновационная система рискует оказаться бесполезной или даже опасной в производственной среде.

Рассматривая опыт ведущих компаний и экспертов, можно увидеть, что история успеха современных AI-систем строится на последовательной интеграции технологий – от простых решений с большими языковыми моделями через RAG к многоступенчатым рабочим процессам и завершая многофункциональными агентами с элементами автономности. При этом ключевыми критериями остаются практическая применимость, надежность и экономическая эффективность. Для бизнесов, стремящихся внедрять искусственный интеллект для оптимизации процессов, понимание этой эволюции помогает выстроить грамотную стратегию. Не стоит стремиться к избыточной сложности или следовать за модными трендами без четкой оценки выгод и затрат. Начинать лучше с оценки существующих рабочих процессов, выявления узких мест и проблем, где LLM и технологии с дополнительным контекстом могут принести наибольшую пользу.

После достижения стабильной автоматизации доступных операций можно постепенно расширять функционал, внедряя интеграцию с внешними инструментами и переходя к более продвинутым AI-агентам. Таким образом, современный путь разработки AI-систем – это постепенное движение от простого к сложному, от статичных моделей к динамичным, автономным решениям. Оптимизация и успех во многом зависят не от применяемых технологий сами по себе, а от умения адаптировать их под реальные задачи, обеспечивать их надежность и масштабируемость. Учитывая вышеизложенное, можно уверенно утверждать, что грамотное применение LLM, RAG, AI Workflow и AI Agent технологий — ключ к эффективным и инновационным инструментам будущего, способным существенно повысить производительность, улучшить качество решений и открыть новые горизонты возможностей.

![Exploring the Theory and Practice of Concurrency in the ECS Pattern [pdf]](/images/050F5B6E-9686-4892-8B64-362CE490293D)