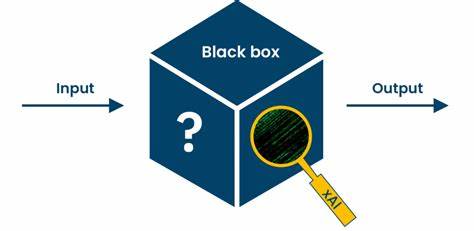

Искусственный интеллект прочно вошел в нашу повседневную жизнь, охватывая множество сфер — от медицины и финансов до кадрового отбора и правоохранительных органов. Однако за впечатляющей эффективностью скрываются серьезные вопросы, связанные с прозрачностью и объяснимостью алгоритмов, особенно тех, которые называют черными ящиками. Понятие «черный ящик» в контексте ИИ относится к моделям, решения которых невозможно или крайне сложно понять даже их создателям. Особенно это касается глубоких нейронных сетей, которые преобразились в сложнейшие структуры с миллиардами параметров, функционирующими в несколько слоев абстракции. Именно эта непрозрачность и порождает новый спектр рисков, от которых не застрахован ни один бизнес, использующий такие технологии.

Черный ящик искусственного интеллекта демонстрирует высокий уровень точности при выполнении задач. Однако он не сообщает, каким образом был сделан вывод или принято решение. Это становится проблемой, когда AI выступает посредником в ключевых решениях — например, назначении диагноза пациенту, оценке кредитоспособности заемщика или выборе кандидата на работу. Люди, оказавшиеся на стороне принятия решения, а также организации, применяющие ИИ, часто остаются в неведении относительно мотивации и логики, стоящей за результатом. Такое положение вещей создает проблемы доверия и может привести к серьезным последствиям в виде ошибок, несправедливости или нарушений законодательства.

Непрозрачность моделей значительно усугубляет задачу контроля и диагностики ошибок. Когда алгоритм выдает неверные рекомендации или решения, определение причин сбоя становится почти невозможным. В результате многие компании рискуют понести серьезные финансовые потери и ущерб репутации. Особенно остро эти проблемы проявляются в высокорискованных сферах — медицине, правосудии и финансах, где неправильное решение может повлиять на здоровье, свободу человека или устойчивость экономической системы. Кроме технической сложности, значительная доля риска связана с юридической ответственностью.

Появляются вопросы: кто несет ответственность, если AI допустил ошибку? Как обеспечить соблюдение антимонопольных и антикоррупционных требований, если процесс принятия решения закрыт? По мере усиления глобального регулирования, включая нормы Европейского Союза, такие как GDPR и EU AI Act, требования к пояснительности искусственных интеллектов становятся все более строгими. Эти нормы предоставляют людям право понимать автоматизированные решения и требуют от организаций доказывать отсутствие дискриминации и предвзятости в алгоритмах. В реальной бизнес-практике многие предприятия испытывают серьезные затруднения в навигации по сложному регулятивному ландшафту. Особенно это касается средних компаний, у которых нет глубоких юридических и технических ресурсов. Для них черный ящик ИИ представляет не только технический вызов, но и значительную операционную нагрузку, связанную с необходимостью соответствовать новым стандартам прозрачности и отчетности.

В этой среде теряется ощущение контроля, что усиливает недоверие как со стороны клиентов, так и со стороны инвесторов. В то же время нельзя отрицать, что черный ящик ИИ обладает неоспоримыми преимуществами. Он способен находить сложнейшие паттерны в больших объемах данных, которые остаются незамеченными для человека. Это позволяет предприятиям выявлять мошенничество, оптимизировать маркетинговые стратегии и принимать решения в режиме реального времени, делая бизнес более конкурентоспособным. Однако цена этой производительности — повышение рисков, которые многие компании либо игнорируют, либо недостаточно понимают.

Мировая индустрия искусственного интеллекта стремится найти баланс между производительностью и объяснимостью. Эксперты подчеркивают, что отказ от прозрачности — путь к кризису доверия и юридическим осложнениям. Разработка объяснимого ИИ (XAI) становится ключевой задачей, направленной на создание моделей, способных не только выдавать ответы, но и аргументировать их. Благодаря таким решениям специалисты получают возможность моделировать поведение ИИ и демонстрировать результаты конечным пользователям и регуляторам. Компании, занимающиеся инновациями в области объяснимого ИИ, утверждают, что именно повышение прозрачности станет конкурентным преимуществом в будущем.

Пока некоторые организации продолжают полагаться исключительно на черные ящики, другие уже интегрируют инструменты для отслеживания и интерпретации работы алгоритмов. Это помогает снизить риски ошибок, уменьшить вероятность предвзятости и повысить общий уровень доверия к технологиям. Несмотря на технологическую глубину проблемы, вопрос прозрачности и доверия касается каждого, кто взаимодействует с искусственным интеллектом. В конечном счете, люди хотят понимать причины, по которым алгоритмы принимают решения, влияющие на их жизнь и работу. Без удовлетворения этого запроса доверие к технологиям будет падать, что негативно скажется на внедрении и развитии ИИ в целом.

Понимание природы черного ящика важно для формирования ответственной политики применения искусственного интеллекта. Регуляторы, бизнес и разработчики должны совместно работать над тем, чтобы создать безопасные и этичные системы. Это означает внедрение обязательных аудитов, открытость к внешним проверкам и усиление просветительской деятельности с целью повышения грамотности в области ИИ. В перспективе нас ожидает смешанная экосистема, где будут сосуществовать мощные, но непрозрачные модели и более простые, объяснимые алгоритмы. Каждая из них займет свою нишу в зависимости от поставленных задач и уровня допустимых рисков.

При этом тенденция неизбежного усиления регуляторных требований будет диктовать необходимость постоянного развития инструментов контроля и отчетности. Итогом становится понимание того, что производительность без прозрачности не может быть устойчивой. Ответственное использование искусственного интеллекта требует не только технических достижений, но и этического подхода, основанного на уважении к правам и безопасности людей. Лишь тогда технологии перестанут быть загадочными машинами и станут надежными партнерами в цифровом мире.