gRPC — популярный фреймворк для межсервисного взаимодействия, широко используемый в современном программировании распределённых систем и микросервисной архитектуры. Он пользуется репутацией высокопроизводительного и надёжного инструмента, основанного на протоколе HTTP/2, позволяющем эффективно управлять множественными потоками и сессиями. Но при всём удобстве и производительности gRPC существует тонкая грань, в которой практически неочевидные нюансы реализации могут стать серьёзным препятствием для достижения максимальных результатов на уровне клиента, особенно в условиях сетей с низкой задержкой. Недавние исследования специалистов компании YDB выявили именно такой скрытый узкий канал. База данных YDB, представляющая собой распределённую SQL систему с высокой доступностью, масштабируемостью и поддержкой строгой консистентности, активно использует gRPC для взаимодействия со своими клиентами.

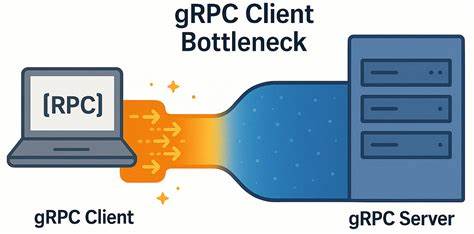

В процессе тестирования и нагрузочного моделирования было замечено вопиюще контринтуитивное явление: при уменьшении количества узлов в кластере нагрузочному генератору — gRPC клиенту — становилось всё тяжелее достигать высокой производительности. Чем меньше становился кластер, тем заметнее росло число незанятых ресурсов, при этом задержка на стороне клиента стабильно увеличивалась. Анализ показал, что основной узкий канал лежит именно на стороне gRPC клиента, а не сервера или сети, что вызвало заинтересованность и желание разобраться в механизмах, обуславливающих это явление. Чтобы выявить и воспроизвести проблему, были разработаны микро-бенчмарки на C++, симулирующие различные сценарии использования gRPC с синхронным и асинхронным вызовами. Результаты подтвердили, что несмотря на близкое расположение серверов и клиентов с сетевым RTT менее 50 микросекунд, производительность не росла пропорционально ожиданиям, а задержки увеличивались почти линейно с ростом числа параллельных запросов.

Такое поведение расходилось с теоретической моделью, в которой предполагается, что рост количества одновременных в полёте запросов должен приводить к пропорциональному увеличению пропускной способности. При внимательном изучении работы gRPC обнаружилась внутренняя особенность: независимо от количества каналов, с одинаковыми аргументами настройки они используют одну и ту же TCP соединение. По умолчанию на одно HTTP/2 соединение устанавливается предел одновременно активных потоков (обычно 100), а новые запросы остаются в очереди до освобождения потоков. В результате большой поток запросов, даже с логическим разделением по каналам, на самом деле упирается в единственную TCP сессию, что провоцирует ожидания и серьёзные задержки на клиентской стороне. Эксперименты с профильным анализом сетевого трафика подтвердили, что проблем со стороны сети практически нет: окно TCP адаптировано верно, задержки передачи минимальны, Nagle выключен, подтверждения приходят вовремя, сервер обрабатывает запросы быстро.

Тем не менее между пакетами запроса и следующими за ними ответами на стороне клиента наблюдается около 150-200 микросекунд паузы, вызванной ожиданием освобождения места в очереди запроса. А поскольку бенчмарк представляет собой замкнутый цикл ожидания ответа перед отправкой нового запроса, итоговая производительность напрямую связана с этими задержками. Для проверки возможных решений были исследованы рекомендации официальной документации gRPC, которая советует разделять высокий трафик между разными каналами и создавать пул таких каналов с различающимися параметрами, чтобы добиться физического создания нескольких TCP соединений. Однако при использовании одинаковых аргументов и аргументации «каждому рабочему по отдельному каналу» проблема не уходила, так как каналы продолжали делить одно TCP соединение. Ключевым моментом стало создание каналов с различием в наборе аргументов, что приводило к появлению разных TCP сессий.

При активации специального параметра GRPC_ARG_USE_LOCAL_SUBCHANNEL_POOL, управляющего пулом подканалов (subchannels), удалось объединить это решение и добиться значительного выигрыша в производительности и снижении задержек. Практические тесты с микро-бенчмарком показали, что при использовании множества TCP соединений при том же количестве параллельных клиентов достигается почти шестикратное увеличение пропускной способности и одновременно более плавный и медленный рост задержек, что является желательным распределением нагрузки и ресурсопользования. Это подтверждает, что критическим фактором для низки латентностей становится именно изоляция контекстов каналов и отказ от жёсткого соединения нескольких каналов через один TCP маршрут. Особенно важны эти оптимизации для систем, работающих в средах с сверхнизкими задержками — например в центрах обработки данных и научных вычислениях, где каждая микросекунда на счету. В таких условиях узкое место в gRPC клиенте может стать причудливой неожиданностью, влияющей на работу всей инфраструктуры.

Чтобы дополнительно оценить влияние задержки сети на проблему, алгоритмы тестирования были повторены в среде с RTT порядка 5 миллисекунд. В этом случае различия между конфигурациями с одним и множеством каналов уменьшились почти до незначительных. Очевидно, что при большей сетевой задержке внутренние издержки клиента оказываются менее значимыми относительно общей задержки передачи. Это даёт эмпирическое подтверждение тому, что описанная проблема критична именно в сетях с ультранизкой задержкой. Рассматриваемые аспекты имеют важное значение для разработчиков распределённых систем и инженеров по производительности, работающих с gRPC и спрямленных на увеличение эффективности и масштабируемости сервисов.

Непонимание поведения каналов, особенности HTTP/2 потоков и их лимитов может привести к неверным архитектурным решениям, из-за которых обещанная высокая производительность не будет достигнута. Подводя итог, можно констатировать, что реальные решения граничат с конфигурационными нюансами и лежат в области грамотного разделения ресурсов на уровне gRPC клиента. Формирование каналов с уникальными аргументами и управление пулом подканалов даёт возможность обойти внутренние ограничения и добиться увеличения пропускной способности с минимизацией задержек. Этот подход является единой стратегией, объединяющей ранее рассматрившиеся раздельное создание каналов и использование пула каналов. При этом нельзя исключать, что в будущем могут появиться и иные способы улучшения производительности и устранения узких мест.

Сообщество разработчиков граничит с постоянным совершенствованием инструментов, а открытые исходные коды микро-бенчмарков позволяют тестировать и верифицировать различные гипотезы и решения. Поэтому настоятельно рекомендуется внимательно следить за обновлениями gRPC и лучших практик, а также проводить тщательное профилирование собственных систем. Такие проактивные действия позволят избежать «иллюзии улучшений» — как справедливо писал Эллияху Голдратт — и сосредоточиться именно на тех узких местах, которые реально тормозят работу. В современном мире, где высокопроизводительные и масштабируемые системы становятся залогом успеха, понимание подобных тонкостей gRPC клиента позволит создавать более устойчивые и быстрые сервисы, способные работать с минимальной латентностью и максимальной пропускной способностью, что напрямую отражается на опыте конечных пользователей и эффективности бизнеса.