Понимание того, что значит утверждение "X объясняет Z% вариации в Y", является ключевым моментом как в статистике, так и в анализе данных. Это выражение часто встречается в исследованиях, научных статьях и публикациях на тему машинного обучения, но не всегда понятно, что именно скрывается за такой формулировкой. Важно разобраться не только в технических аспектах, но и в философии, лежащей в основе объяснения вариации, чтобы правильно интерпретировать результаты и делать обоснованные выводы. Введите понятие вариации. Вариация или дисперсия — это количественная мера разброса значений переменной вокруг её среднего.

В контексте переменной Y, вариация показывает, насколько сильно значения Y отличаются друг от друга. Если вариация велика, то значения сильно разбросаны, если мала — значения концентраируются рядом с центром. Теперь, когда мы говорим, что X объясняет Z% вариации в Y, имеется в виду, что знание значения X помогает уменьшить неопределенность или разброс значений Y в среднем на Z процентов. То есть, если бы мы не знали X, разброс Y был бы одним, а если знать X, остаётся лишь 100% минус Z% — то есть (1−p) в долях разброса или вариации, которую мы не можем объяснить через X. Такое представление полезно, потому что оно сохраняет понимание о том, до какой степени X влияет на Y в статистическом смысле.

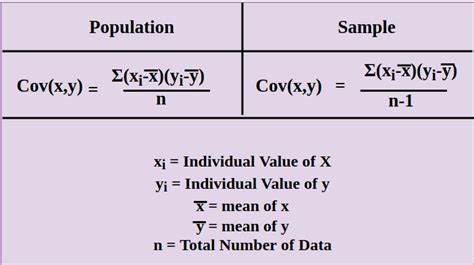

Но для глубокого понимания следует взглянуть на формализацию этого концепта. Для этого используют понятия случайных величин, вероятность и условные распределения. Согласно математической формулировке, общее разброс Y измеряется с помощью полной дисперсии Var(Y). Далее, условная дисперсия Var(Y|X=x) отражает разброс Y при фиксированном значении X = x. Если эта условная дисперсия мала, значит, для данного x значения Y мало колеблются, то есть X несёт в себе много информации о Y.

Чтобы получить общую картину, берут математическое ожидание E[Var(Y|X)], то есть усредняют по всем возможным значениям X, взвешенным по вероятностям. Идея в том, что разница между полной дисперсией Var(Y) и средним условным разбросом E[Var(Y|X)] показывает, насколько знание X сократило неопределённость в Y. Это разница и называется объяснённой вариацией. Долю объяснённой вариации записывают в виде: p = 1 − E[Var(Y|X)] / Var(Y). Величина p лежит обычно в диапазоне от 0 до 1 и интерпретируется как доля вариации Y, объяснённая переменной X.

Значения ближе к 1 означают сильную объяснённость, близкую к детерминизму, а близкие к 0 — слабую или отсутствующую связь. В реальной жизни простое вычисление E[Var(Y|X)] может быть технически непростым или невозможным из-за большого объёма данных или сложности зависимостей между X и Y. На практике используют разные методы для аппроксимации этих величин. Если набор данных большой и X дискретная переменная с конечным числом значений, можно рассчитать средний разброс Y на каждой «группе» фиксированного X и агрегировать их, чтобы приближённо оценить E[Var(Y|X)]. В случае непрерывных X или ограниченного объёма данных, используют регрессионные модели, которые пытаются предсказать Y через X и минимизируют среднеквадратичную ошибку.

Такие модели дают оценки условного математического ожидания μ(Y|X=x), и затем среднеквадратичная ошибка между наблюденными и предсказанными значениями Y становится оценкой оставшейся дисперсии. Доля вариации, объяснённой моделью, тогда сопоставляется с прежним понятием p. Однако важно помнить, что качество объяснения вариации зависит от выбранной модели. Если модель слишком простая, она недообъяснит вариацию, а если реакции модели на данные переобучены (overfitting), она может «показать» слишком большие значения p, которые не обобщаются. Следовательно, процент объяснённой вариации — это показатель не столько истинной силы зависимости X и Y, сколько качество и адекватность используемой модели.

Другой важный момент — объяснённая вариация не обязательно означает причинно-следственную связь. Она лишь отражает наличие статистической зависимости. К примеру, X может совпадать по распределению с Y из-за скрытых факторов, влияющих на обе переменные. Поэтому интерпретировать фразу "X объясняет Z% вариации в Y" как утверждение о том, что X вызывает изменения в Y, неправильно без дополнительного анализа. Интересным способом определения доли объяснённой вариации при отсутствии данных обо всех переменных является метод близнецовых исследований.

Исследуя близнецов, генетическое сходство которых известно, можно оценить, как много вариации в характеристике Y (например, IQ) связано с генетическими факторами X, даже если сами генотипы напрямую не измерены. В таких исследованиях дисперсия в разнице значений Y у близнецов используется для оценки необъяснённой дисперсии, а сравнительные вычисления дают долю объяснённой вариации. Нужно также отметить, что объяснённая вариация зависит от распределения переменных в выборке. Другими словами, меняется состав, в котором берутся данные, меняется и значение p. Это указывает на то, что объяснённая вариация — статистическая характеристика конкретной популяции, а не абсолютный признак связи.

Сопоставляя концепцию объяснённой вариации с информационной теорией, взаимная информация между X и Y измеряет уменьшение неопределённости (энтропии) в Y при знания X, и теоретически может быть более универсальной мерой зависимости, не зависящей от модели. Однако взаимная информация сложна в вычислении и интерпретации, а объяснённая вариация через дисперсию остаётся широко применяемой и интуитивно понятной. Изучая данные, важно применять знание о объяснённой вариации с учётом специфики исследования. Высокое значение p может свидетельствовать о сильной зависимости, но не гарантирует причинность. Малое значение — не обязательно признак отсутствия связи — может отражать ограниченность модели, шум или маленький размер выборки.

Подходы интеграции моделей, исправления смещений и аккуратный учёт контекстных факторов повышают качество интерпретации результатов. В заключение можно сказать, что утверждение "X объясняет Z% вариации в Y" — это удобный статистический язык, через который сообщается о том, насколько знание одного параметра снижает неопределённость другого. Именно понимание механизма вычисления, ограничения и контекста, лежащих за этим выражением, помогает исследователям и аналитикам принимать уверенные решения, правильно оценивать значимость переменных и прорабатывать модели, приближенные к реальному положению вещей.