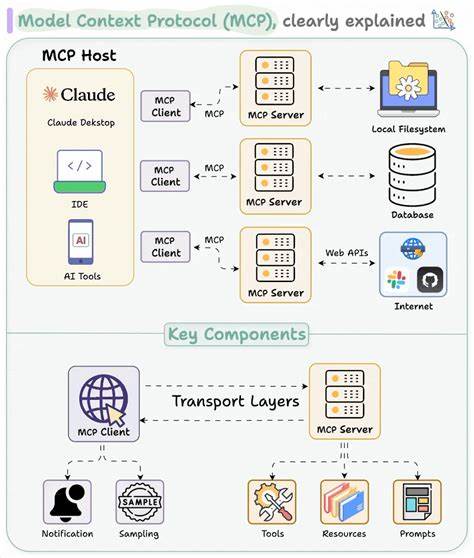

В современном мире искусственный интеллект становится неотъемлемой частью многих процессов разработки и принятия решений. Одной из ключевых задач при взаимодействии с большими языковыми моделями (LLM) является поддержание и управление контекстом, который помогает ИИ моделям лучше понимать задачи и историю взаимодействия. Каждый раз, когда пользователь переключается между различными платформами или инструментами — будь то Claude, ChatGPT, Cursor или локальные LLM — возникает необходимость заново объяснять ключевые моменты проекта. Этот процесс не только замедляет работу, но и увеличивает риск потери важной информации. Инструмент context-llemur призван решить именно эту проблему, предлагая удобный и гибкий способ управления контекстом в рамках единого интерфейса командной строки (CLI) и протокола MCP (Model Context Protocol).

Context-llemur — это инструмент с удобным CLI, который под капотом использует git для хранения и версионного контроля контекста. По сути, каждое ваше понимание, заметка, цель или правило в проекте становится частью отдельного git-репозитория. Благодаря этому, контекст перестает быть разрозненным набором данных и превращается в управляемый и отслеживаемый ресурс, который может путешествовать вместе с вами между любыми LLM, сторонними утилитами или собственной разработкой без риска «зависеть» от конкретной платформы или сервиса. Большое преимущество использования git как основы — это возможность легко создавать ветки, исследовать новые идеи и стирать или совмещать их по мере необходимости. Например, если в ходе работы над проектом возникает новая функция или экспериментальная гипотеза, можно создать новую ветку с помощью команды ctx explore, подробно описать в ней все мысли и детали, а затем, когда все готово — интегрировать изменения обратно в основную ветку командой ctx integrate.

Все изменения контекста при этом полностью контролируются и могут быть отменены в любое время, что гарантирует стабильность и надежность. Особое внимание стоит уделить тому, что context-llemur изначально создан как инструмент, понятный и удобный для использования как людьми, так и машинами. CLI построен с человеческой логикой — простыми и интуитивно понятными командами можно создавать, переключаться между контекстами, просматривать изменения, перемещать и удалять файлы внутри структуры. При этом MCP сервер даёт возможность прямой интеграции с агентными системами или с другими LLM, которые смогут автоматически считывать нужный контекст, создавать свои заметки и сохранять прогресс в рамках единой базы. Еще одно важное преимущество — портативность контекста.

Он не привязан к конкретной технологии или базе данных и может быть передан между разными инструментами, которые поддерживают MCP или CLI. Это открывает абсолютно новые перспективы для команд, которые работают с различными решениями ИИ одновременно. Например, можно начать обсуждение задачи в Claude, продолжить её в Cursor, а затем локально исследовать детали с использованием своей LLM, не вводя заново никакие настройки и не теряя накопленного знания. Context-llemur можно установить через менеджер пакетов pip или через uv — современный инструмент для управления виртуальными окружениями и зависимостями. Установка и запуск сервера MCP происходит быстро и занимает минимум времени, что особенно актуально для тех, кто хочет интегрировать инструмент в свои пайплайны или агентные системы.

Помимо базового управления контекстом, программа поддерживает множество дополнительных функций, включая просмотр статуса репозитория, отображение недавних изменений, сравнений между версиями и многое другое. Немаловажна философия, стоящая за проектом: контекст не является кодом, и его структура не должна навязываться жестко. Таким образом, context-llemur предоставляет максимальную свободу для организации и представления информации. В результате пользователи могут вести свои TODO-листы, описывать цели, задачи и правила так, как им комфортно, при этом сохраняя возможность управлять этими данными как единым, версионным хранилищем. Рассмотрим реальные сценарии использования инструмента.

Одним из главных кейсов является применение вместе с агентными IDE и CLI, где LLM сам становится активным участником разработки. Благодаря тому, что в начале каждой сессии агенту подаётся полный контекст проекта, он может мгновенно адаптироваться к особенностям задачи, давать контекстуальные советы, писать код и фиксировать изменения. Это значительно ускоряет разработку, снижает необходимость повторных объяснений и позволяет сфокусироваться на ключевых целях. Вторым примером может служить применение с платформами вроде Claude Desktop, где пользователь ведёт личные или профессиональные заметки, отслеживает историю и автоматически генерирует новые идеи и планы по заданной теме — например, комплексные планы тренировок, где ИИ на основе прошлого прогресса предлагает оптимальное распределение нагрузки и записывает новые результаты. Важно отметить, что к моменту написания инструментарий продолжает активно развиваться, и разработчики призывают сообщество участвовать в его улучшении.

Это свидетельствует о живой экосистеме вокруг инструмента и его открытости. Кроме того, MIT лицензия гарантирует свободу использования и адаптации под свои нужды без ограничений. Таким образом, context-llemur становится универсальным помощником для тех, кто работает с большими языковыми моделями и хочет вывести процесс взаимодействия на новый уровень. Инструмент умно объединяет проверенные временем технологии управления версиями с современными подходами к семантическому контексту и ИИ, предоставляя разработчикам, исследователям и энтузиастам удобный и функциональный инструмент для постоянного совершенствования своих проектов. Его применение значительно упрощает трансфер знаний между разными платформами, сокращает издержки времени, а также улучшает качество и эффективность работы с сложными информационными структурами, связанными с искусственным интеллектом.

Впереди — только расширение возможностей и интеграция с ещё большим количеством систем, что делает context-llemur крайне перспективным и востребованным решением в эпоху активного развития AI-технологий.