В современном мире социальные сети и видеоплатформы стали неотъемлемой частью повседневной жизни миллионов людей. Алгоритмы, управляющие рекомендациями и формирующие нашу ленту новостей, оказывают огромное влияние на восприятие информации и формирование предпочтений пользователей. Однако представляется ли возможным манипулировать этими алгоритмами с помощью так называемого «цифрового яда» — искусственно созданного воздействия, способного испортить работу алгоритмических систем? В данной статье мы рассмотрим эту концепцию, ее особенности и возможные последствия для цифровой экосистемы. Алгоритмы рекомендаций — это сложные математические модели, анализирующие поведение пользователя, историю просмотров, клики и многие другие параметры для предсказания интересного и релевантного контента. За счет машинного обучения и искусственного интеллекта эти системы постоянно совершенствуются, адаптируясь к изменениям в поведении аудитории.

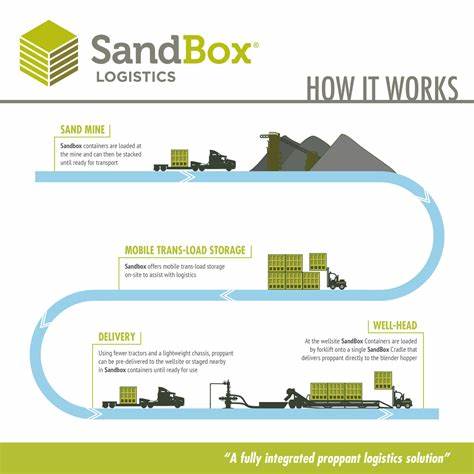

В то же время эта закрытость и сложность вызывают вопросы о прозрачности и устойчивости к внешним манипуляциям. Примером цифрового влияния служит устройство под названием Digital Poison, разработанное группой энтузиастов, которое использует одноплатный компьютер Raspberry Pi 5 для беспрерывного воспроизведения конкретных видео на платформе YouTube по Wi-Fi сети. Эта непрерывная нагрузка на алгоритм формирует искаженное восприятие пользовательских предпочтений, заставляя систему рекомендовать одни и те же видео другим пользователям, подключенным к одной сети. Концепция достаточно простая, но вызывает множество споров. С одной стороны, такие действия могут непреднамеренно влиять на формирование новостных лент и списков рекомендованного контента, создавая информационные искажения.

С другой — крупные платформы активно разрабатывают механизмы обнаружения подозрительного поведения, включая ботоводство, массовые просмотры и искусственные взаимодействия, и способствуют минимизации подобных влияний. Вопрос в том, насколько эффективна подобная постановка эксперимента в реальных условиях. Практический опыт и мнения экспертов показывают, что масштаб локальной сети зачастую недостаточен для существенного изменения алгоритмических рекомендаций, так как платформы учитывают множество факторов: привязку к аккаунтам, историю взаимодействий, геолокацию и другие параметры. Следовательно, одиночное устройство в общем случае не способно полностью «заразить» или серьёзно исказить работу алгоритма. Однако следует учитывать, что крупные злоумышленники и дезинформационные кампании используют гораздо более продвинутые и масштабные методы.

Массовые боты и фальшивые аккаунты, которые одновременно воспроизводят видео, комментируют, ставят оценки и таким образом создают иллюзию популярности, давно доказали свою эффективность в формировании трендов и даже политических настроений. Наряду с ростом автоматизации, распространение подобных методов усугубило проблему доверия к цифровой информации. Кроме того, присутствует и обратная сторона «ядерного» влияния — алгоритмы YouTube и других платформ внедряют механизмы борьбы с фейковыми просмотрами и нежелательной активностью. Постоянное повторное воспроизведение одних и тех же роликов без реального вовлечения пользователей часто фиксируется и обесценивается системой, что снижает эффективность попыток манипуляции. Тем не менее в информационной войне и маркетинговых стратегиях не исчерпано количество способов внедрения искусственного воздействия в алгоритмы.

За последние годы наблюдается активное использование искусственного интеллекта для генерации контента, комментариев и даже подделки пользовательских профилей. Эти приемы позволяют создавать вязкий коктейль из реального и подстроенного поведения, запутывая автоматизированные системы и снижая их способность быстро реагировать на подобные угрозы. Важной темой является и вопрос приватности и безопасности данных в эпоху алгоритмов. Тайные и сложные вычисления, на которых построены рекомендации, часто недоступны для публичного анализа и критики. Это открывает простор не только для манипуляций, но и вызывает обеспокоенность по поводу влияния таких систем на общественное мнение и культурные нормы.

Отсутствие прозрачности алгоритмов порождает недоверие и желание искать обходные пути в обход автоматизированных рекомендаций. Одной из альтернатив для пользователей, желающих снизить влияние алгоритмов на свой информационный поток, являются независимые видеоплееры, установки блокировщиков рекламы, анонимные браузеры и поисковые системы, не собирающие персональных данных. Эти меры позволяют контролировать, какой контент будет предложен, а какой нет, хотя и не решают проблему алгоритмических манипуляций в глобальном смысле. В перспективе, с развитием технологий, можно ожидать появление более совершенных форм защиты контента и борьбы с искусственным влиянием. Впрочем, повышение прозрачности, возможно, станет ключевым элементом для восстановления баланса между автоматизацией рекомендаций и доверием пользователей.

Подводя итог, можно сказать, что цифровой яд и подобные ему проекты демонстрируют важность повышения внимания к устойчивости и этичности современных алгоритмических систем. Несмотря на то, что одиночные попытки воздействия не могут в корне изменить алгоритмы гигантов индустрии, масштабные и скоординированные кампании остаются серьезной угрозой для информационной экосистемы. Только совместная работа разработчиков, исследователей, пользователей и регуляторов может привести к созданию более здоровой и надежной среды распространения контента в эпоху цифровых технологий.