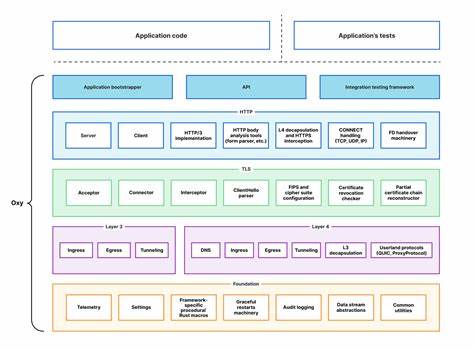

Современное машинное обучение требует мощных инструментов для вычислений с автоматическим дифференцированием, что становится основой для обучения нейросетей и оптимизации моделей. Появление JAX от Google вызвало настоящий бум среди исследователей и разработчиков благодаря своей функциональной природе и поддержке автоградирования на GPU и TPU. Однако, несмотря на популярность JAX, многие разработчики сталкиваются с определённой сложностью понимания и использования полного функционала библиотеки, особенно если им хочется изучить или разработать упрощённые модели, сосредоточенные на ключевых концепциях. В этом контексте звучит особенно интересно проект Microjax — минималистичный автоград для JAX, реализованный всего в двух классах и шести функциях, который сочетает компактность, наглядность и функциональность. История появления Microjax тесно связана с влиятельной репутацией Andrej Karpathy и его проекта Micrograd.

Micrograd — это минималистичная библиотека для автограда на Python и PyTorch, состоящая из примерно 150 строк кода, которая максимально интуитивно объясняет основы обратного распространения градиентов. Inspired этим подходом, автор Microjax поставил перед собой задачу создать нечто схожее, но с применением JAX, где архитектура и интерфейс формируются в более функциональном и современном стиле. Основное отличие этой библиотеки в том, что она реализована очень лаконично — всего двумя классами и шестью функциями. Это делает Microjax не просто учебным примером, но и реальным инструментом, которым удобно пользоваться и который можно адаптировать под разные задачи. Такой уровень минимализма позволяет как новичкам, так и опытным разработчикам глубже понимать внутренние механизмы автоматического дифференцирования и создавать собственные расширенные модели, владея тонким контролем вычислительного графа.

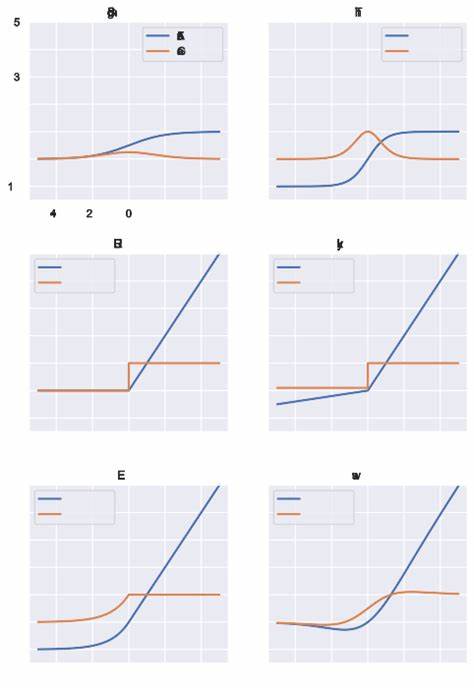

Чем же так удобен функциональный стиль JAX, а вслед за ним и Microjax? В первую очередь этим стилем определяется более строгая разделённость данных и функций, что улучшает читабельность и тестируемость кода. Функции в JAX — чистые, без побочных эффектов, что гарантирует предсказуемость в поведении при вычислениях и оптимизациях. Именно эта характеристика обуславливает огромный рост популярности JAX среди научного сообщества и индустрии. Microjax заимствовал ключевые идеи из представленной в 2017 году Matthew J Johnson презентации по autograd — предшественнику JAX в области автоматического дифференцирования. Используя простоту и функциональность этой концепции, автор смог упростить структуру, представляя вычисления как композиции функций с автоматическим построением графа и обратным распространением ошибок.

Это дало возможность сосредоточиться на функциональном ядре и упростить обучение для разработчиков. Благодаря своей компактной реализации Microjax демонстрирует поразительную эффективность в демонстрации основных аспектов построения нейронных сетей и работы с градиентами, не создавая при этом избыточного кода, традиционного для более комплексных фреймворков. Это идеально подходит для быстрой прототипизации, исследования новых идей в обучении моделей и обучения основам автоматического дифференцирования. Для тех, кто уже работал с PyTorch или TensorFlow, Microjax становится полезным мостом для освоения JAX и его функционального языка. Простота кода помогает увидеть фундаментальные операции, лежащие в основе сложных алгорифмов, и понять, как строится обратное распространение градиентов, что является ключевым моментом для успешного применения ML технологий.

Помимо учебной пользы, сокращение кода до двух классов и шести функций положительно сказывается на поддерживаемости и расширяемости библиотеки. Такой минимализм снижает количество ошибок и упрощает процесс интеграции новых методов оптимизации и дифференцирования. Кроме того, проект оформлен в виде Jupyter Notebook, что делает его удобным для интерактивного обучения и мгновенного тестирования. Стоит отметить, что Microjax лицензирован под MIT-лицензией, что обеспечивает свободу использования и модификации как для образовательных целей, так и для коммерческой разработки. Проект доступен на GitHub, где он продолжает поддерживаться и развивается как open source, собирая позитивные отзывы и растущую аудиторию пользователей.

Использование Microjax рассматривается как отличная отправная точка для понимания работы JAX и создания собственных инструментов автоматического дифференцирования на Python с максимально сжатыми и понятными структурами. Благодаря этому возможно более глубокое проникновение в принципы ML и более эффективно использовать современные технологии, достигая лучших результатов с меньшими затратами времени и ресурсов. Таким образом, Microjax — это не просто библиотека, а важный образовательный ресурс и минималистичная основа для построения мощных моделей на JAX. Его функциональный подход, лёгкость восприятия и практическая применимость делают Microjax уникальным инструментом на рынке, обогащая сообщество специалистов по машинному обучению и продвигая идеи функционального программирования в области искусственного интеллекта.