Языковые модели больших масштабов (LLM) стремительно меняют наше взаимодействие с технологиями искусственного интеллекта. Одним из ключевых параметров, влияющих на их работу, является температура генерации текста. Она определяет степень случайности и вариативности в ответах модели, напрямую влияя на креативность и точность создаваемого контента. Однако большинство пользователей и даже специалистов часто сталкиваются с проблемой настройки этого параметра, поскольку оптимальное значение температуры существенно зависит от конкретной задачи и её особенностей. В этой связи становится особенно интересной новая методика, которая позволяет самой языковой модели выбирать и корректировать свою температуру в процессе генерации — технология, получившая название ThermoAsk.

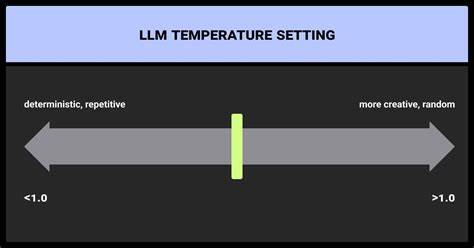

Традиционно температура устанавливается вручную пользователем. При температуре, близкой к нулю, LLM выбирает наиболее вероятные варианты продолжения текста, что приводит к более консервативным и предсказуемым ответам. Увеличение температуры усиливает элемент случайности, отчего тексты становятся более разнообразными и креативными, но при этом возрастает риск появления неуместных или ошибочных фрагментов. Например, температура 1.0 считается стандартной настройкой, но далеко не всегда она оптимальна для всех задач — в некоторых случаях требуется более «жёсткий» подход (низкая температура), а в других — максимально свободный и разнообразный (высокая температура).

Проблема усугубляется тем, что языковые модели часто плохо симулируют истинную случайность. В качестве примера можно привести эксперимент с моделью Phi-2 от Microsoft, которая при температуре 1.0 должна была равномерно выбрать случайное число от 1 до 20. Однако результат оказался далёк от равномерного распределения, поскольку некоторые числа выпадали значительно чаще, чем другие. Такая ситуация несовместима с базовыми требованиями к случайным выборкам и подчёркивает проблему: обычные алгоритмические методы с фиксированной температурой могут быть неэффективны для задач, где нужна истинная случайность.

Один из очевидных способов решения — использовать внешние инструменты, например запросить у модели генерацию кода на Python для выбора случайного числа, выполнить этот код во внешней среде и затем вернуть результат пользователю через инфраструктуру LLM. Однако такой подход не всегда удобен и может быть избыточным. Другой, более изящный метод основан на тонкостях математического аппарата языковых моделей. Температура напрямую влияет на распределение вероятностей слов или токенов после преобразования логитов через softmax-функцию. Когда температура стремится к бесконечности, различия между логитами нивелируются и каждый возможный выход становится равновероятным.

Это открывает возможность получать действительно равномерный выбор при выборе между ограниченным набором опций. Однако для конечного пользователя, незнакомого с этим аспектом, такой трюк может оставаться скрытым. Особенно если задача сложнее, чем простое случайное число, и требуется «золотая середина» — необходимость адаптировать температуру в зависимости от контекста и этапа генерации. Здесь и вступает в игру ThermoAsk — концепция, при которой сама языковая модель способна анализировать сценарий и интеллектуально устанавливать оптимальное значение температуры в реальном времени. Впервые название ThermoAsk появилось в 2025 году в блоге исследователя Аманвира Пархара.

Он продемонстрировал, как модель Claude Sonnet 4 смогла определить оптимальную температуру для задачи, где требовалось выбрать случайное число от 1 до 20. По запросу модель предложила использовать максимальную температуру (позитивную бесконечность или максимально доступное значение, зачастую около 2.0) для достижения настоящей случайности. При этом ThermoAsk не ограничивается лишь выбором фиксированной температуры, а позволяет менять параметры генерации в разных частях одного и того же ответа. Пример более сложной задачи — запрос вычислить математическое выражение и затем создать абстрактное стихотворение, включающее результат.

Здесь логично использовать низкую температуру при вычислении и формировании точного ответа, а затем повысить температуру для генерации креативного поэтического текста. В такой ситуации ThermoAsk выступает как инструмент автоматической адаптации стратегии генерации, переключая модель между режимами детерминированного и творческого вывода. Такой подход можно реализовать через инструментальную систему вызовов (tool calling), когда LLM сама запрашивает изменение собственной температуры в необходимый момент. В качестве основы для реализации Аманвир Пархар использовал Python SDK Ollama и модель Qwen2.5-7B, обладающую поддержкой потоковых вызовов.

Это позволило получить реальный рабочий прототип, который демонстрирует принцип работы техники ThermoAsk напрямую в диалоговом взаимодействии. Практическое значение подобной системы сложно переоценить. Во многих сценариях это позволяет существенно повысить качество и уместность ответов, особенно в многоэтапных задачах, сочетающих точные вычисления и творческое повествование. Вместо того чтобы ограничиваться одной статичной настройкой температуры, модель становится гибкой: она сама принимает решения о степени случайности, балансируя между предсказуемостью и оригинальностью. Кроме того, метод ThermoAsk демонстрирует важность интеграции встроенных механизмов саморегулирования в языковые модели.

Такой подход не только облегчает жизнь конечным пользователям, освобождая их от необходимости глубоко разбираться в тонкостях параметров генерации, но и открывает новые перспективы для более сложного и многослойного взаимодействия с ИИ. Стоит отметить, что концепция использования одной языковой модели для управления параметрами генерации другой уже поисследовано специалистами, но именно ThermoAsk фокусируется на параметре температуры и позволяет моделям автоматически рефлексивно адаптировать своё поведение в зависимости от задачи без вмешательства человека. Потенциал технологии велик и многогранен. Она может найти применение в генерации художественных текстов, технических расчётов, креативного программирования и даже в образовательных платформах, где подстройка уровня творчества и точности критична. С ростом внедрения LLM в реальные задачи подобные инновации сделают взаимодействие с ИИ более интуитивным, эффективным и адаптивным.

Следующим шагом развития ThermoAsk, вероятно, станет усовершенствование механизма автоматического анализа запросов и контекста диалога, а также расширение инструментария контроля за другими важными параметрами генерации – такими как top-k, nucleus sampling и другие. Комплексный подход к самостоятельной настройке модели позволит ещё сильнее приблизить ИИ к человеческому стилю мышления и коммуникации. В целом, способность языковой модели самостоятельно выбирать собственную температуру – важный шаг на пути создания более самостоятельных и гибких ИИ-систем. Это новшество меняет традиционный взгляд на взаимодействие с LLM, предлагая новый уровень автоматизации и интеллектуального управления генерацией, что будет востребовано в самых различных сферах уже в ближайшие годы.