Язык программирования Haskell известен своей выразительностью и мощью, однако синтаксис этого языка часто вызывает трудности, особенно у новичков. Одной из главных причин сложности является парсинг отступов — механизм, который влечет за собой различные правила и тонкости при разборе кода. На первый взгляд, может показаться, что разбираться с этими правилами — настоящая головоломка, однако понимание и правильная реализация данного парсера позволяют значительно упростить работу с языком и избежать множества ошибок. Парсинг отступов в Haskell тесно связан с понятием «правило офсайда». Это правило отвечает за автоматическую вставку виртуальных символов вроде точек с запятой и закрывающих фигурных скобок, что особенно важно при использовании отступов для группирования кода, вместо явного обозначения блоков символами «{» и «}».

Такие области кода называются «размещёнными блоками» (laid out blocks). Например, конструкции let, where, do и of являются так называемыми «ключевыми словами размещения» — за ними следует блок кода с особыми отступами, которые определяют структуру программы. В идеале, если после ключевого слова следует явное открытие блока с фигурной скобкой, парсинг упрощается — отступы в этом случае игнорируются, и парсер просто разбирает все, что находится внутри фигурных скобок. Однако большинство программ на Haskell предпочитают работать без явных фигурных скобок, опираясь именно на отступы. Здесь и начинается настоящая магия.

Правило офсайда требует, чтобы компилятор или парсер отслеживал текущий уровень отступа для каждого блока кода. Первая строка блока задает «ориентир» — это колонка, в которой начинается первое выражение после ключевого слова размещения. Последующие строки сравниваются с этим значением: если новая строка начинается на том же уровне, автоматически вставляется точка с запятой, обозначающая начало нового выражения или декларации. Если отступ больше — выражение считается продолжением предыдущего. Если меньше — виртуально закрываются открытые блоки до достижения соответствующего уровня отступа.

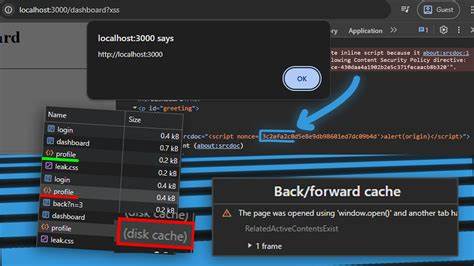

Реализация этих правил в лексере и парсере — нетривиальная задача. Во-первых, необходимо отслеживать столбцы начала каждой строки, чтобы корректно идентифицировать начало и окончание блоков. Во-вторых, виртуальные символы, такие как открывающие и закрывающие фигурные скобки, а также точки с запятой, нужно уметь вставлять в поток токенов — это называется вставкой виртуальных токенов. В Haskell-сообществе для решения описанных задач широко используются инструменты Alex и Happy. Alex — это генератор лексиков, а Happy — генератор парсеров, оба работают на языке Haskell.

Несмотря на их фундаментальную важность, документация была долгое время скудной и не всегда понятной, что усложняло изучение их возможностей. Главная идея заключается в создании слоя лексера, который, помимо обычного разбиения текста на токены, отслеживает отступы и манипулирует состоянием для корректного вставления виртуальных токенов. В частности, лексер держит стек отступов, отражающий текущие уровни вложенности. Когда встречается ключевое слово размещения, лексер фиксирует текущую колонку и начинает отслеживать последующие строки, реагируя на изменение отступа по описанным принципам. Для решения технических вопросов, таких как работа с состоянием лексера, удобно использовать монаду состояния.

Внутри лексера хранятся и обновляются данные о текущем уме, позиции, стеке отступов и прочих необходимых контекстах. Важно, что лексер и парсер в данном подходе тесно связаны: добавление виртуальных токенов во время лексического анализа влияет на грамматику и логику синтаксического анализа. При реализации на Alex с собственным пользовательским оберткой (wrapper) для управления состоянием позиции символа достигается гибкость и точность. Это позволяет корректно отслеживать переходы между строками, обновлять счетчики строк и колонок и обеспечивать точное сопоставление с исходным кодом, что положительно сказывается на диагностике ошибок. После того, как лексер способен выдавать поток токенов с виртуальными символами, возникает задача написания парсера, понимающего новую грамматику.

Инструмент Happy отлично поддерживает монады, что позволяет выполнять лексический анализ и синтаксический разбор внутри единого контекста с поддержкой эффектов, включая обработку ошибок. Это необходимое условие, так как парсеру нужно уметь «ловить» ошибки и использовать их для завершения виртуальных блоков, что добавляет устойчивости и надежности всей цепочке анализа. Грамматика для языковых конструкций с разметкой на основе отступов аккуратно оформляется с учетом нескольких вариаций записей. Блоки объявлений могут заключаться в фигурные скобки или в виртуальные OPEN и CLOSE токены, предоставляемые лексером. При этом стоит предусмотрительно использовать правила для «закрытия» блоков как через явные символы, так и через обработку ошибок — это объясняется тем, что парсер может столкнуться с предсказуемыми ошибками, которые сигнализируют о необходимости завершения блока.

Самое важное — каждый уровень абстракции от лексера до парсера ведется декларативно и последовательно. Возникает возможность создавать более читаемые и поддерживаемые проекты, а в дальнейшем масштабировать механизм, интегрируя более сложные конструкции и аннотации. Значительным преимуществом построенного подхода считается возможность сочленения с современными оптимизациями. Хотя в базовом примере используется простая строка как источник входных данных, замена внутреннего представления на ByteString или Text способна существенно увеличить производительность, необходимую для больших проектов. Такая гибкость вызывает доверие у профессиональных разработчиков, которым приходится работать с большими кодовыми базами.

В итоге, несмотря на кажущуюся хаотичность и сложность синтаксиса Haskell, его «загадка» — парсинг отступов — разрешима с помощью продуманного совмещения современных инструментов и идей функционального программирования. Глубокое понимание правила офсайда и механизмов его реализации способствует написанию более корректного, предсказуемого и эффективного компилятора или интерпретатора. Парсинг отступов в Haskell — это не только катализатор к развитию навыков работы с лексиками и парсерами, но и отличная возможность познакомиться с тонкостями обработки синтаксиса в реальных проектах. Именно такая детализация и симбиоз инструментов сформировали собственный стиль функционального программирования данного языка, являющийся предметом гордости сообщества и причиной популярности Haskell в академической и промышленной сферах.