Современные достижения в области больших языковых моделей (LLM) кардинально изменили подходы к созданию интерактивных агентных систем. Сегодня агенты на базе LLM способны выполнять сложные задачи, комбинировать логическое мышление и использование внешних инструментов, а также взаимодействовать с пользователями в длительных многошаговых сессиях. Однако эффективность таких агентов напрямую зависит от того, насколько грамотно организован и управляем их контекст — «рабочая память» модели, ограниченная размером контекстного окна. Концепция контекстной инженерии становится одной из ключевых для разработчиков и исследователей, стремящихся создать максимально продуктивных и надежных агентов. Контекстное окно LLM можно сравнить с оперативной памятью компьютера.

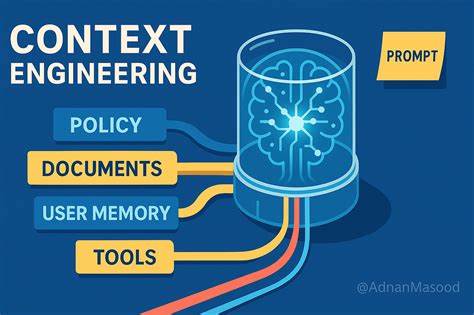

Хотя в последние годы размер контекстного окна значительно увеличился, он всё же остается конечным и ограниченным по количеству токенов. Чем больше данных помещается в контекст одновременно, тем выше нагрузка на модель, что приводит к увеличению задержек, расходу вычислительных ресурсов и повышению вероятности ошибок. Поэтому необходимо тщательно подбирать, какие именно данные и в какой форме должны попадать в контекстную область, чтобы обеспечить оптимальную работу агента. Контекстная инженерия — это совокупность методов и практик, направленных на эффективное заполнение контекстного окна информацией, которая максимально релевантна задаче агента. Одним из ведущих экспертов в области является Андрей Карпаты, который сравнивает LLM с новой операционной системой, где контекстное окно служит быстродействующим оперативным буфером, а контекстную инженерию — с задачей управления этой памятью.

Цель — обеспечить, чтобы модель использовала исключительно полезные, точные и необходимые данные без засорения лишней или ошибочной информацией. Существует несколько видов контекста, с которыми приходится работать инженерам при создании агентов. Среди них инструкции, знания и инструменты. Инструкции могут включать подсказки для модели, примеры решений, описания используемых инструментов и многое другое. Знания — это факты, вспомогательная информация и накопленные памятные данные.

Инструменты предоставляют возможность расширить функционал модели путем вызова внешних сервисов, API или специализированных функций. Контекстная инженерия работает с каждым из этих аспектов, стремясь оптимизировать их использование и интеграцию. Хотя современные агенты активно используют инструментальные вызовы между сессиями общения, проблема ограниченного размера контекстного окна становится особенно острой в ходе долгих и комплексных задач. Накопление значительного объема информации с каждого шага может привести к ряду осложнений, которые принято называть эффектами контекстного загрязнения. Контекстное загрязнение бывает нескольких видов.

Контекстное отравление возникает, когда в рабочую область попадают ошибочные или вымышленные данные, которые искажают вывод модели. Контекстная перегрузка случается, когда количество информации становится слишком большим, и модель не может выделить важное из всего потока. Контекстное замешательство связано с тем, что избыточные, не относящиеся напрямую к задаче данные могут сбивать модель с толку, снижая качество ответов. Контекстный конфликт появляется, если в рамках одного окна сосуществуют противоречивые данные или инструкции, что также усложняет обработку. Все эти вызовы подчеркивают ключевую роль контекстной инженерии.

Разработчики вынуждены создавать сложные и точные стратегии, которые помогают сохранять в памяти агента исключительно полезную информацию и эффективно управлять этой информацией на протяжении всего рабочего процесса. Основные подходы к контекстной инженерии можно условно разделить на четыре категории: сохранение контекста вне окна модели, выборка и загрузка релевантного контекста, сжатие объема информации и изоляция контекста для решения отдельных подзадач. Сохранение контекста вне активного окна модели позволяет агенту работать с гораздо большим объемом данных, сохраняя их в специальных внешних структурах, которые можно вызывать при необходимости. Одним из известных методов является использование заметок-сcratchpad, аналогично тому, как человек делает пометки во время решения сложных задач. Эти заметки могут храниться в файлах, базах данных или специальных областях памяти, доступных агенту в любой момент.

Такая практика нашла отражение в продуктах крупных компаний и исследовательских проектов, ориентированных на долговременное запоминание и дальнейшее использование критически важной информации. Память агентов развивается мультисессионно, благодаря механизмам, позволяющим накопленную информацию упорядочивать, переосмысливать и повторно использовать с каждой новой сессией. Некоторые исследовательские группы предлагают методы «рефлексии» после каждого шага агента, позволяя модели анализировать собственные действия и создавать обобщенные воспоминания. Такие технологии легли в основу современных продуктов с автообновляемыми долгосрочными памятью — например, ChatGPT, Cursor и Windsurf, где интерактивность и персонализация достигаются именно через обработку и выборку накопленных данных. Второй аспект — выборка контекста, когда агент в каждый конкретный момент подбирает только те фрагменты информации, которые максимально соответствуют текущей задаче.

Отсюда берутся примеры для few-shot обучения, либо фрагменты памяти, факты и инструкции. Проблема заключается в том, что с ростом базы знаний и объема памятных данных автоматически увеличивается сложность отбора. Простой подход, например, всегда загружать одни и те же наборы файлов, может привести к контекстным конфликтам и потере релевантности. Современные решения используют продвинутые методы векторизации, такие как эмбеддинги и индексацию посредством графов знаний. Они способствуют более точному поиску и отбору элементов памяти, но при этом сохраняют риск неправильной или неожиданной выборки, что в ряде случаев вызывает недовольство пользователей — когда агент извлекает из памяти неуместные или приватные данные, ощущение контроля над собственным контекстом пропадает.

Работа с инструментами также требует грамотного управлении контекстом. Излишнее количество инструментов или перегруженные документированные описания могут сбивать модель по части выбора нужного инструмента в текущем шаге. В таких ситуациях применяется техника Retrieval Augmented Generation (RAG), при которой из набора инструментов выбираются только самые подходящие с помощью семантического поиска и оценки релевантности. Это повышает точность и экономит токены при построении запроса. Объем знаний и данных, к которым получает доступ агент, особое внимание уделяется процессу индексации и поиска.

Для примера, при работе с большими кодовыми базами применение простого эмбеддингового поиска становится недостаточным, в то время как комбинация техник — семантическое разбиение, анализ синтаксического дерева и последующая переоценка результатов — повышает качество контекстной выборки. Сжатие контекста — еще один важный блок контекстной инженерии. Как правило, речь идет о сокращении объема текста до наиболее важных информационных единиц. Автоматическое суммирование — один из самых популярных подходов. Например, Claude Code использует функцию «автокомпакт» для создания кратких обзоров полномасштабных обменов информацией, что позволяет постоянно оптимизировать память агента и выдерживать лимиты по токенам.

Суммирование может применяться периодически, например, после тяжелых по объему запросов к инструментам, или на границах взаимодействия нескольких агентов, что снижает нагрузку и улучшает качество последующего рукопожатия знаний. Однако процесс сжатия требует тонкой настройки и зачастую применения специализированных дообученных моделей, чтобы не потерять ключевые решения и важные детали. Кроме того, практикуется практика специальных методов «обрезки» или «прюнинга» контекста, где устаревшая или малозначащая информация удаляется или фильтруется на основе жестких правил или обученных моделей. Это помогает снизить «шум» и убрать из контекста неактуальные данные. Изоляция контекста — один из последних трендов, направленных на распределение и структурирование задач между несколькими агентами или подсистемами.

Вместо того чтобы загружать всю информацию в одно контекстное окно, контекст разделяется по подзадачам, которые обрабатываются отдельными агентами с собственными специализированными инструментами и наборами данных. Такая архитектура позволяет каждому агенту сосредоточиться на более узкой области, что повышает общую эффективность и качество решения. OpenAI Swarm и Anthropic активно развивают подобные многозадачные системы. Правда, при этом возрастает общее потребление токенов, а также возникает необходимость в специализирующем управлении и координации агентов. Вариацией изоляции контекста являются среды исполнения, в которых Agent генерирует код с вызовами инструментов, запускаемый в песочницах.

HuggingFace предложил идею CodeAgent, где обработка сложных объектов и хранение результатов организованы в виде кода и состояния с четко определенными схемами, например, с использованием Pydantic моделей. Это позволяет хранить объемные данные вне контекстного окна и передавать только необходимые фрагменты в модель. Выводы показывают, что контекстная инженерия становится краеугольным камнем эффективного проектирования агентов на основе LLM. Выделяются четыре ключевые стратегии — сохранение контекста вне модели, выборка наиболее релевантных данных, сжатие информации и изоляция подзадач. Правильное сочетание и адаптация этих подходов в зависимости от сложности и типа задачи определяют, насколько успешно агент сможет справиться с возложенными на него функциями.

Будущее контекстной инженерии обещает глубокую интеграцию с новыми методами машинного обучения, расширение функционала памяти и повышение интеллектуальности поведения агентов. Для инженеров и разработчиков знание этих принципов становится неотъемлемой частью создания надежных, масштабируемых и интеллектуальных систем нового поколения.