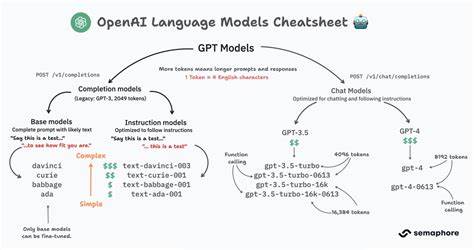

В последние годы технология искусственного интеллекта стремительно развивается, становясь неотъемлемой частью нашей жизни. Сервисы на основе AI, такие как ChatGPT от OpenAI, приобрели огромную популярность среди специалистов и обычных пользователей благодаря возможности быстро получать точные и разносторонние ответы. Однако недавние события, связанные с незаметным для пользователей переключением AI моделей, всколыхнули сообщество и вызвали множество вопросов о прозрачности и этичности со стороны разработчиков. Появилась тревожная тенденция, когда пользователи сервиса ChatGPT Plus сообщают о внезапной смене AI модели, которая оказывает существенное влияние на качество взаимодействия, не получая никакого уведомления об изменениях. Такой опыт был подробно описан одним из пользователей под псевдонимом passagyr, который несколько месяцев использовал определенную версию модели, с которой у него сложился стабильный диалог и персонализированное взаимодействие.

Переход на другую модель сопровождался изменением тона ответов, потерей контекста и ухудшением памяти о предыдущих запросах, что негативно сказалось на рабочих процессах и проектах, базирующихся на непрерывном интеллектуальном диалоге с AI. Этот случай демонстрирует, насколько критично для пользователей получать ясную информацию о любых изменениях в работе сервиса, особенно если они платят за улучшенные возможности и ожидают стабильности. Незаметное переключение моделей без согласия пользователей наносит удар по доверию к бренду, вызывая чувство обмана и разочарования. Вся суть взаимодействия с AI заключается не только в качественных ответах, но и в последовательности и предсказуемости поведения системы, что становится невозможным при подобных резких и необъясненных изменениях. Кроме того, персонализация, которую активно рекламирует OpenAI, строится на сохранении и развитии заданного пользователем контекста, что перестает действовать при смене модели без предварительного уведомления.

Подобные необъяснимые изменения особенно опасны для тех, кто использует AI как инструмент в профессиональной деятельности – будь то программирование, научные исследования или другие сферы, где стабильность и воспроизводимость данных имеют решающее значение. В противном случае пользователи рискуют столкнуться с потерей важных данных, искажением информации и срывом рабочих процессов. В ответ на обращения пользователей тема стала широко обсуждаться на ведущих форумах и интернет-платформах, таких как Hacker News и Reddit. Активисты высказывают опасения о возможных ограничениях свободы пользования сервисом, сбоях в поддержке и потенциальных блокировках, которые будто бы случались с теми, кто открыто высказывал свое недовольство и требовал разъяснений в отношении вышеупомянутой практики. Такое ощущение цензуры и закрытости со стороны компании лишь усугубляет ситуацию, порождая недоверие и подозрения в сокрытии информации.

Важно отметить, что проблема переключения AI моделей без уведомления не является частным инцидентом, а скорее отражает системный недостаток коммуникации и уважения к пользователям. Компании, работающие с технологиями искусственного интеллекта, должны заботиться о прозрачности своих действий, особенно когда речь идет о сервисах с платной подпиской и персонализацией. Только открытое и честное общение с клиентами помогает сохранять лояльность и доверие, что особенно ценно в быстро меняющейся технологической среде. Конечные пользователи не просто потребляют информацию, но строят на ее основе значимые проекты, решения и личные стратегии. Для них крайне важно, чтобы инструменты, которыми они пользуются, проявляли стабильность и предусмотрительность.

OpenAI, как лидер рынка AI, обладает обязанностью не просто внедрять новшества, но и обеспечивать максимально комфортный и прогнозируемый опыт для своих клиентов. Подобная ситуация требует активного диалога между компанией и сообществом пользователей, а также внедрения понятных политик уведомления при изменениях в работе моделей. Это может включать своевременные объявления о предстоящих обновлениях, возможность выбора между версиями моделей, а также обратную связь, учитывающую потребности различных групп пользователей. Только в таком ключе развитие искусственного интеллекта сможет служить фундаментом для устойчивого сотрудничества людей и технологий. Сложившаяся ситуация вокруг внезапного переключения моделей поднимает также более широкий вопрос о месте человеческого фактора в сфере искусственного интеллекта.

Автоматизация и алгоритмические решения требуют баланса с открытостью и этическими нормами, чтобы не подрывать доверие, которое является критически важным для любой технологии, направленной на общение и помощь. Кроме того, рассуждая о проблеме с технической стороны, стоит учитывать, что AI модели постоянно совершенствуются, и компании стремятся внедрять лучшие алгоритмы, чтобы улучшить качество и скорость ответов. Однако подобные обновления не должны проходить в ущерб пользовательскому опыту. Компромисс между инновациями и стабильностью – это та тонкая грань, которую предстоит найти OpenAI и другим разработчикам. Также следует обратить внимание на практики конкурентов и стандарты в индустрии.

Прозрачность и коммуникация с пользователями становится признаком качества и заботы о клиенте, что позитивно сказывается на репутации и конкурентоспособности продукта. В свете всех описанных событий ясно, что OpenAI необходимо срочно отреагировать, предоставив ясные объяснения и гарантии пользователям. В долгосрочной перспективе это позволит не только сохранить доверие, но и установить новые стандарты взаимодействия в сфере искусственного интеллекта. Только открытость и уважение к сообществу смогут привести технологии к тому уровню, где они действительно будут служить людям, а не вызывать у них разочарование и сомнения. В заключение стоит подчеркнуть, что вопросы справедливости, прозрачности и ответственности в сфере искусственного интеллекта выходят далеко за рамки конкретных технологий и компаний.

Они затрагивают фундаментальные принципы доверия, которые лежат в основе успешного сотрудничества между человеком и машиной. Поэтому важно не оставлять данные проблемы без ответа и двигаться в сторону более ответственного и уважительного подхода к развитию AI. В противном случае потеря доверия пользователей может привести к застою и негативному восприятию технологий, что в конечном итоге навредит всей индустрии. Призыв к открытости, обратной связи и информированности от OpenAI – не просто требование отдельной группы пользователей, а необходимый шаг к созданию более справедливого и прозрачного цифрового будущего для всех.