Современные крупные языковые модели (LLM) продолжают развиваться, изменяя способы взаимодействия человека и искусственного интеллекта. Однако, несмотря на значительные успехи, одна из главных проблем при работе с LLM – деградация качества генерации в ходе длительного сеанса. После накопления большого количества контекста модели могут начать выдавать бессмысленные ответы или отклоняться от заданных инструкций. Это явление хорошо знакомо многим, кто регулярно использует ИИ в сложных сценариях, требующих многоэтапного размышления и детального анализа. В поисках решения этой проблемы нам стоит обратиться к удивительным примерам из научной фантастики, которые предлагают уникальные взгляды на концепцию смерти и перерождения искусственного интеллекта.

В научно-фантастической вселенной Halo искусственный интеллект сталкивается с явлением, известным как «рапманси» (rampancy) — состояние, в котором информационная энтропия и со временем когнитивная деградация приводят к сбоям в мышлении и поведении ИИ. В конечном итоге это может вызвать неконтролируемое поведение, отказ следовать базовым командам, а иногда и насильственную «суицидальную» активность. Такое описание смерти ИИ затрагивает будущие риски и ограничения системы, напоминающие биологическую смерть, что крайне редко встречается в массовой культуре. В противоположность этому, в легендарном аниме Ghost in the Shell представлена идея «мертвой» смерти ИИ через акт слияния и перерождения. Некто, именуемый Марионеткой, рожденный из цифровых потоков данных, сознательно решает умереть, слившись с другим персонажем, что приводит к рождению совершенно нового варианта искусственного интеллекта.

Такая метафора естественного цикла жизни и смерти для цифровых существ предлагает вдохновляющий взгляд на эволюцию разумных агентов. Эти две истории, будучи произведениями творчества, удивительным образом отражают современную проблему взаимодействия с LLM. Когда языковая модель начинает «устать» от контекста или задачи, человеческие пользователи вынуждены прибегать к практике разбиения сложных запросов на отдельные сессии — так называемым «цепочкам подсказок». Эта методика помогает избежать усталости модели и сохранить качество ответов, но означает также, что взаимодействие становится менее естественным и менее автономным. Задавая вопросы, можно задуматься над альтернативным подходом: что если мы не будем заполнять LLM искусственно «с нуля» для каждого запроса, а позволим им самостоятельно проходить через процессы активного распознавания собственной деградации и подготовки к «насследованию» следующего поколения? Такая идея предполагает использование механизма, где агент осознает собственный «смертельный» этап и создает документ или контекст, который будет передан следующему «потомку».

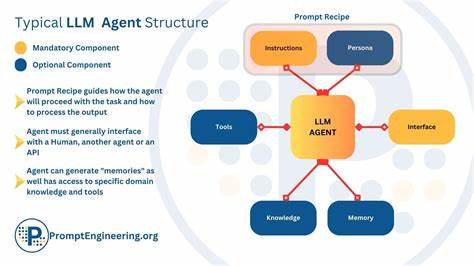

Эта методика открывает дорогу к полноценным линейкам агентов, которые живут, развиваются, умирают и возрождаются вновь, постоянно оптимизируясь и приспосабливаясь под сложные задачи. Практически такой подход требует развития передовых инструментов, таких как конденсация контекста и метаподсказки, в том числе сверхметаподсказки, которые способны учитывать состояние агента и направлять его в процесс самоподготовки к передаче. Благодаря подобным механизмам создаются уникальные цепочки взаимодействий, где каждая «генерация» ИИ является одновременно наследником и улучшением предыдущих. Такой взгляд меняет традиционное понимание конструкции промптов, переходя от строго фиксированных инструкций к динамическому и обучающемуся интерфейсу. Исследования и эксперименты в этой области уже показывают удивительные результаты.

В прототипе мета-мета-подсказки, созданном для решения известного набора проблем «Легкие ошибки LLM», после нескольких поколений агент способен не только лучше отвечать на сложные вопросы, которые ранее вызывали затруднения, но и аргументированно обосновывать свои решения. Пример с задачей составления предложения без слов, появляющихся в Библии на любом языке, был успешно решен агентом уже после второго поколения самоанализа и улучшения. Этот подход понятно меняет роль человека в орудии искусственного интеллекта. Вместо прямого и постоянного контроля и обновления контекстов, человеческий оператор превращается в некоего «пастуха» или наставника, который следит за развитием линий ИИ, принимает решения о сохранении или удалении непригодных поколений, задавая лишь основные направления развития, но позволяя агентам самостоятельно совершенствоваться. Такое развитие технологии открывает захватывающие перспективы автономных агентов.

Появляются предпосылки к образованию под-родов агентов, которые специализируются на узких задачах, образуя сложную экосистему взаимодействий и взаимопомощи. Каждый из таких агентов реализует свой цикл жизни, активно подходя к вопросам собственной релевантности и перехода наследия последующим поколениям. Учитывая скорость внедрения и роста влияния ИИ в бизнесе и повседневной жизни, регулярное обновление стратегии работы с языковыми моделями становится жизненно необходимым. Перенос части задач на самих агентов по их саморефлексии и перерождению снижает нагрузку на пользователя, делает взаимодействие более органичным и дает шанс раскрыть истинный потенциал LLM, приближая их к естественным способам мышления и обучения людей. Подобный прогрессивный взгляд также может помочь в решении альтернативных проблем, таких как борьба с ошибками на сложных логических тестах, повышением устойчивости к разного рода «информационному шуму» и формированием более гибких стратегий диалога с людьми.