В современном мире искусственного интеллекта и обработки естественного языка трансформеры выступают одной из самых успешных архитектур, обеспечивающих высокую точность решения сложных задач. Однако с развитием крупномасштабных моделей и увеличением объема данных возникали серьезные ограничения, связанные с вычислительными ресурсами и эффективностью обработки токенов. В попытке решить эти проблемы исследователи обращаются к новым архитектурным подходам. Одним из таких прорывных решений стал 2-симплициальный трансформер, разработанный с использованием высокопроизводительной реализации в Triton. Такой подход значительно улучшает эффективность и качество обработки информации, особенно в задачах, связанных с математикой, программированием и логикой.

Традиционные трансформеры основаны на механизме внимания, эксплуатирующем скалярное или векторное произведение между представлениями токенов — так называемое дот-продуктное внимание. Этот метод доказал свою эффективность на множестве задач, но с ростом масштабов моделей неизбежно растет и потребление вычислительных ресурсов. При этом качество обучения напрямую зависит от количества обработанных токенов, что порождает серьезные проблемы с токен-эффективностью, особенно при ограничениях на объем доступных данных. 2-симплициальный подход кардинально расширяет концепцию внимания, переходя от традиционного дот-продукта к трилинейным функциям. Это означает, что внимание формируется не на основе пар токенов, а на взаимодействии троек, или 2-симплексов.

Такая конструкция позволяет уловить более сложные и многомерные зависимости в данных, что особенно важно для задач, требующих глубокого понимания структуры и контекста, например, решения логических задач или программирования. Реализация 2-симплициального внимания на базе Triton стала ключевым технологическим прорывом, благодаря которому удалось существенно снизить накладные расходы на вычисления. Triton — это специализированный компилятор и библиотека для написания высокопроизводительных GPU-ядер, позволяющая оптимизировать выполнение сложных операций в ядре трансформера. Благодаря эффективной реализации внимания с использованием Triton, 2-симплициальный трансформер работает быстрее и требует меньше ресурсов, чем его традиционные аналоги при том же уровне качества. Одним из наиболее значимых достижений данного подхода является повышение токен-эффективности.

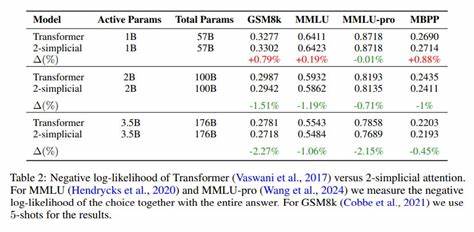

Исследователи обнаружили, что при ограниченном бюджете токенов модели, использующие 2-симплициальное внимание, демонстрируют лучшие результаты, чем модели аналогичного размера с дот-продуктным вниманием. Это особенно актуально в современных условиях, когда объем данных может быть ограничен, несмотря на общую тенденцию к использованию интернет-масштабных наборов данных. Кроме того, 2-симплициальное внимание меняет основные закономерности масштабирования обучающих моделей. В классических подходах обучение модели кажется «вычислительно ограниченным» — эффективность растет при увеличении как размера модели, так и количества токенов. Однако новое исследование показало, что для задач, ориентированных на знание и рассуждения, 2-симплициальный трансформер меняет показатели масштабирования, улучшая баланс между размером модели и количеством токенов.

Такие сдвиги неминуемо влияют на стратегии создания и обучения будущих крупных языковых моделей. Практическое применение 2-симплициального внимания открывает новые возможности для решения задач, характеризующихся высокой сложностью взаимосвязей. В математических вычислениях это помогает точнее моделировать взаимоотношения между различными элементами формул и операций, что улучшает качество предсказаний и позволяет трансформеру глубже понимать структуры. В программировании и логике возможность учитывать тройственные связи повышает способность модели к анализу кода, формулированию правил и рассуждению о процессах. Благодаря таким улучшениям можно ожидать прорывов в автоматизации кода, выявлении ошибок и оптимизации программ.

Разработка 2-симплициального трансформера также стимулирует дальнейшие исследования в области обобщенных механизмов внимания. Использование более сложных геометрических и топологических структур для представления данных и их взаимосвязей выходит за рамки классических подходов и открывает перспективы новых классов архитектур с высшей выразительностью и гибкостью. Triton выступает как мощный инструмент, позволяющий реализовать эти теоретические идеи на практике с эффективным использованием ресурсов GPU. В перспективе интеграция 2-симплициального внимания в коммерческие и исследовательские языковые модели способна повысить их конкурентоспособность, снизить издержки на обучение и обеспечить более глубокое понимание контекста. Это может положительно сказаться на развитии приложений искусственного интеллекта в таких сферах, как образовательные технологии, разработка программного обеспечения, научные исследования и многие другие.