Технология gRPC уже давно завоевала популярность как надежная и быстрая платформа для организации межсервисного взаимодействия. Благодаря использованию протокола HTTP/2 и возможности обмена множественными потоками данных внутри одного TCP-соединения, gRPC получил широкое распространение в корпоративных и распределённых системах. Однако, несмотря на общее представление о высокой производительности, при работе с сетями с низкой задержкой обнаруживается неожиданный клиентский узкий боттлнек, который ограничивает эффективность подключений и негативно сказывается на общей пропускной способности. В условиях высокой доступности и масштабируемости распределенных баз данных, таких как YDB, именно gRPC часто используется в качестве интерфейса для взаимодействия клиентов и серверов. Недавние внутренние исследования показали удивительный феномен: при уменьшении числа узлов кластера наблюдалось снижение нагрузки на систему, увеличение простаивающих ресурсов и, что более важно, рост задержек по стороне клиента.

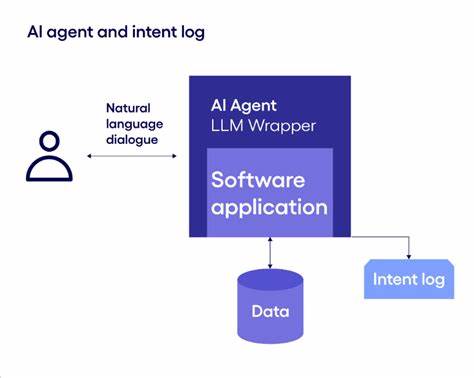

Несмотря на оптимальный сетевой уровень без потерь и минимальной задержкой передачи, производительность клиентских вызовов RPC не поднималась выше определенного уровня. Основной причиной этому стал сам клиент gRPC, а точнее механизм работы каналов и ограничения, наложенные внутренним HTTP/2 стэком. Стандартно каждый канал gRPC устанавливает одно TCP-соединение, на котором HTTP/2 мультиплексирует запросы, позволяя параллельно обмениваться данными по нескольким потокам. При ограничении количества одновременно активных потоков (по умолчанию 100) новые запросы, превышающие это число, попадают в очередь ожидания, что влияет на метрики задержек и сдерживает рост пропускной способности. Похожим образом проблема усугубляется, когда для каждого рабочего потока создается собственный канал с одинаковыми параметрами подключения.

Из-за отсутствия отличительных настроек сервер gRPC пересылает все эти соединения в один и тот же TCP-поток, что ведет к перегрузке и возникновению задержек. Наличие множества рабочих потоков, выполняющих RPC-запросы с единичным параллелизмом, приводит к насыщению очереди в одном TCP-соединении, замедляя передачу и обработку данных. Инженеры YDB разработали мини-бенчмарк, реализованный на C++ с использованием последних версий gRPC, который позволяет выявить и воспроизвести данный узкий боттлнек. Тестирование проходило на двух мощных физических серверах с сетью 50 Гбит/с и минимальной сетевой задержкой около 40 микросекунд. Несмотря на такие условия, рост общего числа клиентских параллельных запросов не приводил к адекватному увеличению пропускной способности, вместо этого наблюдался рост латентности, что противоречит теоретической линейной масштабируемости.

Детальный сетевой анализ tcpdump и Wireshark подтвердил отсутствие проблем уровня TCP – плохое качество канала, к примеру, отсутствовали пакетные потери, отложенные подтверждения, проблемы с окнами TCP и прочее. Внимание сместилось на логику работы HTTP/2 внутри клиента gRPC – здесь обнаружилась особенность, связанная с поведением ожидания и обработки подтверждений от сервера. Клиент отправляет пакет запросов, сервер отвечает батчем, после чего появляется существенная пауза в 150-200 микросекунд до следующей отправки. Решением задачи стала реализация подхода с созданием индивидуальных каналов для каждого рабочего потока, но с разными параметрами, что позволяет каждому каналу устанавливать отдельное TCP-соединение. Вариант с использованием мультиканальных пулов и уникальных аргументов каналов значительно улучшил показатели теста.

В итоге удалось добиться повышения пропускной способности почти в 6 раз для обычных RPC и в 4.5 для потоковых, при этом задержка увеличивалась незначительно при росте параллелизма. Что особенно важно, аналогичная проблема при повышении сетевой задержки до 5 миллисекунд практически исчезает – многоканальное решение становится не таким критичным, и узкое место смещается на сетевой уровень. Это свидетельствует о том, что клиентский боттлнек проявляется в первую очередь в высокопроизводительных локальных или датацентровых сетях, где сетевые задержки крайне малы, а требования к пропускной способности высоки. Данное открытие позволяет сделать вывод, что официальные рекомендации по gRPC, касающиеся создания отдельных каналов с уникальными параметрами и распределения нагрузки по нескольким соединениям, на самом деле являются взаимосвязанными компонентами единой эффективной методики обхода клиентского ограничения.

Игнорирование этого факта может привести к неправильным выводам и снижению общей эффективности приложений. Перспективы дальнейшей оптимизации связаны с более тонкой настройкой параметров каналов и серверов, а также возможным внесением изменений непосредственно в кодовую базу gRPC. Интересный момент, который стоит исследовать, – это характер конкурентности внутри клиентской библиотеки и способы оптимизации очередей обработки потоков. Для разработчиков и архитекторов распределенных систем подобные инсайты крайне важны: понимание внутренних ограничений используемых технологий позволяет грамотно строить и масштабировать инфраструктуры, не теряя в производительности при росте нагрузки. Использование демонстрационного бенчмарка и правильной конфигурации gRPC станет практическим инструментом для выявления проблемных мест и оценки новых подходов.

Таким образом, проблематика неожиданного узкого места клиента gRPC в низколатентных сетях подчеркивает необходимость комплексного подхода к настройке межпроцессного взаимодействия. Создание многоканальной архитектуры с индивидуальными параметрами каналов – проверенный способ обеспечить высокую производительность и низкую задержку в современных распределённых приложениях. Будущее гRPC и подобных платформ зависит от того, насколько успешно разработчики решат подобные вызовы и предложат более эффективные механизмы взаимодействия на различных уровнях стеков коммуникаций.