Современное развитие искусственного интеллекта тесно связано с развитием больших языковых моделей (LLM). Они становятся все более мощными благодаря качественной тренировке на различного рода данных. Одним из ключевых направлений совершенствования языковых моделей является разработка эффективных методов генерации и отбора обучающих примеров, в особенности для задач, требующих сложных рассуждений и планирования. В этой области значительный прорыв представляет метод CoT-Self-Instruct, который сочетает стратегию Chain-of-Thought (цепочка мыслей) с автоматизированной генерацией и фильтрацией синтетических подсказок. Такой подход позволяет существенно повысить качество и сложность обучающих данных, что напрямую влияет на уровень интеллекта обучаемой модели.

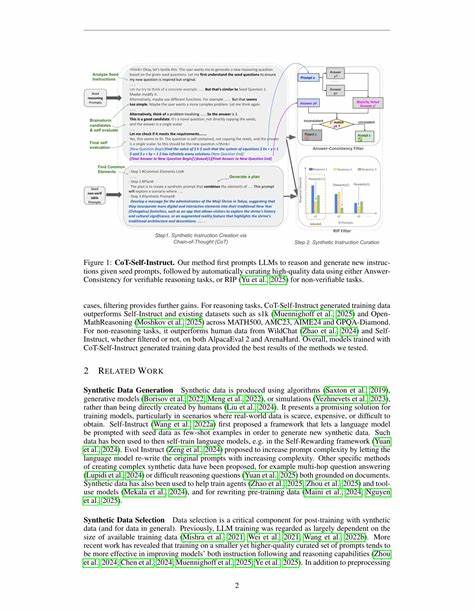

Метод CoT-Self-Instruct был представлен авторами из сферы искусственного интеллекта в 2025 году и быстро привлек внимание исследователей благодаря своей эффективности и универсальности. Его суть заключается в использовании стартовых, или «seed» задач, которые моделям предлагается решить, применяя детальное рассуждение и планирование через механизм Chain-of-Thought. На основе этих процессов порождаются новые синтетические задания, аналогичные по структуре и уровню сложности исходным, но генерируемые автоматически. Такой подход сначала стимулирует модель к глубокому анализу и формированию развернутых рассуждений, а затем использует эти рассуждения для создания комплексных обучающих примеров. Далее, сгенерированные данные проходят этап фильтрации.

Автоматические метрики оценивают качество и релевантность примеров, отбирая только самые ценные и качественные. Отбор гарантирует, что итоговый набор синтетических подсказок соответствует высоким стандартам качества и способен максимально эффективно обучать модели. Применение CoT-Self-Instruct демонстрирует впечатляющие результаты в нескольких областях. В задачи, требующие строго верифицируемого рассуждения, как математические тесты MATH500, AMC23, AIME24, а также GPQA-Diamond, синтетические данные, созданные этим методом, значительно превосходят традиционные обучающие наборы, такие как s1k и OpenMathReasoning. Это свидетельствует о том, что качественно построенные цепочки мыслей не только улучшают способность модели к решению сложных проблем, но и формируют более надежные обоснования решений.

Помимо задач с верифицируемыми рассуждениями, CoT-Self-Instruct показывает превосходство и в области не требующих строгого доказательства инструкций — типичных для общения модели с пользователем и выполнения различных команд. На таких популярных бенчмарках, как AlpacaEval 2.0 и Arena-Hard, метод демонстрирует результаты лучше, чем традиционные человеческие данные и устаревшие методы Self-Instruct. Это открывает возможности для создания эффективных систем, которые надежно и гибко следуют инструкциям, улучшая качество взаимодействия с конечными пользователями. Важной отличительной чертой CoT-Self-Instruct является баланс между автоматизацией и контролем качества.

Синтетический характер данных позволяет значительно увеличить масштаб обучения без необходимости привлечения больших команд специалистов для создания обучающих наборов. При этом интеллектуальная фильтрация гарантирует, что качество автоматически сгенерированных подсказок не пострадает, что часто бывает проблемой у других автоматизированных методов. Такой подход снижает издержки и ускоряет этапы разработки, поддерживая при этом высокий уровень интеллектуальных возможностей моделей. Кроме того, благодаря своей универсальности, CoT-Self-Instruct подходит для широкого спектра задач. Независимо от того, нужна ли модель для напряженных логических и математических задач или для выполнения повседневных инструкций и запросов пользователей, этот метод позволяет формировать качественные тренировочные данные, существенно улучшая конечные показатели.

В будущем потенциал CoT-Self-Instruct можно расширять путем интеграции с другими продвинутыми техниками генерации данных, включая использование мультимодальных источников информации и адаптивного обучения с подкреплением. Это позволит создавать еще более гибкие и интеллектуальные системы, способные разбираться с самыми сложными вызовами в области искусственного интеллекта. Таким образом, CoT-Self-Instruct стал важным шагом на пути развития обучающих методов для больших языковых моделей. Он демонстрирует, что сочетание цепочек рассуждений с мощными синтетическими генеративными процессами и тщательной автоматической фильтрацией способно вывести качество и разнообразие обучающих данных на новый уровень. Для разработчиков и исследователей в области ИИ метод предлагает эффективный инструмент, способный существенно повысить производительность и интеллектуальные способности современных языковых моделей.

В конечном итоге, CoT-Self-Instruct способствует созданию более умных, надежных и адаптивных систем, способных решать широкий спектр задач, начиная от точных научных расчетов до гибкого общения с пользователем.