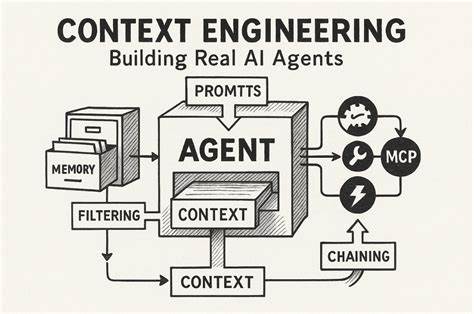

Развитие искусственного интеллекта постепенно приводит к созданию все более сложных и многофункциональных AI-агентов, способных не только отвечать на вопросы, но и самостоятельно выполнять сложные задачи в разнообразных сферах. Ключевым фактором успешной работы подобных систем становится контекстное проектирование — процесс оптимизации и структурирования информации, которую модель учитывает при принятии решений и генерации ответов. В отличие от ранних этапов развития NLP, когда модели требовали длительного обучения на новых данных, современные агенты опираются на способности больших языковых моделей к обучению в контексте. Это позволяет быстро дорабатывать и адаптировать поведение без длительных циклов тренировки, что особенно важно для продуктов в условиях быстро меняющегося рынка и требований пользователей. Первым и одним из важнейших аспектов контекстного проектирования является эффективное использование KV-кэша — механизма сохранения вычисленных представлений префиксов в контексте.

Это влияет на производительность и стоимость работы с моделями, потому что кэширование позволяет значительно сократить время генерации первых токенов и уменьшить количество операций, необходимых для повторного анализа одинаковых частей контекста. Важно сохранять стабильность префикса, избегая включения динамичных или меняющихся данных, таких как точное время, которое часто встречается в системных подсказках. Кроме того, сериализация данных должна быть детерминированной, иначе даже мелкие изменения порядка ключей могут привести к сбросу кэша. В условиях распределенного хостинга моделей следует применять идентификаторы сессий, чтобы запросы обрабатывались консистентно и с максимальной выгодой от кэширования. Еще одной проблемой, с которой сталкиваются разработчики AI-агентов, является управление растущим пространством действий.

С увеличением возможностей агента число доступных инструментов и функций растет, что повышает сложность выбора оптимального шага. Неправильная динамическая загрузка и выгрузка инструментов в ходе действия может разрушить кэш и привести к противоречивым подсказкам, вызывая ошибки генерации и галлюцинации. Примером эффективного решения является подход маскирования токенов во время декодирования — вместо удаления инструментов из контекста отключаются нежелательные варианты выбора путем подавления вероятностей их появления. Это позволяет сохранять целостность контекста и высокий показатель кэширования, одновременно жестко контролируя действия агента согласно текущему состоянию. Ограничение только внутренним контекстным окном LLM становится еще одной серьезной проблемой.

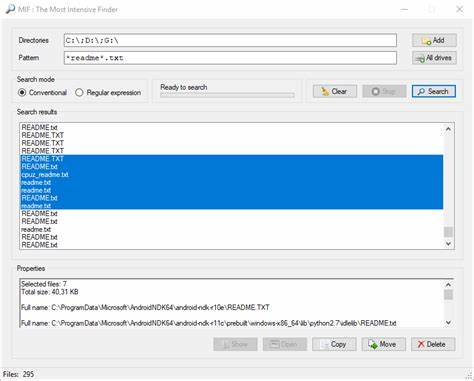

Даже при больших контекстных окнах в 128 тысяч токенов и более, в реальных агентных системах часто оказывается недостаточно полезной информации для принятия решений. К тому же хранение и обработка длинных контекстов зачастую усиливает износ моделей и увеличивает стоимость взаимодействия. Инновационным решением становится использование файловой системы как внешнего контекста и постоянной памяти агента. Такой подход позволяет сохранять и восстанавливать важные данные на диске, а в контексте одновременно поддерживается лишь необходимая краткосрочная информация. Таким образом достигается баланс между полнотой знания и эффективностью обработки.

Файловая система становится не только пространством хранения, но и инструментом управления внешним состоянием, который может быть прочитан и изменен самим агентом по мере выполнения задач. Практика манипулирования вниманием модели естественным языком — еще одно интересное направление в контекстном проектировании. Например, ведение динамического списка задач todo.md, который модель периодически обновляет, является стратегией удержания внимания на главных целях и предотвращения забывания важных шагов. При выполнении многоэтапных операций такой вспомогательный документ работает как «якорь», усиливая напоминание модели об общей цели и текущем статусе работы.

Это снижает риск дрейфа генерации в сторону нерелевантных ответов и способствует сохранению фокуса даже в пределах длинных и сложных сессий. Реалистичный подход к ошибкам и неудачам также критичен для успешной работы AI-агентов. Вместо того чтобы скрывать неудачные действия и очищать логи от ошибок, лучше оставить их в контексте. Это позволяет модели учиться на собственных ошибках, изменяя внутренние предположения и снижая вероятность повторения тех же промахов. Такая стратегия улучшается способность агента к самокоррекции и повышает стабильность поведения в реальных условиях, где ошибки неизбежны, а доступ к этому «опыту» — залог прогресса.

Среди распространенных ошибок новичков стоит отметить чрезмерную зависимость от few-shot подхода в построении контекста. Повторение одинаковых шаблонов действий и наблюдений может привести к повторяемости и шаблонности поведения агента, что снижает его адаптивность и вызывает дрейф в длинных задачах. Для решения этой проблемы лучше встраивать небольшие структурированные вариации в формат и содержание сериализованных данных, что способствует разнообразию и помогает модели избегать ограниченного паттерна мышления. Все перечисленные методы и практические советы доказывают, что контекстное проектирование — это не просто практика добавления информации в модель, а целая наука о формировании живого, адаптивного и устойчивого диалога между агентом и миром. Только благодаря грамотному управлению контекстом AI-агенты способны одновременно работать быстро, экономично и надежно, решая задачи любой сложности без необходимости каждый раз начинать обучение заново.

В будущем важность таких технологий будет только расти. Появление новых архитектур, таких как State Space Models, способных работать с внешней памятью и обходиться без полной внимания по всему контексту, обещает перевернуть представление о возможностях масштабирования и производительности AI. Тем не менее, даже с их внедрением сохранится фундаментальная необходимость в продуманном и оптимальном конструктиве контекста, на который уже сегодня стоит делать ставку при создании агентных систем. Контекстное проектирование постепенно становится ключевой точкой роста для разработки продвинутых AI-агентов. Владение этим инструментом позволяет создавать системы, которые не просто реагируют на команды, а ведут постоянный диалог с пользователем и окружением, запоминая, адаптируясь и совершенствуясь на ходу.

Именно такие решения определят будущее искусственного интеллекта и его интеграцию в повседневную жизнь и индустриальные процессы.