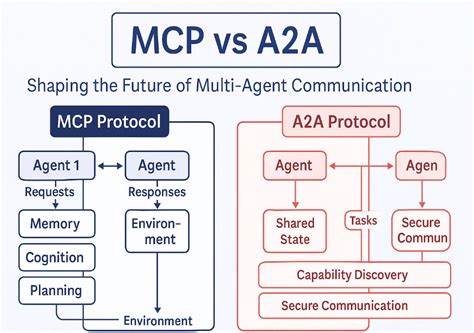

Модель Контекст Протоколов (MCP) изначально обещала кардинально изменить работу с большими языковыми моделями (LLM), обеспечивая динамичное взаимодействие с внешними инструментами и сервисами. Главный замысел MCP — превратить ИИ в активного помощника, способного выполнять задачи в реальном времени через подключение к реальным API и ресурсам. Несмотря на привлекательность идеи, первые реализации большинством разработчиков вызывают разочарование — агенты ведут себя медленно, нагрузка растет, а результат получается слабоэффективным. Почему это происходит и как улучшить работу MCP агента, чтобы добиться высокой производительности и действительно полезных решений? Попробуем разобраться в деталях. Первичная ошибка многих интеграций MCP заключается в неверном подходе к подключению инструментов.

Большинство разработчиков стремятся подключить максимально возможный каталог API, перекладывая на модель всю сложность обработки и анализа данных. В результате страдает производительность: большие объемы данных вызывают задержки, превышение лимитов токенов становится обычным явлением, а модели теряют способность эффективно планировать и принимать решения. Проблема кроется в том, что MCP агенты зачастую рассматриваются как простые терминальные операторы — посредники, которые только передают запросы и ответы, без осмысленного управления информацией. Такая стратегия приводит к громоздкому, неструктурированному взаимодействию с API. Возникают чрезмерно длинные контексты, когда информация повторяется многократно, что снижает способность модели к выводу и планированию.

В качестве яркого примера служит ситуация с вызовом функции списка заявок (list_issues) из системы управления проектами (например, Linear) с изначальным пределом в 50 заявок. Ответ в формате JSON, содержащий подробности каждой заявки, может занять более 15 тысяч токенов. Это почти сразу исчерпывает контекстные ресурсы модели и делает её реакцию медленной и неэффективной. Ключевое решение заключается в установке жестких лимитов на количество данных, возвращаемых каждому API-вызову, чтобы избежать «взрыва» контекста. Оптимальной практикой является сокращение выборки до 8 или другого разумного количества и дублирование вызова по частям при необходимости.

Также важно внедрять оценку стоимости с точки зрения токенов перед выполнением запроса, что позволяет планировщику оптимизировать траекторию вызовов. Еще одним распространенным анти-паттерном является подход к отображению больших таблиц данных. Часто агенты сначала запрашивают полный список данных, затем делают множественные запросы для получения подробностей по каждой записи, а затем просят модель консолидировать информацию в формате Markdown таблицы. Это приводит к значительному раздуванию контекста, увеличению времени отклика и потере структуры данных. Решение заключается в оптимизации на стороне сервера или инфраструктуры агента.

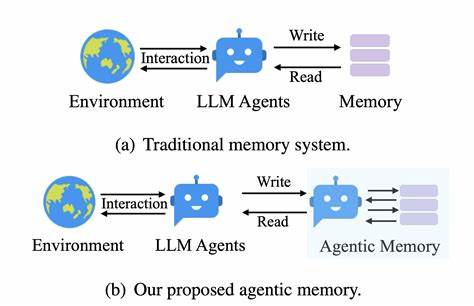

Вместо того чтобы пересылать огромные объемы данных, стоит один раз получить и кешировать необходимую информацию. Возвращать моделью компактное отображение идентификаторов и ключевых полей либо формат CSV, после чего проводить преобразования и визуализацию с помощью локального исполнения кода — например, с использованием библиотек для работы с таблицами и данными, таких как pandas. Это позволяет модели сосредоточиться на логических выводах, а не на рутинной обработке данных, что значительно повышает общую эффективность. Основные принципы успешного дизайна MCP агентов строятся вокруг контроля объема контекста и осмысленного планирования запросов к API. Жесткое ограничение на количество токенов, выдаваемых каждому инструменту, предотвращает перенасыщение контекста и обеспечивает предсказуемую производительность.

Наличие специальных эндпоинтов или функций оценки стоимости API-вызовов позволяет предусмотреть оптимальные маршруты взаимодействия, минимизируя потребление ресурсов. Особое внимание уделяется агрегированию ответов — большие массивы данных сводятся в компактные, понятные модели отображения, которые легче обрабатывать и интерпретировать. Возможность использовать локальное выполнение кода для работы с результатами позволяет снять нагрузку с модели и инфраструктуры, ускорить взаимодействие и избежать многократных обращений к тем же данным. Не менее важным аспектом является кэширование каталога API и результатов частых запросов, благодаря чему исключается необходимость повторного перечисления или повторного запроса данных на каждом шаге диалога. Такая практика позволяет существенно уменьшить задержки и повысить стабильность работы агента.

В компании AutonomyAI предложен собственный уникальный подход к реализации MCP агентов, основанный на строгом структурировании каждого элемента интеграции и применении внутреннего фреймворка TripleR. Данный фреймворк состоит из трех ключевых элементов: Retrieval, Representation и Reuse. Первый шаг — Retrieval — обеспечивает выборку только наиболее релевантных данных для текущей задачи модели, что экономит токены и ускоряет обработку. Второй этап — Representation — представляет данные в оптимальном для модели виде, делая их максимально информативными и при этом лаконичными. Третий элемент — Reuse — направлен на обеспечение устойчивого воспроизведения результатов модели при повторных запросах с одинаковыми входными данными, что важно для надежности и согласованности в работе агента.

Такой комплексный подход отлично справляется с работой на масштабных кодовых базах и больших наборах информации, делая MCP не просто промежуточным соединением, а полноценным интеллектуальным партнером. Мир современных языковых моделей и их расширение за счет интеграции в реальные системы требует не только подключения API, но и тщательной продуманной архитектуры взаимодействия. Простой «врезки» большого набора инструментов в контекст модели недостаточно — высокий ROI и производительность достигаются только при активном управлении объемом данных, умном планировании и использовании вспомогательных технологий. В противном случае MCP агент становится бесполезным и даже вредным звеном в рабочем процессе, создавая загрузки и задержки без реальной пользы. Если вы планируете запуск собственного MCP агента, задумайтесь: действительно ли текущая интеграция позволяет модели задумываться и принимать решения, или это лишь бессмысленное увеличение объема промптов? Сделайте акцент на оптимизации, кэшировании и локальной логике, чтобы максимум возможностей LLM стала использоваться во благо ваших задач.

Заключением можно сказать, что правильный MCP — это не просто интерфейс к API, а интеллектуальный помощник, способный анализировать, планировать и эффективно взаимодействовать. Компания AutonomyAI демонстрирует реальный пример таких агентов в работе, подчеркивая, что грамотный дизайн и продуманный подход — ключ к успеху в эре ИИ и больших моделей.