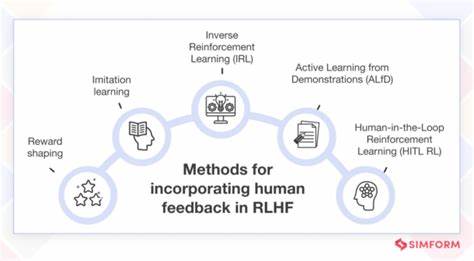

Обучение с подкреплением на основе человеческой обратной связи, известное как RLHF, стремительно набирает популярность в области искусственного интеллекта. Эта методика предоставляет новые возможности для тонкой настройки больших языковых моделей, таких как GPT-3 или GPT-2, делая их более чувствительными к намерениям пользователей и способными генерировать более точные и желаемые ответы. В основе RLHF лежит комбинация машинного обучения и взаимодействия с человеком, когда система учится на оценках и предпочтениях, предоставленных людьми, а не только на классических алгоритмах вознаграждения, что кардинально повышает качество конечных результатов. В данной работе рассматривается практическое применение RLHF с помощью трех Jupyter ноутбуков, что позволяет поэтапно понять и реализовать этот инновационный процесс в формате пошагового обучения и оптимизации моделей. Сам принцип RLHF можно охарактеризовать как метод, в котором обучаемая языковая модель не просто получает мгновенный отклик или вознаграждение от внешней среды, а сначала обучается посреднической системе – модели вознаграждения.

Эта модель вознаграждения представляет собой отдельную нейросеть, которая имитирует человеческую оценку качества ответов и служит ориентиром для дальнейшей тренировочной работы основной языковой модели. Насколько эффективно работает RLHF, определяется качеством этой системы оценки и умением её корректно обучать. Основные шаги процесса RLHF включают в себя сначала супервизированное дообучение модели, затем создание и обучение модели вознаграждения, и в конце – применение методов обучения с подкреплением, конкретно алгоритма Proximal Policy Optimization (PPO), для максимизации положительных откликов со стороны модели вознаграждения. Это дает возможность не просто моделировать взаимосвязи в тексте, но и адаптироваться к сложным, иногда субъективным запросам пользователей, делая взаимодействие с моделью более естественным и продуктивным. Для практической реализации RLHF в этом проекте использовалась GPT-2 — достаточно мощная, но при этом доступная и хорошо изученная модель, что делает ее идеальной для образовательных целей и экспериментов.

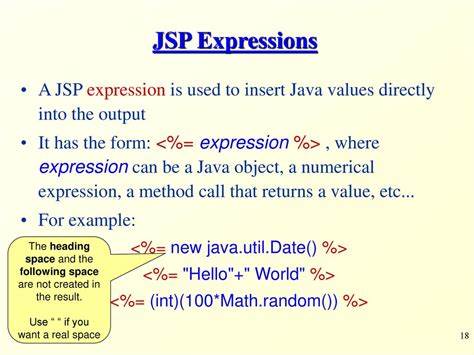

В качестве целевой задачи была выбрана генерация предложений с положительной эмоциональной окраской, используя популярный датасет stanfordnlp/sst2, состоящий из коротких обзоров фильмов с пометками о позитивном или негативном настроении. Такой выбор позволяет сосредоточиться на применении RLHF для улучшения опытной генерации текстов в конкретной семантической области. Первый этап, описанный в ноутбуке "1-SFT.ipynb", посвящен супервизированному дообучению GPT-2 на наборе данных с эмоциональными метками. В процессе этого шага модель обучается предсказывать следующие токены текста с учетом контекста, то есть она начинает понимать структуру и содержание предложений с положительным настроением.

Результатом является вес модели, оптимизированный на генерацию подобного текстового контента, что создает основу для дальнейшего более тонкого обучения. На следующем этапе, описанном в ноутбуке "2-RM Training.ipynb", создается специальная модель вознаграждения. Для этого к архитектуре GPT-2 добавляется дополнительная «голова» — нейронный слой, предназначенный для оценки качества текста с точки зрения позитивности. Модель вознаграждения обучается распознавать, насколько сгенерированное предложение соответствует положительной эмоциональной окраске, используя те же датасеты.

Это позволяет, условно говоря, «перевести» человеческую оценку эмоционального содержания в числовой балл, который затем можно использовать для обучения основной модели в режиме подкрепления. Финальный и наиболее сложный этап реализуется в ноутбуке "3-RLHF.ipynb", где применяется алгоритм Proximal Policy Optimization. Здесь модель, начиная с весов, полученных после супервизированного обучения, генерирует предложения на основе входных данных, которые затем оцениваются моделью вознаграждения. На основе этих оценок происходит изменение параметров модели так, чтобы повысить вероятность генерации позитивных, высоко оцененных ответов.

Использование PPO обеспечивает стабильность обучения и предотвращает чрезмерное отклонение от исходной модели, поддерживая баланс между исследованием новыхфраз и сохранением успешных шаблонов. Особенно важно отметить, что данная реализация предоставляет все необходимое для работы в среде Jupyter ноутбуков, что значительно облегчает процесс обучения и экспериментов с RLHF. Инструкции по установке окружения и необходимые настройки, такие как получение токена доступа Hugging Face, позволяют быстро запустить процесс обучения даже тем специалистам, которые только начинают работать с крупномасштабными языковыми моделями. Такие полнофункциональные и структурированные примеры крайне важны для развития качественного образования и популярных практик машинного обучения. Применение RLHF выходит далеко за рамки генерации текстов с определенной эмоциональной окраской.

Данная методика открывает перспективы для создания более корректных, интуитивных и этически ориентированных моделей, которые могут адаптироваться под потребности пользователя и эффективно взаимодействовать в широком спектре задач, начиная с диалоговых систем и заканчивая сложным контентным моделированием. Возможность включения человеческой обратной связи напрямую в процесс оптимизации моделей существенно повышает их полезность и снижает количество нежелательных или некорректных ответов. Стоит отметить, что сообщество разработчиков активно делится результатами и кодом, что позволяет быстро внедрять передовые методы и расширять функциональность машинного обучения на основе RLHF. Использование открытых платформ как GitHub и Hugging Face способствует развитию экосистемы, где каждый может получить доступ к высоким технологиям и провести эксперименты в удобной и гибкой форме. Такой подход стимулирует инновации, формирует новые знания и расширяет возможности искусственного интеллекта в целом.

В заключение, RLHF — это эффективный инструмент для доработки языковых моделей, интегрирующий в себя современное машинное обучение и естественное взаимодействие с пользователем через человеческие оценки. Реализация в формате Jupyter ноутбуков предоставляет практическое руководство, позволяющее понять и освоить все ключевые составляющие метода на конкретном примере GPT-2 и задачи генерации позитивных текстов. Эти наработки станут хорошей основой для специалистов, желающих погрузиться в перспективную и быстро развивающуюся область обучения с подкреплением, обогащенного человеческой обратной связью.