В мире программирования становится всё более востребованной разработка высокопроизводительных и надежных компонентов, способных эффективно взаимодействовать в многопоточных средах. Кеширование как важнейшая техника оптимизации работы программных систем требует особого подхода к реализации, учитывающего безопасность, скорость и отказоустойчивость. В этом контексте внимание заслуживает реализация потокобезопасного кеша на современном языке Rust, использующего продуманную стратегию управления памятью и вытеснением кэширующих данных. Особенность предлагаемого решения заключается в отсутствии использования небезопасного кода (unsafe) и применении алгоритма вытеснения S3-FIFO, который обеспечивает предсказуемое и эффективное управление кешируемыми элементами. Rust все больше завоевывает популярность среди разработчиков, особенно когда речь идет о написании системного и высокопроизводительного кода, где важна безопасность памяти и параллелизм.

Благодаря строгой системе типизации и встроенным средствам управления памятью, этот язык позволяет создавать надежные программы без традиционных ошибок, типичных, например, для C и C++. Особый интерес представляет реализация кеша на Rust без привлечения unsafe-блоков, поскольку это гарантирует полную проверяемость кода компилятором и безопасную работу приложения в многопоточных сценариях. Прототип высокопроизводительного кеша разработан с акцентом на потокобезопасность и минимизацию блокировок при параллельном доступе. Благодаря шардированному дизайну кеша удается снизить конкуренцию потоков за общие ресурсы, что положительно сказывается на производительности. Каждый шард содержит собственные замки и структуры данных, что позволяет обрабатывать большое количество обращений в конкурентной среде практически без задержек.

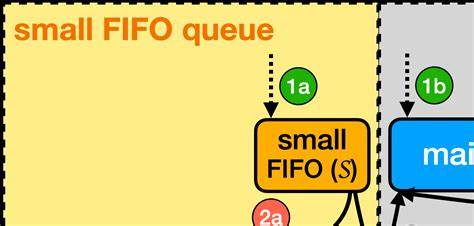

Ключевым аспектом работы кеша является алгоритм вытеснения S3-FIFO, основанный на интуитивно понятном и эффективном способе удаления устаревших элементов. Из названия следует, что метод сочетает три стадии отбора кандидатов на удаление, что повышает качество предсказания и стабильность кеша, при этом упрощая логику по сравнению с более сложными эвикшен-стратегиями, такими как LRU или LFU. FIFO компонент оптимизирует работу по очереди добавленных в кеш элементов, удаляя самые старые при необходимости освобождения места. Оптимизация распределения памяти является важной частью архитектуры кеша. Вместо динамического выделения и освобождения памяти в процессе работы, кеш при инициализации выделяет фиксированный объем памяти, что позволяет значительно ускорить работу за счет отсутствия накладных расходов на аллокацию во время исполнения и предотвращает фрагментацию памяти.

Подобный подход улучшает предсказуемость производительности и уменьшает количество непредвиденных задержек. Практическая реализация кеша опирается на простую и понятную API, что облегчает интеграцию и использование в различных приложениях. Разработчики могут быстро добавлять элементы с помощью метода insert и получать их через get, не углубляясь в сложные механизмы внутренней работы кеша. Это снижает порог вхождения и позволяет сосредоточиться на бизнес-логике, не тратя много времени на кастомизацию кеша. Еще одним преимуществом выбранного подхода является отсутствие фоновых потоков или задач, что упрощает многопоточное взаимодействие и снижает вероятность возникновения гонок или дедлоков.

При этом функция мониторинга состояния кеша встроена непосредственно в его реализацию, обеспечивая метрики по количеству попаданий, промахов, вытеснений и времени операций, что позволяет анализировать и оптимизировать производительность в реальных условиях. Поддержка кастомных алгоритмов хеширования расширяет сферу применения кеша, позволяя адаптировать работу с данными под особенности конкретного проекта. Выбор подходящего хеш-функции может увеличить равномерность распределения по шартам и улучшить время доступа к элементам. Стоит отметить, что разработанный кеш не ориентирован на работу с нулевыми по размеру типами, не предоставляет сложных хуков жизненного цикла элементов и не поддерживает взвешивание элементов по их стоимости или объему, а также не реализует временное удаление или политики на основе времени жизни. Эти ограничения связаны с целью сохранить простоту, скорость и надежность решения, что зачастую важнее для высоконагруженных систем.