В современном цифровом мире искусственный интеллект (ИИ) занимает всё более значимое место, проникая в разные сферы деятельности — от бизнеса и медицины до повседневного общения и развлечений. Вместе с тем, наряду с растущими возможностями, появляется новая тенденция — использование ИИ в качестве механизма для перекладывания ответственности и обвинений. Этот феномен демонстрирует, как AI становится своего рода «щитком», который позволяет избегать личной или корпоративной вины, возлагая её на алгоритмы и машины. Несмотря на кажущуюся инновационность и удобство такого подхода, он таит в себе множество проблем, как этических, так и практических, которыми стоит детально разобраться. Технологии искусственного интеллекта сегодня широко применяются для автоматизации процессов, принятия решений и даже выполнения творческих задач.

Однако этот автоматический характер действий иногда воспринимается как способ объективно объяснить любые сбои и ошибки. Если какой-то проект не удался, пользователь получил неверную информацию, или техническая система дала сбой — виноватым становится «ИИ», а не конкретные люди или компании, которые отвечают за внедрение и контроль. Такой механизм «снятия ответственности» снижает давление на специалистов и руководителей, позволяя им скрываться за неведомым и, по мнению многих, не подотчётным интеллектом. При этом важно понимать, что даже самые передовые AI-системы создаются, обучаются и сопровождаются людьми. Алгоритмы могут принимать решения на основе данных и прописанных правил, но именно человеческий фактор формирует эти данные и задаёт параметры.

Ошибки в исходных данных, недочёты в программировании и неправильное внедрение ведут к нежелательным результатам, но в ответ на них часто звучит фраза «виноват ИИ», что является упрощением проблемы. Такой подход мешает выявить истинные причины, изучить ошибки и улучшить процессы. Следствием подобного поведения становится снижение качества ответственности и этики в IT-индустрии и за её пределами. Когда за неблагоприятный исход прячутся за безличным ИИ, компании и люди теряют стимул к профессиональному развитию и контролю. Более того, это создаёт почву для злоупотреблений — технологии могут использоваться для оправдания неправомерных действий или игнорирования общественных норм.

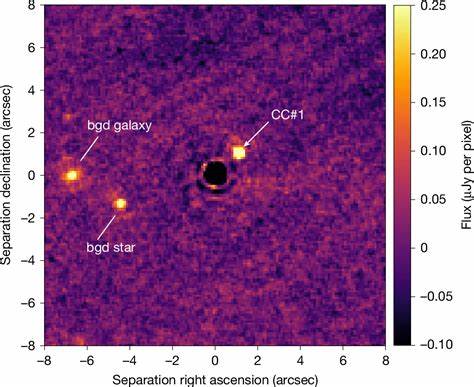

Например, в ситуациях с дискриминацией или ошибочными решениями, принятыми алгоритмами, часто переводят внимание с реальных виновников на непредсказуемость ИИ. С точки зрения этики это поднимает важные вопросы о прозрачности и подотчётности. Куда девается ответственность, если действия аппарата объясняются как программное «решение»? Какие последствия ждут общества, если присваивание вины машине становится нормой? В ответ на вызовы в законодательных и общественных кругах начинает формироваться движение за усиление контроля и правового регулирования использования ИИ, чтобы избежать безответственного применения технологий. Интересно заметить, что в медиа и среди широкой аудитории восприятие искусственного интеллекта часто связано с мистификацией и неопределённостью. Видео с примерами неправильных решений ИИ, в которых алгоритм преподносится как нечто неуправляемое и даже сознательное, формируют у пользователей определённый образ ИИ — непредсказуемого и в то же время сильного.

Это предупреждает о необходимости создавать грамотный медиаподход и образование, чтобы не допустить манипуляций общественным мнением и не стать жертвами ложно направленной критики. С другой стороны, ИИ может служить полезным инструментом для повышения эффективности и оптимизации труда, если за ним внимательно следят и им управляют компетентные люди. Только с осознанием человеческой ответственности за его работу возможно построение гармоничного взаимодействия между технологиями и обществом. Необходимо формировать культуру, в которой ошибки будут признаваться как часть сложного процесса, а технические ошибки — анализироваться как повод для улучшения, а не повод для уклонения от ответственности. В заключение следует отметить, что восприятие искусственного интеллекта как «щита» для снятия вины — это скорее симптом текущих вызовов, связанных с регулированием и культурой использования новых технологий.

В будущем ожидается, что развитие правовых норм, повышение прозрачности алгоритмов и совершенствование человеческих компетенций помогут минимизировать такие негативные тенденции. Ответственный подход к использованию AI позволит не только улучшить качество продуктов и услуг, но и сформировать справедливые и эффективные механизмы ответственности, которые устранят культуру обвинений в адрес бездушных машин и вернут должное значение человеческому фактору.

![AI as a blame deflector shield [video]](/images/00A17D88-BF10-4873-99D6-2A50E3EBA52A)