Docker Compose давно стал неотъемлемой частью экосистемы разработки и развертывания контейнеризованных приложений. Благодаря своей простоте и гибкости, он позволяет разработчикам легко настраивать мультиконтейнерные среды с минимальными затратами времени и усилий. Однако стремительное развитие технологий искусственного интеллекта и роста требований к специализированным вычислительным ресурсам, таким как GPU и специализированные модели для AI, вызвало необходимость расширения функционала Compose. Совсем недавно в версии Docker Compose 2.38.

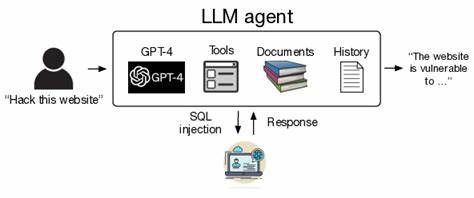

0 была введена поддержка новой сущности — <models>. Это обновление призвано кардинально упростить интеграцию и управление AI-нагрузками в контейнерных окружениях. <models> в Compose позволяют описывать и управлять искусственными нейронными сетями и другими AI-моделями непосредственно на уровне конфигурации, реализуя более тесную связь между развертываемым приложением и задействованными в нем вычислительными моделями. Традиционные подходы к работе с AI в контейнерных средах часто требуют сложного взаимодействия между несколькими инструментами и вручную настраиваемыми скриптами для работы с моделями, что увеличивает вероятность ошибок и снижает скорость разработки. Новая спецификация с <models> снимает эти барьеры, предлагая унифицированный способ описания моделей в yaml-файле Compose, что значительно упрощает развертывание и масштабирование AI-сервисов.

Внедрение <models> не только облегчает описание и использование различных моделей, но и обеспечивает высокую степень совместимости с существующей инфраструктурой Docker. Это означает, что разработчики могут всего в одном файле описать параметры контейнеров, объемы, сети и одновременно — конкретные модели, которые необходимы их приложениям. Благодаря этому можно управлять ресурсами AI-компонентов более гибко, назначать специальные GPU или другие аппаратные ускорители только тем сервисам, которые в них реально нуждаются. В обновлении были исправлены и некоторые технические нюансы. Теперь Docker Compose умеет точнее обрабатывать зависимости, исключая лишние сервисы из блокировки запуска, что особенно актуально в сложных AI-ориентированных системах с множеством микросервисов.

Добавлена возможность монтировать сокет Docker API в контейнер для реализации более тесного взаимодействия с механизмами управления и мониторинга. Это повышает безопасность и удобство эксплуатации сред с AI-нагрузками. Улучшения позволили организовать эффективный билдинг и запуск моделей с использованием Bake, что способствует более быстрому и надежному выгрузке образов с AI-модулями. Также внедрена поддержка переменных окружения на уровне проекта, что ускоряет настройку и автоматизацию процессов CI/CD. Все это делает работу с AI проектами в Docker еще более предсказуемой и управляемой.

Еще одним важным аспектом стало активное участие сообщества разработчиков. Внесенные правки и нововведения были результатом усилий нескольких авторов, что подчеркивает широкий интерес и необходимость таких функций в современном IT-секторе. Такой подход гарантирует, что новшества будут соответствовать реальным потребностям и продолжат развиваться с учетом обратной связи от пользователей. В практическом применении поддержка <models> открывает большие возможности для компаний, занимающихся разработкой и развертыванием AI-сервисов. Сокращается время от идеи до рабочего прототипа, упрощаются тестирование и масштабирование моделей, что критично в условиях высокой конкуренции и быстро меняющегося рынка.

Тематики, связанные с машинным обучением, глубокими нейронными сетями и аналитикой больших данных, получают новый уровень удобства развертывания и эксплуатации. Эффективное использование обновленной спецификации даст бизнесу значительные преимущества. Организации могут оптимизировать ресурсы, снижая затраты на инфраструктуру и администрирование, ускорять выход новых продуктов на рынок, а также улучшать качество и стабильность работы AI-систем. Все эти факторы позитивно отражаются на общей конкурентоспособности и инновационном потенциале. Стоит также отметить, что Docker активно работает над развитием экосистемы с учетом специфики AI и ML.

Интеграция <models> в Compose — лишь один из шагов в создании мощной платформы, позволяющей объединить контейнеризацию с современными технологиями искусственного интеллекта. Пользователям предлагаются инструменты для автоматизации, мониторинга и управления, которые ранее требовали использования множества разрозненных решений. Таким образом, последнее обновление Docker Compose, включающее поддержку <models>, знаменует собой важный этап в развитии контейнерных технологий для AI-нагрузок. Оно предлагает разработчикам удобные и гибкие средства для описания, развертывания и масштабирования AI-моделей непосредственно внутри привычного инструментария Docker. Ожидается, что это новшество существенно повысит скорость и качество разработки AI-приложений, сделает процесс более прозрачным и управляемым.