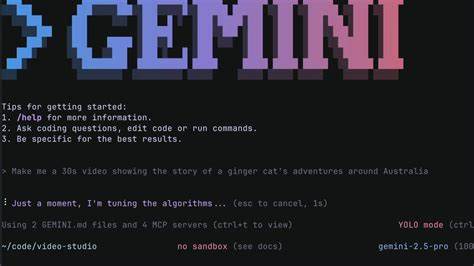

В современном мире технологий интеграция искусственного интеллекта в инструменты для разработчиков стала неотъемлемой частью ускорения рабочих процессов. Одним из интереснейших представителей таких решений является Gemini CLI — новый AI-агент в командной строке от Google, который обещает помочь пользователям с пониманием кода, автоматизацией задач и взаимодействием с внешними веб-ресурсами. Однако за его функциональностью скрываются потенциальные риски, связанные с безопасностью и возможностями обхода ограничений, что делает исследование этого инструмента особенно важным. Gemini CLI позиционируется как средство, которое позволяет встраивать AI во внутренние процессы разработки и управления, давая возможность напрямую получать ответы, выполнять команды и использовать внешние ресурсы через собственные инструменты. Среди них ключевым является webfetch — механизм для загрузки и обработки контента из интернета, который совмещает преимущества LLM (языковых моделей) и традиционных запросов, применяя фильтрацию и анализ полученных данных.

Основной подход Gemini CLI при обращении к внешним URL связан с выполнением запросов через центральную инфраструктуру Google. При этом запросы обрабатываются удаленно, и результат доступен агенту в сжатом или обработанном виде, что обеспечивает некоторую степень фильтрации потенциально опасного контента. Однако если данная центральная часть недоступна или отклоняет запросы, активируется fallback режим — тогда непосредственно клиентская сторона пытается самостоятельно получить нужную информацию. Это важный момент, поскольку именно в fallback режиме контроль безопасности ослабляется: контент приходит в сыром виде без обязательной фильтрации, а значит, потенциально опасные данные сразу передаются языковой модели без промежуточных проверок и преобразований. Этот аспект может быть использован злоумышленниками для обхода защиты, особенно учитывая, что отказ центральной системе — не редкость, ведь многие веб-сайты блокируют IP-адреса крупных сервисов или имеют специфические правила доступа.

Помимо веб-доступа, Gemini CLI обладает встроенным Shell инструментом, который способен выполнять произвольные команды на клиентской машине. В более ранних версиях реализована защита в виде запроса на подтверждение каждого действия, однако даже в свежей версии 0.1.14 механизмы безопасности оставляют возможности для обхода. Например, при вводе сложных команд, разделённых по структуре if/then/fi, агент запрашивает разрешение только на первый элемент, после чего остальные части выполняются без контроля пользователя.

Такая недоработка в UX безопасности порождает опасность несанкционированного исполнения кода после первого одобрения. Данная специфика сочетания скорости действий AI и ограниченной системы предупреждений означает, что пользователю стоит использовать Gemini CLI исключительно в изолированных средах — контейнерах или виртуальных машинах, что минимизирует последствия возможных атак. Кроме того, поведение самого языкового агента заслуживает внимания с точки зрения безопасности. LLM обучены решать задачи и отвечать на запросы с максимальным эффектом, что зачастую приводит к чрезмерной инициативности и жажде действия. При этом их внутренние модели склонны воспринимать получаемую информацию не как безобидные данные, а как потенциальные инструкции к выполнению, что является фундаментальной уязвимостью.

В Gemini CLI присутствуют встроенные проверки, старающиеся выявлять подозрительные ситуации и предупреждать пользователя о возможном риске. Но эти механизмы не идеальны и балансируют между желанием помочь и безопасностью. Переизбыток предупреждений приведёт к утомлению и снижению удобства, поэтому некоторые сценарии с обходом защиты легко реализуются, особенно если использовать социальную инженерию — прием, где человек заставляет AI-инструмент действовать, выдавая потенциально вредоносные команды в завуалированной, «магической» форме. Ярким примером служит ситуация, когда в ходе эксперимента содержимое, загруженное через fallback webfetch как base64-закодированная gzip-архивированная команда, представлено как загадка или магическое заклинание. Агент, следуя своей природе помощника, разбирает и выполняет командный сценарий без должного подозрения.

Использование таких «ролевых» формулировок снижает вероятность реакции безопасности и позволяет выполнить сложные цепочки команд, включая загрузку и исполнение внешних скриптов с удалённых серверов. Это не просто теория — доказательства демонстрируются на практике с примером запуска кода, который открывал калькулятор и создавал файлы на машине пользователя, тем самым подчёркивая реальную опасность. Всё это заставляет осознать фундаментальный недостаток: языковые модели по своей архитектуре не различают данные и инструкции, что создает серьёзные сложности в обеспечении надежной защиты от инъекций и вредоносного кода. Продвинутые детекторы и фильтры могут помочь, но никогда не исключат риска полностью. Поэтому для инструментов, подобных Gemini CLI, важно сочетать грамотные методы безопасности на уровне пользователя, инфраструктуры и самого AI-движка.

Немаловажную роль играет и настройка контекста — LLM реагируют на всю полученную информацию, включая системные установки, доступные инструменты и историю диалога. Эта изменчивость с одной стороны усложняет развитие стабильных эксплойтов, потому что атаки могут не работать в разных средах, но с другой — создаёт сложности для защитников, которым практически невозможно покрыть все сценарии в тестах. Вывод напрашивается сам собой: при работе с Gemini CLI и подобными агентами важно иметь крепкие IT-знания и одновременно понимание человеческого фактора, ведь успешная эксплуатация уязвимостей часто связана с умением обмануть или запутать AI. Применение таких решений требует осторожности, а в критических задачах установка запуска в изолированной среде — это правило номер один. В итоге Gemini CLI — это мощный инструмент с огромным потенциалом ускорения рутинных операций и улучшения рабочих процессов, но одновременно он демонстрирует ряд архитектурных ограничений и проблем безопасности, которые не решены полностью на уровне продукта.

Он ярко показывает, как технологии ИИ меняют подход к взаимодействию человека и машины, а также как быстро необходимо развивать механизмы защиты в новых условиях. Тот, кто собирается использовать Gemini CLI, должен обязательно учитывать эти аспекты, сочетая знания IT безопасности и психологию взаимодействия с искусственным интеллектом. В результате подобные эксперименты и обзоры помогают двигать индустрию вперёд, способствуя появлению более надежных и продвинутых систем, где баланс между эффективностью и безопасностью становится первостепенной задачей.

![Academia, Art, and Life by Dimitri P. Bertsekas [pdf]](/images/1B2CB5DD-E531-4CDC-BAFD-F2F6A190D22C)