В эпоху стремительного развития искусственного интеллекта многие компании стремятся внедрить чатботы, основанные на больших языковых моделях (LLM), чтобы улучшить взаимодействие с клиентами, автоматизировать поддержку и снизить операционные издержки. На первый взгляд, задачи, связанные с разработкой таких систем, кажутся вполне посильными: доступ к мощным моделям, таким как OpenAI или Anthropic, упрощает создание прототипов, способных вести осмысленные беседы. Однако на практике большинство проектов так и не переходят от пилотной фазы к полноценному запуску в продуктив. Почему так происходит и какие ключевые проблемы мешают реализовать потенциал этих технологий на деле? Важно понимать, что задержка связана не только с техническими сложностями, но и с бизнес-процессами, доверием и управлением рисками, которые зачастую оказываются гораздо сложнее преодолимыми, чем простая настройка модели. Одним из главных препятствий на пути к внедрению является недостаток доверия со стороны бизнес-руководителей, отделов комплаенса и службы безопасности.

Для них чатбот - это не только потенциальный инструмент повышения эффективности, но и источники значительных рисков, особенно когда речь идет о взаимодействии с чувствительной информацией, нормативным соответствием и высокими требованиями к точности ответов. В этом контексте главным вопросом становится не возможность "заставить бот говорить", а гарантия, что ответы будут корректными, безопасными и неподверженными ошибкам, таким как галлюцинации моделей - когда AI придумывает ложную или неточную информацию. Путь к доверию начинается с тщательного измерения и верификации качества работы системы. Бенчмаркинг - это не просто тестирование, а своего рода аудит, который позволяет оценить уровень точности, полноты и надежности чатбота в реальных сценариях взаимодействия с пользователями. Компании должны определить критерии успеха с учетом специфики отрасли.

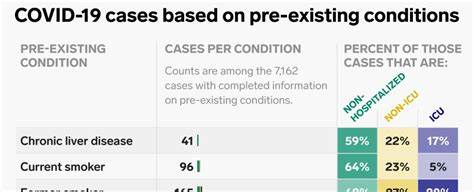

Например, в финансовом секторе допустимый уровень ошибок будет чрезвычайно низким, особенно по запросам, касающимся нормативных и юридических аспектов, а в сфере здравоохранения требования к точности ответов на вопросы о лекарствах или диагнозах куда жестче. Важно, чтобы проверочные тесты отражали не только типичные "счастливые пути", но и редкие, сложные случаи, которые могут повлиять на репутацию компании или привести к штрафам и судебным разбирательствам. Для формирования надежного набора данных для обучения и оценки чатбота необходимо использовать разнообразные источники. Внутренние экспертные знания обеспечивают точность, но могут быть ограничены по охвату. Данные от клиентов и партнеров приближают систему к реальным запросам, однако их сбор требует времени.

Синтетические данные позволяют масштабировать процесс, но без должной проработки способны внести искажения. Лог-файлы предыдущих систем содержат жизнеспособные примеры, подходящие для анализа, но требуют ручной разметки и очистки. Оптимальное решение - гибридный подход, объединяющий сильные стороны каждого типа данных, чтобы создать максимально реалистичное, репрезентативное и масштабируемое обучающее пространство. Как только выявляются недостатки модели, не стоит заниматься массовой переподготовкой на всех имеющихся данных. Лучше сфокусироваться на проблемных зонах, особенно в частях, где ошибки могут привести к серьезным бизнес-рискам.

Такой целенаправленный fine-tuning обеспечивает более эффективное использование ресурсов и быстрее приводит к снижению количества ошибок в приоритетных сценариях. После того как базовая надежность чатбота подтверждена, наступает время для тщательной проверки на прочность - так называемого red teaming. Аналогично тестированию на взлом у киберсистем, red teaming с применением сложных, нестандартных и провокационных запросов позволяет выявить слабые места модели, которые она может скрывать в обычных условиях. Этот этап обязателен для проектов, связанных с критичными и регулируемыми процессами. При этом тестирование должно быть кросс-функциональным: подключать к нему не только инженеров и исследователей AI, но и специалистов по комплаенсу, юридических консультантов и лидеров службы поддержки.

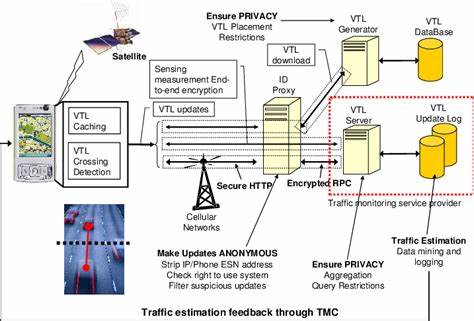

Совместное участие помогает на ранних стадиях сформировать культуру доверия и ответственности. Еще один критически важный момент - после вывода чатбота в продуктивное использование нельзя останавливаться на достигнутом. Поведение больших языковых моделей может изменяться со временем из-за обновлений, изменений в правилах, сдвигов в пользовательских запросах и других факторов. Необходим постоянный мониторинг ключевых показателей качества: точности, частоты ошибок и галлюцинаций, а также анализ отклика конечных пользователей. Недовольные оценки, обращения к живым операторам и высокая частота отказов сигнализируют о необходимости корректировок и обновлений.

Современные решения предусматривают интеграцию непрерывной проверки качества и автоматизированных процессов обучения моделей на новых данных с учетом выявленных проблем. Такой подход превращает поддержку чатбота в циклический процесс постоянного улучшения, который становится неотъемлемой частью операционной деятельности компании. Компании, успешно выводящие LLM-чатботов в производство, фокусируют свои усилия на построении "масштабируемого доверия". Это значит не просто создать один работающий бот, а построить процессы, которые позволят поддерживать и улучшать его работу в долгосрочной перспективе. Основа такого доверия - прозрачность, измеримость, совместное тестирование и регулярный контроль.

Лишь тогда руководство перестает воспринимать чатбота как рискованный эксперимент и видит в нем надежный рабочий инструмент. Помочь в этом может специализированная инфраструктура, обеспечивающая комплексный подход к отметке данных, мониторингу и дообучению. Примером являются платформы вроде Label Studio Enterprise, позволяющие систематизировать сбор обратной связи, проводить целенаправленное обучение и поддерживать постоянный цикл повышения качества. Таким образом, рай для бизнеса - чатбот, который не только отвечает сегодня, но и становится лучше завтра, аккумулируя опыт, данные и аналитические выводы по мере эксплуатации. Для достижения успеха в производственном использовании чатботов на базе больших языковых моделей одной лишь мощности или актуальных знаний недостаточно.

Ключевым является комплексный, системный подход, включающий стратегию управления рисками, подготовку и качественную верификацию данных, вовлечение ключевых бизнес-стейкхолдеров и непрерывный процесс контроля и улучшения. Преодоление барьеров доверия и обеспечение реальной пользы от технологии - это главный вызов и одновременно ключ к прорыву в массовом применении искусственного интеллекта в бизнесе. .