В современном мире, когда каждый шаг в интернете отслеживается и анализируется множеством инструментов, очень важно понимать, как работает ваш сайт с точки зрения поисковых систем и социальных сетей. Одним из инструментов управления этим взаимодействием выступает файл robots.txt — маленький, но мощный механизм контроля доступа для поисковых роботов и других агентов. Однако я недавно убедился на собственном опыте, что чрезмерно жесткие настройки могут привести к неприятным последствиям, о которых не всегда сразу задумываешься. Изначально я решил кардинально закрыть доступ всем краулерам к моему сайту, полагая, что это повысит мою защиту и позволит сохранить уникальность контента.

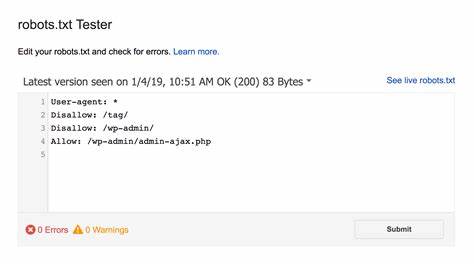

В моём robots.txt была прописана директива, запрещающая всем ботам индексацию любых страниц. Кажется логичным: меньше «шпионажа» — лучше контроль над сайтом. Однако такие ограничения оказались не столь безупречными, как я думал. Если вы когда-либо делились своими статьями или материалами в социальных сетях вроде LinkedIn, то наверняка заметили, что ссылки сопровождаются привлекательным превью — заголовком, изображением и небольшим описанием.

Они формируются на основе специальных метатегов, которые социальная сеть считывает, когда краулер посещает ваш сайт. Ключевую роль здесь играет протокол Open Graph — набор правил, который позволяет превратить любую страницу в полноценный графический объект. Основные метатеги Open Graph – og:title, og:type, og:image и og:url – передают платформам важную информацию, которая затем используется для создания визуально привлекательных и понятных превью. При отсутствии доступа краулеров к сайту эти данные остаются недоступными, и ссылки теряют свою «презентабельность». В моём случае ситуация развивалась именно таким образом.

После внесения изменений в robots.txt мои посты на LinkedIn перестали отображать корректные превью. Вместо информативных и ярких карточек пользователи видели просто сырые ссылки без визуального сопровождения. Кроме того, вовлечённость и охват моих публикаций начали падать — алгоритм социальной сети стал показывать их все реже. Чтобы разобраться в корне проблемы, я воспользовался инструментом LinkedIn Post Inspector.

Он позволяет проверить, как платформа видит и обрабатывает ссылку. В отчёте сканирования было ясно указано, что URL моего сайта и страницы заблокированы правилами robots.txt, поэтому бот не может собрать нужные метаданные. Это был важный урок. Я осознал, что строгий запрет на индексацию сайта может косвенно навредить продвижению контента в социальных сетях и снизить общий трафик.

Понимание связи между robots.txt и Open Graph Protocol было для меня ключевым моментом. Если ограничивать доступ всем подряд, страдают именно механизмы презентации и распространения информации, которые делают публикации заметными и привлекательными. Решением проблемы стала корректировка файла robots.txt, где я позволил LinkedInBot свободно сканировать сайт, а остальные краулеры по-прежнему остались под строгим запретом.

Такая адресная настройка позволила вернуть прежние превью для моих публикаций и значительно улучшила охват пользователей. Этот опыт показал, что управлять видимостью сайта нужно с максимальной аккуратностью и знанием дела. Для каждого кейса необходим вдумчивый подход и тестирование последствий. Зачастую желание полностью закрыть сайт от сканирования приводит к неожиданным эффектам, которые в конечном итоге могут навредить вашим рекламным и маркетинговым усилиям. Кроме того, я узнал, что для других социальных сервисов, например Facebook, Twitter, Instagram, необходимо давать разрешения соответствующим ботам.

Это связано с особенностями работы каждой платформы и спецификой сборки и отображения превью. Не существует универсального решения на все случаи, и в каждом случае следует проверять работу сайта с помощью соответствующих инструментов. Мой случай также подчёркивает важность знакомства с Open Graph Protocol — мощным инструментом для улучшения визуальной презентации контента в сети. Его внедрение становится стандартом для веб-разработчиков и маркетологов, поскольку эффективно увеличивает вовлечённость аудитории и улучшает пользовательский опыт. Понимание того, как работает robots.

txt, Open Graph и взаимодействие с различными социальными платформами, помогает избежать ошибок и правильно настроить сайт для максимальной эффективности. Важно помнить, что интернет — гибкая среда, где каждая деталь задаёт тон общей картине и результатам ваших усилий по продвижению. Если вы занимаетесь развитием своего сайта или блога, старайтесь внимательно относиться к изменениям в настройках, всегда проверяйте их влияние на все аспекты — от поисковой оптимизации до совместимости с социальными сетями. Важно суметь найти баланс между защитой контента и доступностью для тех инструментов, которые помогают расширять аудиторию. Мой опыт с robots.

txt научил меня одному простому, но важному правилу: прежде чем применять всеобъемлющие запреты, изучайте механизмы взаимодействия вашего сайта с интернет-сообществом. Иногда маленькие решения могут привести к большим последствиям. И иногда приходится сломать несколько яиц, чтобы приготовить хорошее омлет — в нашем случае, это значит допускать определённые боты для правильной работы сайта в цифровой экосистеме.