Введение в задачу подсчета токенов в репозиториях программного обеспечения является важным этапом для разработчиков, исследователей и команд, работающих с большими базами кода и современными языковыми моделями. Токены – это минимальные единицы текста, которые используются для обработки и анализа данных с помощью алгоритмов машинного обучения и языковых моделей. Стандартный подсчет токенов во всех файлах репозитория может привести к излишним затратам ресурсов и времени, особенно если в проекте присутствует большое количество временных, бинарных или сгенерированных файлов. Для решения этой проблемы применяется подход «Git-aware», позволяющий игнорировать файлы, которые уже исключены системой контроля версий Git с помощью файлового шаблона .gitignore.

Такой метод приносит ощутимые преимущества при анализе и оптимизации процессов, связанных с подсчетом и использованием токенов. В основе метода лежит взаимодействие с командой Git check-ignore, которая позволяет определить, игнорируется ли конкретный файл в рамках репозитория. Это обеспечивает точный отбор только тех файлов, которые действительно важны для подсчета токенов. Основная задача — обрабатывать каждый файл, не исключенный .gitignore, читать его содержимое и запускать подсчет токенов с помощью специализированных моделей, таких как Gemini от Google.

Этот подход позволяет избежать учета файлов, которые могут значительно исказить результаты, например, двоичных или собранных компонентов проекта, временных данных или папок настроек, что типично для директории .git. При организации сбора информации по токенам следует реализовать обход дерева каталогов с проверкой каждого файла и папки на соответствие правилам игнорирования Git. Для ускорения работы следует сохранять уже определенные игнорируемые пути, чтобы не проверять их повторно при входе в подкаталоги. В процессе чтения файлов важно предусмотреть обработку исключений, связанных с кодировкой, так как бинарные или поврежденные файлы не поддаются стандартному чтению в текстовом формате.

Это повысит стабильность и качество подсчета. Использование специализированных моделей для подсчета токенов, таких как gemini-2.5-flash, позволяет получить точные данные, которые учитывают особенности конкретной языковой модели и формата токенизации. Это особенно полезно для оценки затрат при использовании языковых моделей в задачах программирования, написания документации, рефакторинга кода и других автоматизированных сценариях. Хранение результатов подсчета в файлах вида filenames.

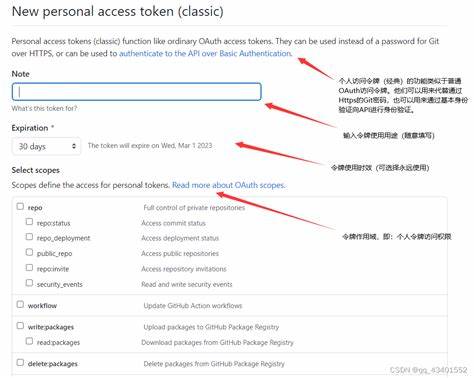

txt и tokens.txt дает удобный способ анализа и сортировки данных. Первый содержит список всех файлов с количеством токенов, отсортированный по имени файла, что помогает быстро найти нужный путь в репозитории. Второй — упорядоченный по убыванию количество токенов, что показывает, какие части проекта требуют наибольших ресурсов при обработке. Для практического применения подобного скрипта требуется настройка ключей доступа к API выбранной языковой модели.

В примере используется переменная окружения GEMINI_API_KEY, обеспечивающая безопасный и удобный способ хранения конфиденциальных данных. Подобные автоматизированные решения полезны не только для разработчиков, желающих оптимизировать свой рабочий процесс, но и для команд, занимающихся техническим долгом и анализом качества кода. Подсчет токенов позволяет выявлять самые «тяжелые» в плане обработки части кода, а исключение игнорируемых Git файлов помогает сосредоточиться на действительно значимых данных. Интеграция с современными языковыми моделями открывает новые горизонты в автоматизации рутинных задач, включая генерацию рефакторинга, автоматическую документацию и кодогенерацию. Четкое понимание структуры проекта и исключаемых файлов усиливает точность таких инструментов и позволяет снизить избыточные расходы при использовании облачных платформ или платных API.

Кроме того, пересчет и контроль токенов особенно важен для проектов с ограничениями на размер обрабатываемого текста, что актуально для многих API и платформ с ограничениями на максимальную длину запроса. Возможность быстро получить актуальную цифру по количеству токенов в репозитории помогает управлять этими ограничениями и планировать дальнейшие шаги. В целом, использование методик Git-aware подсчета токенов — одно из лучших решений для автоматизированного сбора статистики и анализа больших проектов. Это облегчает подготовку данных к дальнейшей работе с языковыми моделями, повышает результативность командной работы и позволяет качественно контролировать техническое состояние репозитория. Реализация подобных инструментов становится особенно актуальной на фоне стремительного роста объемов кода и необходимости интеграции ИИ-технологий в ежедневные процессы разработки.

Применение такой методики улучшает управление ресурсами и снижает вероятность ошибок, связанных с обработкой лишних или ненужных файлов, что делает проект более прозрачным и контролируемым с точки зрения работы с текстовыми данными. В конечном итоге Git-aware token count служит эффективным инструментом для разработчиков и команд, стремящихся повысить качество и эффективность своей работы с программными проектами, а также оптимизировать взаимодействие со сложными языковыми моделями через точный учет используемых токенов.