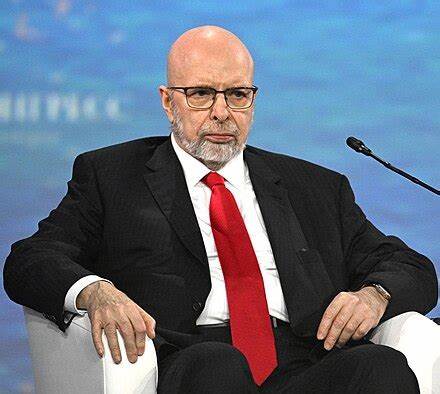

Илья Сутскевер, один из соучредителей OpenAI, запустил новый проект под названием Safe Superintelligence, привлекший внимание инвесторов и собравший внушительный капитал в размере одного миллиарда долларов всего за три месяца с момента своего основания. С выходом из OpenAI, Сутскевер сосредоточился на разработке безопасной суперинтеллектуальной системы, которая обещает значительно превзойти человеческие способности. Но что скрывается за этим новым стартом и какие амбициозные цели стоят перед командой Safe Superintelligence? Илья Сутскевер уже зарекомендовал себя как один из ведущих учёных в области искусственного интеллекта, и его переход к новому проекту вызывает множество вопросов о будущем технологий, которые мы буквально не можем себе представить. По заявлениям команды, главная цель стартапа – создание суперинтеллекта, который не только будет эффективно выполнять задачи, но и делать это безопасно, без риска для человечества. Безопасность искусственного интеллекта становится всё более актуальной темой в мире технологий.

Многие эксперты предупреждают о потенциальных рисках, если такие системы окажутся неконтролируемыми. Именно поэтому команда Safe Superintelligence делает акцент на том, что безопасность будет в центре их разработки. Собранные средства от таких известных венчурных капиталистов, как Andreessen Horowitz и Sequoia Capital, подчеркивают серьёзность намерений команды. В интервью генеральный директор SSI Дэниел Гросс отметил, что для них важно работать с такими инвесторами, которые понимают и поддерживают их миссию. Гросс уверен в том, что необходимо провести несколько лет в научных исследованиях и разработках, прежде чем технологию можно будет запустить на рынок.

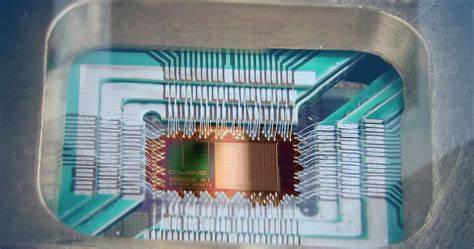

Заключение первого финансового раунда стало знаковым событием, но это лишь начало. Начальная амбициозная цель команды состоит в том, чтобы привлечь лучших разработчиков и обеспечить достаточные вычислительные ресурсы для обучения своих моделей. Как показали последние тенденции в области искусственного интеллекта, мощность вычислений становится ключевым фактором, который определяет успех развития ИИ. В мире, где компании, такие как OpenAI, продолжают разрабатывать так называемый искусственный общий интеллект (AGI), внимание к вопросам безопасности и контролю становится всё более насущным. Открытие новых горизонтов в области ИИ обещает перевернуть наше представление о многих аспектах жизни.

Однако, как указывает Сутскевер, мы должны быть осторожными в нашем подходе к созданию таких мощных технологий. В этом контексте команда Safe Superintelligence ставит перед собой задачу не только разработать новый уровень искусственного интеллекта, но и сделать это с полным пониманием нравственных и этических последствий своего труда. Сутскевер хорошо осведомлён о сложностях, связанных с взаимодействием человека и ИИ, и, по его словам, основной акцент будет сделан на безопасной интеграции новых технологий в наше общество. Помимо серьезных вызовов, стоящих перед командой, стартап также сталкивается с высокой конкуренцией в области искусственного интеллекта. Множество компаний во всем мире стремятся создавать свои оригинальные решения и системы, которые могут преобразить различные отрасли – от здравоохранения до финансов.

Однако Сутскевер и его команда уверены, что их подход к безопасности и этике в разработке ИИ даст им преимущество. Проект Safe Superintelligence не только представляет собой новое начинание для Ильи Сутскевера, но и отображает более широкие тенденции в области технологий. Обсуждение этики и безопасности ИИ становится широко распространённым, и многие стартапы начинают включать эти аспекты в свои проекты с ранних этапов разработки. Такой подход может стать новым стандартом для индустрии в целом, особенно в условиях роста общественного недовольства и страха перед потенциальными угрозами со стороны ИИ. Безусловно, будущее успеха Safe Superintelligence будет зависеть от способности команды не только создать технологию, но и обеспечить её безопасное внедрение.

Мир с суперинтеллектом, который заботится о благополучии человечества, — это цель, к которой стоит стремиться. Учитывая опыт и знания Ильи Сутскевера и его команды, можно надеяться, что они могут осуществить эту амбициозную миссию в ближайшие годы. Тем не менее, не все готовы безоговорочно доверять новым разработкам. Ожидается, что с увеличением числа таких компаний и технологий возникнут новые дискуссии о законодательстве и регулировании области искусственного интеллекта. Вопросы ответственности и возможности контроля за действиями системы ИИ будут оставаться на повестке дня, и многие гуру технологий будут стараться дать ответы на эти вызовы.