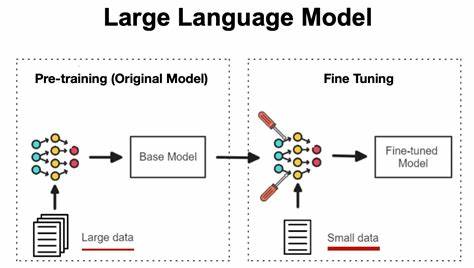

В современном мире искусственного интеллекта и обработки естественного языка тонкая настройка больших языковых моделей (LLM) играет ключевую роль в создании эффективных и специализированных приложений. Этот процесс часто оказывается чрезвычайно сложным и требует большого объема кода, подготовки данных и множества настроек. Именно здесь на помощь приходит Tuna — Python-библиотека, преобразующая подход к донастройке моделей и позволяющая работать с ними быстрее и проще, чем когда-либо прежде. Tuna была разработана с целью устранить излишнюю сложность и рутинную работу, связанную с использованием популярных библиотек типа Transformers, PEFT и Datasets. Ее основная задача — предоставить разработчикам удобный и лаконичный инструментарий для реализации различных методов дообучения моделей с минимальным объемом кода.

Благодаря этому специалисты, будь то исследователи, инженеры машинного обучения или разработчики приложений на NLP, могут сосредоточиться на достижении бизнес-целей, а не на изучении технических нюансов настройки. Одним из важнейших преимуществ Tuna является ее простота использования. Если раньше для запуска простого эксперимента требовалось писать десятки строк кода, подключать и настраивать множество отдельных компонентов, теперь можно добиться тех же результатов несколькими строками. Библиотека сразу берет на себя большую часть подготовки — загрузку модели и токенизатора, конфигурацию обучения, настройку данных. Благодаря такому подходу, рабочий процесс становится гораздо более плавным и эффективным.

Tuna поддерживает несколько популярных и современных методов дообучения. Среди них Low-Rank Adaptation (LoRA) — метод, который позволяет эффективно и экономно по памяти дообучать модель, встраивая низкоранговые адаптационные модули. Кроме LoRA, библиотека реализует поддержку P-tuning, то есть обучения специальных подсказок для моделей, что позволяет значительно улучшать работу при малом количестве тренировочных данных. Также Tuna предлагает Supervised Fine-Tuning (SFT) — традиционный подход с подгонкой всех параметров модели, включая возможность оценки работы во время обучения. Для пользователей, заинтересованных в специализированной адаптации моделей под конкретные домены, предусмотрен метод Domain-Adaptive Fine-Tuning (DAFT).

Гибкость конфигураций — еще одна черта Tuna, которая делает ее привлекательной для различных проектов. Все параметры обучения, настройки LoRA и другие параметры задаются в виде простых словарей Python, что упрощает экспериментирование и обучение. При этом Tuna поддерживает цепочное применение методов — разработчики могут последовательно комбинировать LoRA, SFT и другие техники, что открывает новые возможности для оптимизации результатов. Несомненно, важным аспектом является работа с данными. Tuna интегрируется с популярной библиотекой Datasets, предоставляя удобный способ загружать, просматривать и предварительно обрабатывать датасеты.

Благодаря встроенным инструментам для ограничения объема данных или выбора специфических полей, можно быстро сформировать обучающую выборку для своих задач, экономя время и ресурсы. Для разработчиков, которые ценят удобство и контроль, Tuna предлагает встроенную систему логирования и управления сессиями. Теперь можно автоматически сохранять контрольные точки обучения, возобновлять прерванные сессии и отслеживать прогресс без необходимости прописывать дополнительные скрипты. Такой профессиональный подход к менеджменту обучения помогает минимизировать риски и повысить надежность процессов. Появление Tuna также знаменует собой тенденцию к упрощению ML-конвейеров.

По мере того как модели становятся все больше и сложнее, возникает потребность в инструментах, которые способны упростить повторяющиеся шаги настройки и обучения. Tuna отвечает на этот вызов, предлагая пользователям мощный, но при этом легкий для освоения инструмент, который не требует глубоких знаний многих библиотек. Кроме того, открытость и активное развитие Tuna дают уверенность в ее будущем. Код распространяется под лицензией MIT, а сообщество разработчиков открыто для предложений и доработок. Это означает, что библиотека быстро реагирует на изменения в сфере ИИ, внедряет новые методы и инструменты, что позволяет оставаться на острие технологий.

Практическое применение Tuna многогранно. Она одинаково хорошо подходит для разработки чат-ботов, улучшения систем рекомендаций, дообучения моделей в медицинской и юридической сферах, а также для академических исследований. Универсальность и удобство делают Tuna отличным выбором для проектов с ограниченными ресурсами, так как позволяет быстро получить качественный результат без траты времени на сложные настройки. Для пользователей, готовых приступить к работе, доступна интуитивная установка и базовый стартовый набор функций. Вводные примеры показывают, как буквально в три-четыре строки кода можно загрузить модель, подготовить датасет и начать обучение с использованием LoRA.

Эта простота значительно снижает барьер вхождения в современное машинное обучение. В заключение стоит подчеркнуть, что Tuna — это не просто набор утилит, а полноценная экосистема для дообучения трансформерных моделей. Она облегчает жизнь разработчикам, экономит время и ресурсы, способствует более быстрому внедрению решений на основе ИИ и поддерживает интеграцию современных технологий. В условиях постоянного роста интереса к искусственному интеллекту и развитию языковых моделей, такие инструменты, как Tuna, являются важным шагом в эволюции методов обучения и продвижения цифровых инноваций.