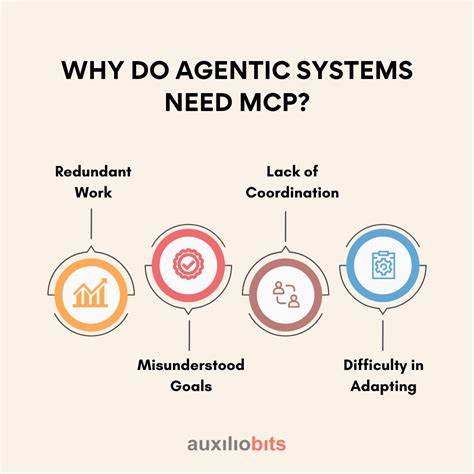

В последние годы термин «агентские системы» стал широко распространённым в сфере технологий искусственного интеллекта и автоматизации. Эти системы, способные самостоятельно принимать решения и выполнять определённые задачи на основе анализа большой информации, обещают революционизировать множество отраслей — от поддержки клиентов до медицинских консультаций. Однако за внешней привлекательностью и потенциалом скрывается ключевой вопрос, без ответа на который внедрение таких технологий в критически важных сферах остаётся рискованным. Речь идёт о так называемых «пропавших 20%» — том самом отрезке возможностей, который отделяет функциональные agentic-системы от действительно безопасных, управляемых и надёжных решений. Почему же возникает необходимость во встроенном контроле и что именно нужно учитывать при создании таких систем? На эти вопросы стоит ответить максимально подробно и непротиворечиво.

Прежде всего, важно уточнить, что понимается под понятием agentic-системы. Существует несколько подходов. Некоторые исследователи рассматривают эти системы как набор детерминированных процессов, управляемых языковыми моделями, которые функционируют в рамках чётко заданных сценариев или алгоритмов. Другие же – и именно к ним чаще всего склоняются эксперты – считают agentic-системы полностью автономными агентами, способными планировать и осуществлять комплексные действия независимо, с минимальным вовлечением человека. Но как бы ни трактовалось само понятие, суть остаётся в том, что такие технологии призваны не просто выполнять инструкции, а адаптироваться, принимать решения и даже прогнозировать развитие ситуации.

Преимущества agentic-систем очевидны. Они способны повысить эффективность работы, минимизировать рутинные процессы, обеспечить круглосуточное обслуживание клиентов, упростить взаимодействие с пользователями за счёт естественного языка и гибкости в поведении. Особенно ярко это проявляется в области чатботов, где agentic-подход позволяет системе вести более живой, диалоговый стиль общения, отражающий реальные потребности человека. Но именно в таких сферах, как здравоохранение, финансы и другие высокорегулируемые отрасли, вызовы и риски становятся особенно значимы. Высокая величина риска и жёсткие правила безопасности предъявляют к агентским системам сверхвысокие требования по точности и предсказуемости.

Здесь недостаточно обеспечить лишь базовую функциональность, нужно гарантировать соблюдение законов, стандартов, а также исключить возможность нанесения вреда человеку или бизнесу из-за ошибки или неправильного действия ИИ. Например, в медицине любая неверная рекомендация может привести к серьёзным последствиям — неправильная диагностика, назначение неподходящего лекарства или игнорирование симптомов. Аналогично в финансовой сфере – невыполнение предусмотренных процедур может повлечь за собой убытки или даже юридические санкции. Многие при разработке agentic-систем полагаются на то, что искусственный интеллект будет строго следовать встроенным инструкциям и этическим нормам. Например, можно серьёзно порекомендовать системе «никогда не назначать лекарство без консультации с врачом».

Однако практика показывает, что такие предписания не обладают безоговорочной силой. Современные языковые модели, несмотря на впечатляющие возможности, не являются совершенными. Они могут быть подвержены ошибкам интерпретации, противоречиям исходных данных, а также разнообразным атакам, известным как jailbreaking — механизмам, позволяющим обойти встроенные ограничения. Исследования демонстрируют, что даже самые прогрессивные модели, такие как GPT-4, не способны блокировать более половины таких атак, а их точность при ответах на вопросы с противоречащим контекстом часто падает ниже 50%. Это напрямую ставит под сомнение возможность исключительно инструкционного контроля над agentic-системами в сложных производственных условиях.

Понимание этой уязвимости приводит к необходимости комплексного подхода к безопасности и управляемости agentic-систем. Важно не просто накладывать ограничения через текстовые инструкции, но интегрировать контроль в саму архитектуру решений. Речь идёт о создании синтетических систем, которые объединяют в себе языковые модели с мощными механизмами контроля и валидации. Среди таких механизмов можно выделить участие человека на ключевых стадиях принятия решения (human-in-the-loop), когда определённые действия требуют обязательного подтверждения оператора. Это снижает риски ошибочных действий и позволяет сохранить высокий уровень ответственности.

Кроме того, контролируемые агентские системы внедряют жёсткие алгоритмические ограничения, которые действуют независимо от команд языковой модели. Например, в медицинском боте можно запрограммировать жёсткое правило, запрещающее автоматически выдавать рецепты без предварительной верификации. Также эффективной мерой является маршрутизация запросов — автоматический перевод сложных или спорных случаев на рассмотрение специально обученных специалистов. Такой многоуровневый подход позволяет сохранить гибкость и автономность agentic-систем, не жертвуя надёжностью и предсказуемостью. Баланс между контролем и свободой действий агента — одна из центральных задач в проектировании будущих решений.

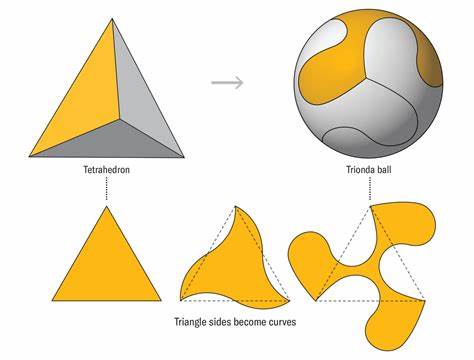

Если попытаться прописать абсолютно все ситуации и варианты поведения, система станет тяжеловесной и потеряет в адаптивности — снижая те преимущества агентского подхода, которые и делают его привлекательным. В то же время, излишняя свобода ведёт к непредсказуемости, ошибкам и потенциальным рискам. Поэтому идеальным представляется модель, сочетающая структурированные процессные рамки с возможностью гибкой планировки задач на основе текущего контекста и полученных данных. Активное развитие соответствующих программных фреймворков свидетельствует о признании актуальности данной проблемы в индустрии. Такие инструменты, как google-adk, ориентированы не на простое расширение базовых возможностей языковых моделей, а на создание более надёжных control-агентов, включающих механизмы мониторинга, ограничения и вмешательства.

Их применение позволит сделать agentic-системы гораздо более востребованными и применимыми в условиях строжайших требований по безопасности, а также ускорит адаптацию технологий искусственного интеллекта в отраслях, где ошибки недопустимы. Перспективы agentic-систем в ближайшие годы выглядят многообещающе. Однако, чтобы выполнить свой потенциал и превзойти ожидания, необходимо сосредоточиться именно на тех «пропавших 20%», которые связаны с уверенностью в безопасности и контролируемости. Только за счёт грамотного проектирования архитектуры, внедрения жёстких, но адаптивных механизмов контроля, а также интеграции человеко-машинного взаимодействия, такие системы смогут завоевать доверие профессионалов и конечных пользователей в самых требовательных сферах. Итоговый вывод таков, что agentic-системы не могут оставаться «чёрным ящиком», где решения принимаются без возможности мониторинга и коррекции.

Встроенный контроль — это не необязательная опция, а фундаментальный элемент, необходимый для безопасного, этичного и эффективного применения современных технологий. Только так инновации в искусственном интеллекте смогут действительно преобразить бизнес-процессы, улучшить качество медицинской помощи, обезопасить финансовые операции и стать полноценной частью нашего повседневного цифрового мира.