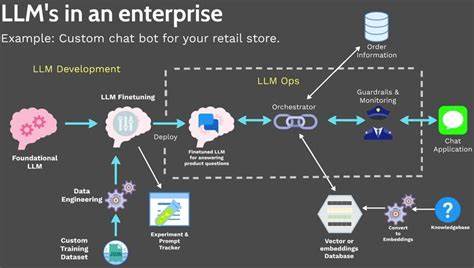

В последние годы тема больших языковых моделей (LLM) стала исключительно популярной. Многие компании и энтузиасты стремятся внедрять их в свои проекты, чтобы повысить качество обслуживания, автоматизировать процессы или просто исследовать потенциал искусственного интеллекта. Однако желание самостоятельно запустить и хостить собственную большую языковую модель далеко не всегда оправдано. В этой статье рассматриваются ключевые причины, почему самостоятельное размещение LLM часто приводит к проблемам и как более разумно подойти к использованию таких технологий. Для начала стоит понять, что большие языковые модели - это сложные системы, требующие значительных вычислительных ресурсов.

От мощных графических процессоров до специализированного оборудования, поддерживающего эффективное обучение и инференс, расходы на инфраструктуру могут быть очень высокими. Многие люди недооценивают финансовые и технические требования, что приводит к разочарованию и потерям времени. Кроме того, настройка и поддержка собственной языковой модели требуют глубоких технических знаний в области машинного обучения, программирования и инженерии данных. Неопытные пользователи сталкиваются с проблемами интеграции модели с существующими системами и оптимизации работы, что негативно сказывается на производительности и стабильности. Безопасность и конфиденциальность данных - ещё один важный аспект, который часто игнорируется при самостоятельном запуске LLM.

Обработка огромного объёма информации в собственной инфраструктуре без должных мер защиты повышает риски утечки данных и нарушений законодательства, таких как GDPR. Многие крупные облачные провайдеры предлагают проверенную защиту и соответствие нормативным требованиям, что сложно обеспечить самостоятельно. Обновления и поддержка моделей также оказываются затратными. Языковые модели постоянно совершенствуются: разработчики выпускают обновления, позволяющие улучшить точность и безопасность. Если хостить модель самостоятельно, необходимо самостоятельно следить за обновлениями, проводить перенастройку и обучение, что требует времени и дополнительных ресурсов.

Проблемы масштабируемости - ещё один фактор. В периоды повышенного спроса, когда требуется обработать множество запросов, собственные мощности могут оказаться недостаточными. Масштабирование инфраструктуры дорогостояще и технически сложно, в отличие от использования облачных сервисов, где ресурсы можно гибко увеличивать по мере необходимости. Рассмотрим также вопрос лицензирования. Многие крупные языковые модели распространяются с ограничениями, регулирующими их коммерческое использование и модификацию.

Несоблюдение этих условий может привести к юридическим проблемам и штрафам, чего можно избежать, пользуясь официальными провайдерами. Вместо самостоятельного хостинга стоит обратить внимание на облачные решения и API, предлагаемые такими компаниями, как OpenAI, Google и Microsoft. Эти сервисы дают доступ к мощным языковым моделям без необходимости инвестировать в дорогостоящую инфраструктуру. Они берут на себя все технические аспекты, обеспечивают безопасность и обновления, а пользователи получают современный функционал с возможностью масштабирования. Также существуют средние варианты, когда можно использовать облегчённые или специализированные модели, которые легче интегрировать и размещать на ограниченных ресурсах.

Такой подход часто подходит для проектов с ограниченным бюджетом или специфическими требованиями. Еще одна причина, по которой не стоит самостоятельно запускать LLM - это постоянно меняющаяся сфера искусственного интеллекта. Технологии быстро развиваются, и сегодня актуальная модель завтра может устареть. Использование сервисов с регулярными обновлениями позволяет всегда иметь доступ к последним достижениям и не тратить ресурсы на пересоздание собственной модели. При этом важно учитывать и этические аспекты.

Контроль над содержанием, предотвращение токсичного или предвзятого контента требует непрерывного мониторинга и коррекции модели. Облачные провайдеры обычно имеют большие команды специалистов и инструменты для решения таких задач, что сложно реализовать самостоятельно. Для бизнеса самостоятельное внедрение и поддержка собственной LLM часто является неоправданным риском. Неверная оценка затрат и сложности приводит к срыву проектов и ухудшению пользовательского опыта. Грамотный выбор провайдера и интеграция через API позволяют быстрее достичь результата с минимальными затратами и усилиями.

С учетом всего вышесказанного, несмотря на привлекательность идеи иметь полностью собственную языковую модель, большинству пользователей и компаний стоит отказаться от самостоятельного хостинга. Значительно эффективнее и практичнее воспользоваться надежными внешними сервисами, которые предоставляют высококачественные модели и возьмут на себя технические сложности, безопасность и поддержку. Подводя итоги, самостоятельный запуск большой языковой модели требует огромных ресурсов, глубоких технических знаний и готовности к постоянной поддержке. Для эффективного и безопасного использования ИИ лучше ориентироваться на проверенные облачные решения, которые сочетают в себе мощь технологий и удобство эксплуатации. Такой подход помогает сосредоточиться на развитии бизнеса и достижении целей, а не на решении многочисленных технических проблем.

.

![Cave Drops 500ft Through a Mountain Into a Corn Field [video][19 mins]](/images/44ED7242-6373-4FBB-B1CA-AAB9A4511BF2)

![How to bug hotel rooms v2.0 [video]](/images/59183603-A475-44F8-A96E-28DECDF4DBB1)