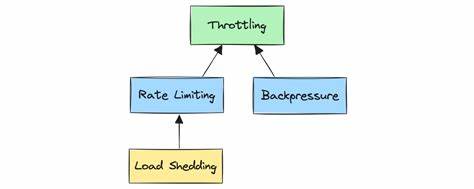

В современном мире разработки программного обеспечения интеграция с внешними API стала неотъемлемой частью большинства проектов. Особенно это актуально для приложений, работающих с платежными шлюзами, службами доставки, аналитическими сервисами и другими поставщиками данных. Однако при взаимодействии с такими сервисами разработчики часто сталкиваются с ограничениями на число запросов, которые можно отправлять в определённый промежуток времени. Нарушение этих лимитов может привести к возврату ошибки с кодом 429 - Too Many Requests, а иногда даже к временной блокировке аккаунта. Чтобы избежать подобных проблем, необходима надёжная стратегия троттлинга, которая учитывает разные лимиты для разных эндпоинтов и поддерживает распределенное управление на уровне всего приложения.

Одним из наиболее эффективных подходов к решению этой задачи является использование фреймворка Ruby on Rails в сочетании с хранилищем Redis для реализации многоуровневого ограничения скорости запросов (мульти-рейтового лимита). Для начала стоит понять, почему обычное ограничение скорости, которое применяет одинаковые параметры ко всем запросам, недостаточно. В реальной ситуации разные ресурсы API могут иметь разные лимиты, например, запросы на создание транзакций могут быть доступны до 100 вызовов в минуту, тогда как запросы на отчёты – всего 5 раз в час. Игнорирование этого факта существенно увеличивает риск превышения лимитов, что негативно скажется на пользовательском опыте и стабильности работы приложения. В роли основного инструмента для реализации ограничения скорости выступает Redis – скоростное in-memory хранилище, позволяющее хранить данные по подключению и быстро выполнять атомарные операции счётчиков.

С его помощью можно создавать ключи, которые группируют запросы в фиксированные временные окна, например, по минуте или часу, и отслеживать количество запросов внутри этого окна. Стандартным механизмом служит инкрементирование счетчика при каждом запросе. Если значение превышает установленный лимит, система блокирует дальнейшие вызовы на оставшийся интервал до сброса счётчика. Для удобства администрирования параметров лимитов желательно централизовать конфигурацию, сохраняя настройки для каждого API и эндпоинта в одном месте. Такой подход не только упрощает управление, но и облегчает модификацию правил при изменении требований внешних сервисов.

В рамках Rails можно создать специальный класс конфигурации, который будет хранить объем и период лимитов для каждого пути. Следующий важный элемент – клиент для HTTP-запросов, который встраивает логику ограничения в процесс обращения к API. Перед отправкой запроса необходимо проверить, не превышен ли лимит для данного эндпоинта. При необходимости стоит выбрасывать исключение, информирующее о превышении, чтобы вызывающий код мог корректно обработать ситуацию. Если же внешнее API все-таки вернуло ошибку 429, необходимо обновить внутреннее состояние, чтобы избежать повторных вызовов, и повторно применить логику ограничения.

Для повышения устойчивости и улучшения пользовательского опыта в такой системе полезно внедрить механизм повторных попыток с экспоненциальной задержкой. Это позволит автоматически повторять запросы, если они были отклонены из-за превышения лимита, с увеличением времени ожидания между попытками, что способствует плавному восстановлению после пиков нагрузки. Важно учитывать, что время повторов не должно превышать момент сброса лимита, иначе система будет простаивать без необходимости. В случае интеграции ограничений в фоновую обработку заданий, например, через Active Job, рекомендуется реализовать отложенные повторные постановки задач в очередь с задержками. Такая стратегия гарантирует, что задачи, столкнувшиеся с лимитированием, не блокируют обработку других заданий и повторно запускаются только после возможности успешного выполнения.

Помимо технической реализации, не стоит забывать о мониторинге использования лимитов. Сбор статистики по количеству оставшихся запросов, времени сброса счетчика и степени загрузки позволит своевременно получать предупреждения о приближении к пределам, а также оптимизировать конфигурации и нагрузку на API. В качестве лучших практик реализации подобной системы стоит рассматривать следующее. Использовать фиксированные временные окна для упрощения логики подсчёта и предсказуемости поведения. Делать ключи Redis, привязанные к endpoint и времени, чтобы избежать пересечений и гарантировать корректное отслеживание.