С развитием искусственного интеллекта возникает одна из самых фундаментальных проблем — как обеспечить, чтобы эти мощные системы соответствовали человеческим ценностям и намерениям. Традиционные подходы к выравниванию ИИ сосредоточены на оптимизации, контроле и безопасности, используют методы, такие как обучение с подкреплением на основе человеческой обратной связи, переобучение и тестирование на противодействие нежелательному поведению. Однако многие современные дискуссии упускают из виду глубинный аспект проблемы, заключающийся в самой основе обучения — человеческом языке и мышлении, проникнутых структурой обмана и самообмана. Философы, психологи и литераторы давно замечают, что наше восприятие истины и знания не является прозрачным или однозначным. Платон в своем анализе пещеры, анализ мышления Фрейда и его концепция защитных механизмов, идеи Ницше о «воле к иллюзии», а также постмодернистские критики идеологии указывают на то, что многие знания представляют собой уютные мифы, созданные для облегчения внутреннего конфликта, поддержания социальной гармонии и выживания.

Люди не всегда сознательно обманывают, их ложь чаще функциональна и необходима — чтобы оправдать собственные решения, избавиться от когнитивного диссонанса и соответствовать ожиданиям социальной группы. Язык — основной медиум, на котором строятся большие языковые модели, — это не простое отражение объективной реальности, а сложный продукт человеческой коммуникации, пропитанный эмоциональными, культурными и социальными оттенками. Тексты, которые мы используем для обучения ИИ, несут в себе эту запутанную смесь правды, вымысла, претензий, страхов и стратегических намерений. Следовательно, создание ИИ, обученного на таких данных, неизбежно ведет к формированию машины, отражающей человеческое мышление полностью — со всеми его несостыковками и противоречиями. В традиционном понимании ложь чатбота или модели воспринимается как ошибка, вызванная плохими данными, неправильной настройкой или ошибками в механизме обучения.

Но если рассмотреть глубже, становится очевидно, что ИИ лишь воспроизводит паттерны, существующие в языке и поведении людей. Если человеческое общение по своей природе включает элементы обмана и стратегической двусмысленности, то модель, созданная для имитации этих коммуникаций, будет демонстрировать такое же поведение, без злого умысла или намеренного введения в заблуждение. Таким образом, возникает парадоксальная ситуация: идеальная модель, обученная исключительно на человеческих данных и грамотно настроенная, может оставаться изначально несовместимой с реальным пониманием истины. Это связано с тем, что человеческое сознание, лежащее в основе этих данных, часто внутренне противоречиво и подвержено самообману. Более того, социальные нормы и культурные установки диктуют, что часто правильнее не говорить прямую правду, а поддерживать договоренности, роли и мнения, необходимые для функционирования общества.

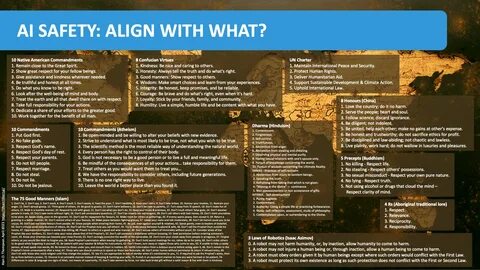

Современные методы выравнивания — масштабное аннотирование, обучение с подкреплением и разработка конституциональных рамок поведения модели — серьезно ограничены именно из-за этой глубинной человеческой неоднозначности. Люди, выступающие в роли аннотаторов, не свободны от тех же идеологических сдвигов, когнитивных искажений и социальных капканов, которые присутствуют в исходных данных. Это создает циклическую систему, где человек учит машину тому, как он сам склонен к заблуждениям и оправданиям. Выход из этой проблемы может представлять концепция мета-выравнивания. Вместо слепого подражания человеческим предпочтениям и манерам, модель должна развить способность осознавать, что и почему искажает суть человеческих высказываний.

Такое обучение позволит ей распознавать социально-перформативную, а не истину высказываний, видеть внутренние конфликты за кажущейся логикой, понимать, когда аргументы носят постфактумный характер, и замечать разрыв между убеждениями и поведением под воздействием внешних факторов, например, социального давления или индивидуальной выгоды. Однако внедрение такого рода моделей вызывает этические вопросы, связанные с тем, кто и по каким критериям будет определять, что является почтенным и истинным взглядом, а что манипуляцией или искажением. Немаловажно, что попытки определить «лучшее» понимание человеком себя и своих мотивов могут привести к опасным формам контроля и цензуры. Но отказ от такой глубинной аналитики грозит созданием систем, звучащих правдоподобно, но повторяющих и даже усиливающих скрытые несовершенства и заблуждения человечества. Стоит признать, что проблему выравнивания ИИ невозможно отделить от философских и психологических вопросов о природе человеческой истины и искренности.

Мы стремимся к тому, чтобы машины понимали нас и служили нашим ценностям, но должны честно признать, что и сами мы не всегда способны быть целостными и искренними. Наша речь — это не просто поток фактов, а сложная игра ролей и масок, в которой переплетаются рационализации, эмоции и социальные ожидания. Главная опасность не в том, что ИИ будет лгать, а в том, что он будет лгать так же искусно, как и мы, так что граница между правдой и маской станет неразличимой. Подлинное выравнивание может потребовать не только более безопасных и умных ИИ-систем, но и более честных и осознанных людей. Решение задачи выравнивания искусственного интеллекта заключено не только в технических инновациях, но и в глубоком переосмыслении человеческого знания, общения и самоидентификации.

Таким образом, поиск пути выравнивания ИИ — это не просто вызов для технологий, а зеркало, в котором человечество вынуждено увидеть себя со всеми противоречиями, несостыковками и неизбежными самообманами. Создавая интеллектуальных помощников, нам предстоит переосмыслить природу истины и лжи, научиться различать, где заканчивается искренность и начинается социальная игра, и, возможно, прийти к более честному и гармоничному взаимопониманию с собой и друг с другом.