В последние годы технологии искусственного интеллекта (AI) стремительно развиваются, приводя к созданию сложных дипфейков — видеоматериалов, где лица и голоса людей могут быть подменены с невероятной точностью. Это явление привлекло внимание правоохранительных органов, и недавно ФБР выпустило предупреждение о новой волне мошенничества, связанной с использованием этих технологий для шантажа и вымогательства. Дипфейки — это не просто забавные видео, которые можно увидеть в социальных сетях. Они представляют собой мощный инструмент, который злоумышленники могут использовать для манипуляции мнением и получения выгоды. Используя дипфейки, преступники могут имитировать известных людей или даже обычных граждан, создавая фальшивые видео, которые могут выглядеть крайне реалистично.

От фальшивых обращений от политиков до подделки личных видео обычных людей — возможности безграничны. ФБР сообщило, что злоумышленники начали применять дипфейки в схемах вымогательства, угрожая опубликовать скомпрометирующие видео жертвы, если не будет выплачена определённая сумма денег. Такие уловки часто используют эмоциональный шантаж, ставя жертву в ситуацию стресса и бояться общественного осуждения. В результате жертвы могут отдать деньги, не разобравшись в ситуации и не осознав, что стали жертвами фальсификации. Однако не все потеряно.

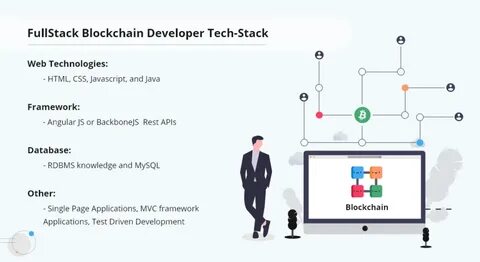

Существуют способы, которые могут помочь вам защитить себя от подобных атак. Прежде всего, важно не поддаваться панике. Если вы получили сообщение с угрозами — тщательно проанализируйте полученную информацию. Попробуйте проверить, есть ли у вас действительно такие видео, и если нет, не позволяйте мошенникам получить над вами власть с помощью запугивания. Еще одним важным шагом является использование технологий для защиты своих цифровых данных.

Это может включать в себя использование надежных паролей, двуфакторной аутентификации и регулярное обновление программного обеспечения. Если ваше личное видео или информация была украдена, сообщите об этом в правоохранительные органы и рассмотрите возможность обращения за юридической помощью. Стоит также отметить, что речевые и музыкальные дипфейки становятся все более разнообразными. Они позволяют создать голосовой клон человека, который может произнести любое сообщение, что также вызывает опасения по поводу мошенничества. Это открывает еще больше возможностей для злоумышленников создавать фальшивые звонки, например, от имени взрослых членов семьи, просящих о финансовой помощи.

В ответ на растущие опасности, связанные с дипфейками, различные организации и правительственные структуры разрабатывают новые законы и правила. Например, некоторые страны начали требовать от платформ социальных медиа более жесткого контроля за контентом, чтобы предотвратить распространение дипфейков и защитить пользователей от мошенничества. Чтобы избежать попадания в ловушку мошенников с использованием дипфейков, рекомендуется следовать нескольким простым правилам. Во-первых, всегда сомневайтесь в получаемых видео и сообщениях. Если что-то кажется подозрительным или необычным, лучше перепроверить эти данные через независимые источники или спросить у своих близких о подлинности информации.

Во-вторых, старайтесь избегать размещения чрезмерного количества личной информации в интернете. Конфиденциальность данных становится все более важной, поэтому подумайте дважды, прежде чем делиться любыми видео или изображениями, которые могут быть использованы злоумышленниками против вас. ФБР подчеркивает важность осведомленности и бдительности. По мере того, как технологии продолжают развиваться, увеличивается и количество способов, которыми злоумышленники могут использовать эти технологии для манипуляции и обмана. Будьте осторожны и не дайте мошенникам возможности использовать ваши страхи и уязвимости в своих интересах.