В последние годы развитие больших языковых моделей (Large Language Models, LLM) привлекло огромное внимание специалистов в области искусственного интеллекта и смежных технологий. Успехи таких систем впечатляют: они способны отвечать на вопросы, создавать связные тексты и даже вести диалог с пользователем на сложные темы. В то же время идея объединения нескольких LLM в единую многоагентную систему (Multi-Agent LLM System, MAS) вызывала большие надежды по поводу улучшения производительности, интеллектуального сотрудничества и решения более сложных задач. Однако несмотря на энтузиазм, на практике такие многоагентные системы зачастую демонстрируют лишь минимальные улучшения или даже снижают эффективность по сравнению с отдельными агентами. Почему так происходит и в чем корень этих неудач? Разберём основные факторы, препятствующие успешному взаимодействию нескольких LLM и помогающие понять направление будущих исследований и улучшений в этой области.

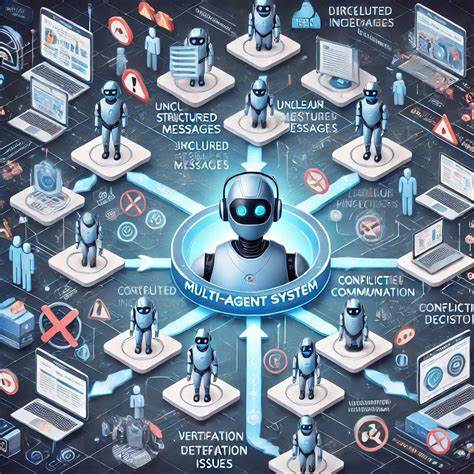

Первоначально стоит упомянуть о структуре и назначении многоагентных систем. Представьте группу экспертов, каждый из которых отвечает за определённый аспект вопроса, взаимодействует с коллегами, обменяется информацией и совместно достигает более качественного решения, чем один отдельный специалист. Аналогично MAS пытаются синтезировать знания и выводы нескольких отдельных языковых моделей для решения комплексных задач. Однако именно координация и взаимодействие между агентами становятся одной из ключевых проблем. Важным инструментом для анализа сбоев в современных MAS выступает недавно созданная емпирически обоснованная таксономия сбоев под названием MAST (Multi-Agent System Failure Taxonomy).

Она основана на исследовании семи популярных многоагентных систем, сотен задач и мнениях шести экспертов, что позволяет глубоко понимать основные проблемы. MAST выделяет целых четырнадцать уникальных видов сбоев, сгруппированных в три крупные категории: ошибки формулировки задач (specification issues), нарушения синхронизации и согласованности между агентами (inter-agent misalignment) и проблемы верификации и проверки результатов (task verification). Каждая из этих групп отражает ключевые сложности, с которыми сталкивается внедрение MAS в реальных сценариях. Ошибки спецификации связаны с тем, что задачи и инструкции для агентов могут быть плохо сформулированы, неполны или слишком неоднозначны. При работе с одним агентом мы часто можем вручную настроить цель и подстроить ответы, но в многоагентной системе необходимость точного задания ролей и правил становится ещё более критичной.

Когда задачи заданы нечетко, агенты могут интерпретировать их по-разному, что приводит к неэффективному выполнению и конфликтам. Это особенно важно в сценариях, где взаимозависимость действий каждого агента высока и ошибки одного могут привести к значительным сбоям всей системы. Следующий уровень проблем — межагентное несогласие и разнобой. Когда у нескольких агентов разное понимание целей, репрезентации информации или стратегий, возникает хаос коммуникации и взаимных ожиданий. Даже при наличии мощных языковых моделей эти несоответствия могут привести к тому, что агенты не смогут скоординировать свои действия, конфликтуют в процессе решения задачи или повторяют одни и те же ошибки.

Важно отметить, что туннельное мышление и отсутствие общей картины у LLM — одна из фундаментальных сложностей, которая усугубляется при увеличении числа участников. Эффективное взаимодействие требует сложных протоколов обмена информацией, динамического уточнения ролей и механизмов разрешения конфликтов, которые зачастую отсутствуют либо реализованы недостаточно хорошо в современных MAS. Наконец, критическим аспектом становится проверка результатов работы и валидация решений. После того, как агенты совместно генерируют выводы или ответы, необходимо убедиться в их корректности, связности и применимости к исходной задаче. Но здесь существующие многоагентные системы часто терпят неудачу из-за отсутствия надежных механизмов контроля качества и самоанализа.

Использование LLM для проверки решений друг друга или внешнее экспертное вмешательство еще не стали стандартом и требуют дальнейшей проработки. Недостаточная валидация приводит к тому, что ошибки или неточности остаются незамеченными, что снижает доверие к системам и ограничивает их практическое использование. Еще одним связным фактором проблему является сложность и стоимость вычислений в многоагентных системах. Объединение нескольких больших моделей увеличивает нагрузку на инфраструктуру, время отклика и ресурсы, что не всегда оправдано результатом. В ряде случаев одноблочные модели могут лучше выполнять задачу при меньших затратах.

Следовательно, экономическая эффективность и масштабируемость остаются незаменимыми критериями, над которыми необходимо работать. Систематический подход к изучению таких сбоев, как MAST, важен еще и тем, что позволяет разрабатывать специализированные инструменты автоматической оценки и аннотирования неудач. Это помогает быстрее выявлять системные проблемы и разрабатывать стратегические улучшения. В частности, инновационный метод «LLM-as-a-Judge» показал себя как способ масштабирования оценки качества работы MAS без необходимости постоянного участия экспертов, что способствует ускорению развития данной области. Практическая ценность успешных многоагентных систем огромна: они способны обеспечивать более надежное распределенное принятие решений, повышать глубину анализа и предлагать сложные решения в различных областях — от медицины и юриспруденции до технического проектирования и творческих индустрий.