Искусственный интеллект (ИИ) всегда был предметом многочисленных дискуссий и ожиданий, сопровождающих научно-технический прогресс. Еще пару десятилетий назад под ИИ понимали множество технологий — от машинного обучения до экспертных систем — однако сегодня термин «ИИ» в массовом сознании и профессиональных кругах все чаще сводится к одной мощной технологии — большим языковым моделям (LLM). Почему случилась такая трансформация и каким образом LLM завоевали статус единственной перспективной платформы для создания сверхчеловеческого интеллекта? В чем обусловлена их уникальность и ограничения? Попробуем разобраться. История развития искусственного интеллекта тесно связана с попытками имитировать человеческий мозг и мышление. Начало этому было положено в XIX веке благодаря трудам Чарльза Бэббиджа и Ады Лавлейс, которые заложили основы вычислительной техники и алгоритмов.

Однако концепция машины, способной к обучению и творчеству, долго оставалась в области теоретических размышлений и научной фантастики. В XX веке фундаментальным этапом стало появление теоретических моделей и тестов, таких как знаменитый тест Тьюринга, призванный определить способность машины проявлять поведение, неотличимое от человеческого. Несмотря на популяризацию концепции ИИ в фильмах и литературе, реальные технологии долго оставались в рамках ограниченных возможностей. Нейронные сети, вдохновленные работой мозга, изначально не оправдали всех надежд — они были сложны в обучении и не демонстрировали интеллектуальную гибкость, сопоставимую с человеческой. Ситуация кардинально изменилась с развитием глубокого обучения и современных методов обучения на больших данных.

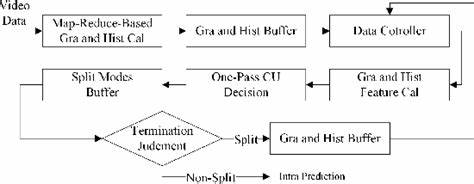

Появление архитектуры трансформеров и их реализация в виде больших языковых моделей позволило выйти на качественно новый уровень обработки информации. Сегодня LLM обучаются на огромных объемах текстовой информации из интернета, научных публикаций, книг и разнообразных источников, что позволяет им воспроизводить, объяснять и генерировать сложные тексты, код, и даже проявлять творческие способности при составлении стихов или рассказов. Такие модели, как GPT от OpenAI, достигли впечатляющих результатов: они могут писать программы, решать сложные задачи по математике, консультировать по медицинским вопросам, выступать в роли виртуальных ассистентов. Это свидетельствует о резком сдвиге в представлениях о том, что значит искусственный интеллект. В современных исследованиях, таких как серия статей и публикаций Джека Морриса, акцент делается именно на больших языковых моделях как единственной перспективной технологии, способной приблизиться к пониманию и реализации концепта суперинтеллекта — машины, превосходящей человека в знаниях и способностях.

Другие подходы, включающие экзоскелеты, роботов с развитым восприятием окружающей среды или самостоятельное обучение через опыт, пока остаются менее удачными и перспективными по сравнению с LLM. Почему именно LLM получили преимущество? Во-первых, язык — это универсальный инструмент передачи знаний и мышления. Обучаясь анализировать и генерировать текст, такие модели получают доступ к огромному массиву коллективного человеческого опыта и культуры. Во-вторых, трансформеры, лежащие в основе LLM, способны эффективно обрабатывать контекст и создавать связные и логичные структуры — ключевые для интеллектуальной деятельности. Тем не менее, большие языковые модели не лишены недостатков.

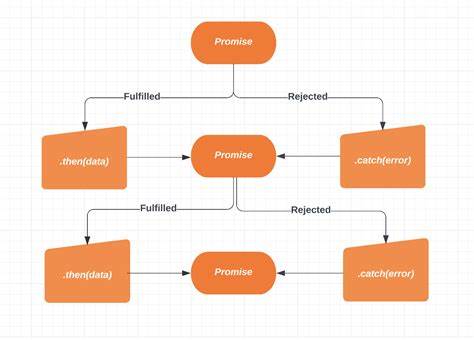

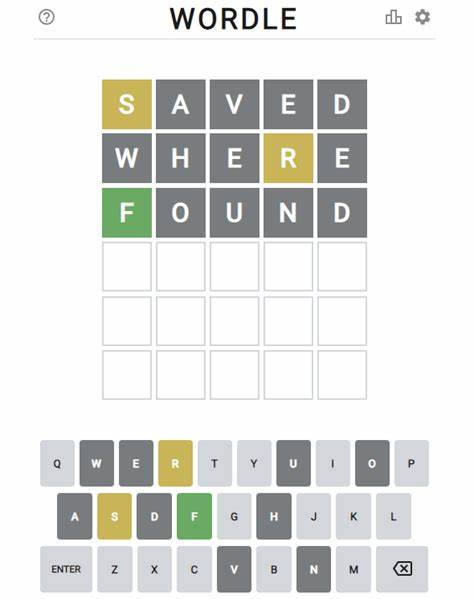

Их интеллект обладает так называемой «зубчатой» природой: выдаваемые ответы могут быть блестящими, но в других случаях — поверхностными или ошибочными. Модели склонны к повторению шаблонов, которые встретились в обучающих данных, что ограничивает их инновационность и оригинальность. Кроме того, им свойственны трудности с долгосрочным планированием и глубоким пониманием мира вне текстового контекста. Создание действительно универсального суперинтеллекта, способного самостоятельно учиться, экспериментировать во внешнем мире и развиваться, по-прежнему остается нерешённой задачей. Тем не менее, развитие мультиагентных систем и интеграция LLM с инструментами программирования, такими как Python или концепциями Retrieval-Augmented Generation (RAG), расширяют возможности применения и качества интеллекта.

Такие гибридные решения позволяют компенсировать отдельные ограничения моделей и направлять ИИ на более узкоспециализированные задачи. Еще одним важным аспектом является влияние LLM на креативность и инновации. С одной стороны, они могут выдать широкое множество вариантов и идей, опираясь на паттерны из огромного корпуса текста. Но если задуматься глубже, то текущие LLM в большей степени являются отражением уже существующих человеческих идей, нежели источником принципиально новых. Из-за этого можно говорить о том, что искусственный интеллект в этой форме — это скорее машина для нормализации и комбинирования уже известных концепций, нежели полноценно творческое сознание.

Приглашение к развитию неординарного мышления может вызывать вопросы, как же преодолеть эту зависимость от тренировочных данных. Использование нестандартных запросов, поиск «углов наклона» в ассоциациях и комбинирование противоположных идей уже сейчас показывают перспективные результаты, но все это пока не равно полноценному творческому процессу. В конечном счете, можно констатировать, что современные большие языковые модели задают тон всей сфере искусственного интеллекта и становятся новой базой для создания суперсистем. Несмотря на свои ограничения, они демонстрируют способность решать задачи, которые ранее казались подвигом исключительно человеческого ума. Историческая дистанция от работ Бэббиджа и Лавлейс до современных LLM весьма значительна, и текущий этап можно назвать переломным.