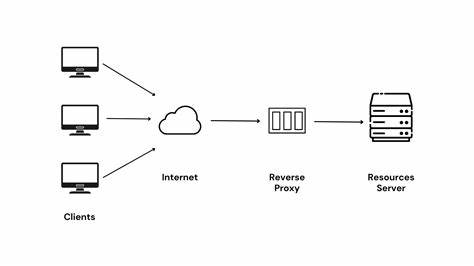

Обратный прокси-сервер — это важнейший компонент современной распределённой архитектуры, который выступает посредником между клиентами и серверами, скрывая внутреннюю структуру и помогая эффективно распределять нагрузку. Его роль выходит далеко за рамки простой маршрутизации запросов, охватывая такие задачи, как управление соединениями, балансировка нагрузки, обработка заголовков HTTP, обеспечение безопасности посредством TLS и поддержка масштабируемости на уровне операционной системы и оборудования. В своей основе обратный прокси получает входящие запросы от клиентов, анализирует их, возможно, немного трансформирует и перенаправляет на один или несколько внутренних серверов, которые и выполняют основную работу по генерации ответа. После получения ответа прокси пересылает его обратно клиенту. Такая схема позволяет абстрагировать пользователям детали внутренней инфраструктуры и одновременно оптимизировать работу приложений.

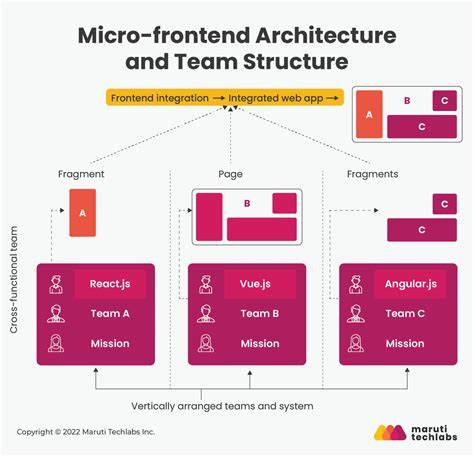

Существует множество реализаций обратных прокси, каждая из которых ориентирована на определённые сценарии. Например, такие решения как HAProxy и Nginx широко применяются для балансировки нагрузки и работы на границе сети, Envoy и Linkerd становятся основой сервис-мешей, обеспечивая сложные взаимодействия микросервисов, а Apache Traffic Server популярен в задачах кэширования и ускорения доставки контента. Концепция работы обратного прокси включает несколько ключевых этапов. Для начала прокси должен принимать входящие сетевые соединения. Для этого сервис на стороне прокси слушает определённый порт и принимает подключения от клиентов.

Затем запросы обрабатываются: сервер анализирует HTTP-сообщения, проверяет и, при необходимости, корректирует заголовки, выполняет переписывание путей. После этого прокси определяет, на какой из внутренних серверов следует отправить запрос, основываясь на механизмах сервисного обнаружения и балансировки нагрузки. Далее прокси формирует собственный HTTP-запрос уже к внутреннему серверу, получает ответ и пересылает его назад клиенту. Весь этот сложный цикл работы должен выполняться с поддержкой высокой пропускной способности и без существенных задержек. Одним из самых сложных элементов в реализации обратных прокси является управление соединениями.

Естественно, простой сервер сможет обслужить только ограниченное количество клиентов одновременно, поскольку стандартные блокирующие операции ввода-вывода накладывают ограничения на число одновременных подключений. Создавать поток на каждого клиента оказывается неэффективным, так как ресурсы процессора и памяти быстро заканчиваются. Чтобы решить эту проблему, в современных прокси применяются неблокирующие методы ввода-вывода. В Linux, к примеру, можно перевести сокеты в неблокирующий режим, после чего операции чтения или записи, если они не готовы, сразу же завершаются с кодом ошибки, который сигнализирует о необходимости повторной попытки позже. Это позволяет организовать поток, который в одном цикле может обрабатывать множество активных соединений, не простаивая в ожидании готовности данных.

Более того, для контроля над большим количеством файловых дескрипторов используются различные системные вызовы. Сначала появились select и poll, которые позволяют следить за состоянием множества дескрипторов одновременно, но они начинают ощутимо замедляться при росте количества соединений. Ответом на это стал интерфейс epoll, обеспечивающий эффективное обнаружение готовых дескрипторов без необходимости обхода каждого из них. Именно epoll в значительной степени решил проблему масштабируемости прокси при обработке тысяч параллельных подключений. Эта задача масштабирования получила название C10k — стремление обеспечить качественную обработку 10 тысяч одновременных клиентов.

Решения, основанные на событийно-ориентированной архитектуре, принципах асинхронного ввода-вывода и одном цикле событий, позволили значительно повысить производительность. Примером такой архитектуры является событийный цикл Node.js или библиотека Netty для Java. Однако чисто однопоточные циклы событий имеют свои ограничения. Любое долгое блокирующее действие, например длительный TLS хэндшейк или операция ввода-вывода с диском, может остановить обработку всех остальных запросов.

Это вынудило разработчиков обратить внимание на многопоточные события и гибридные модели, где несколько потоков обрабатывают различные аспекты нагрузки, обеспечивая как параллелизм, так и высокую отзывчивость. В эпоху многопроцессорных и многоядерных систем, когда количество ядер процессоров достигает сотен, однопроцессное или однопоточное решение уже не удовлетворяет требованиям масштабируемости. Многие современные прокси, например HAProxy и NGINX, применяют многопроцессную или многопоточную модели, которые позволяют эффективно распределять нагрузку по ядрам. Интересной технологией для более эффективного использования ресурсов ОС является сокет-шардинг с помощью опции SO_REUSEPORT. Она даёт возможность нескольким потокам или процессам слушать один и тот же порт и делить нагрузку при принятии входящих соединений на уровне ядра операционной системы.

Такая архитектура снижает накладные расходы на переключение контекста и повышает производительность сервера. Однако несмотря на преимущества, данный метод имеет и свои недостатки. Например, разные обработчики в многопоточной среде могут действовать автономно, не синхронизируя свои действия, что порождает неравномерность распределения нагрузки по внутренним серверам. В частности, такой эффект можно наблюдать в Envoy, где энд-то-энд обработка часто происходит в рамках одного потока, затрудняя точное балансирование запросов по разным узлам. Кроме того, обратные прокси вынуждены столкнуться с дополнительными сложностями в работе с TLS.

Поддержка разных версий протоколов, выбор подходящей библиотеки для работы с криптографией, например OpenSSL, LibreSSL или BoringSSL, а также управление TLS-сессиями создают дополнительный уровень сложности. Все эти аспекты необходимо учитывать при разработке и развёртывании прокси, чтобы обеспечить надежность и безопасность соединений. Наряду с сетевыми аспектами, немаловажной частью является функция наблюдаемости и мониторинга. Отслеживание состояния соединений, логирование запросов, анализ производительности и быстродействия — все это важные задачи для своевременного обнаружения и устранения проблем в интернете. Подводя итог, стоит отметить, что обратный прокси — это сложная, многогранная система с множеством внутренних взаимосвязанных подсистем.

Управление соединениями и масштабируемость — это лишь часть задач, с которыми ежедневно сталкиваются разработчики и администраторы. Правильный выбор прокси и глубокое понимание его работы позволяют построить надёжную, быстpую и безопасную инфраструктуру для современных веб-сервисов. Понимание архитектурных особенностей работы обратного прокси, включая обработку большого количества одновременных соединений, внедрение событийно-ориентированных технологий и оптимизацию под многоядерные системы, становится ключевым навыком для профессионалов, работающих с высоконагруженными приложениями и обслуживающих миллионы пользователей в режиме реального времени.