Современные технологии искусственного интеллекта стремительно развиваются, и вместе с ними растут возможности программных агентов, способных выполнять широкий спектр задач без непосредственного контроля со стороны пользователя. Однако такой прогресс всегда сопровождается рядом новых вызовов, главным из которых становится безопасность и управление доступом. Особенно остро данный вопрос стоит для разработчиков, которые все чаще начинают использовать ИИ-агентов, таких как Claude Code, в своих инструментах и рабочих процессах. Чтобы снизить связанные с этим риски, важным элементом становится внедрение тонкой, гибкой и надежной HTTP-фильтрации. Рассмотрим, почему это необходимо и как можно обеспечить эффективный контроль над сетевым трафиком в средах с ИИ-агентами.

Основная опасность применения агентов без должного сетевого контроля связана с их способностью выполнять действия, которые могут нанести вред - будь то случайное или намеренное удаление данных, разглашение конфиденциальной информации, такой как API-ключи, либо выход за рамки выделенных полномочий и внесение изменений без согласования. Важно понимать, что даже сама природа ИИ-агентов, их склонность к интерпретации инструкций и потенциальная уязвимость к технике "внедрения запроса" (prompt injection) создают предпосылки для таких инцидентов. Поэтому любые решения, направленные на повышение безопасности, должны предусматривать строгий контроль HTTP(S)-трафика, чтобы ограничить доступ агентов только к необходимым ресурсам. Традиционные методы сетевой фильтрации, основанные на блокировке IP-адресов или использовании стандартных правил межсетевого экрана, оказываются недостаточно гибкими и сложными для масштабирования в условиях динамично меняющихся потребностей. Здесь на помощь приходит концепция тонкой HTTP-фильтрации на уровне процессов и протоколов, что позволяет не только разрешать или запрещать соединения, но и реализовывать гораздо более сложные проверки, например, на основе содержимого запроса, метода HTTP или целевого хоста.

Одним из эффективных инструментов для выполнения таких задач является httpjail - система, которая реализует перехват HTTP(S) трафика вместе с изоляцией сетевого пространства на уровне процессов. В отличие от традиционных решений, httpjail использует правила, написанные на JavaScript или в виде исполняемых скриптов, что существенно повышает их гибкость и уменьшает порог вхождения для разработчиков, знакомых с программированием вне специфичных доменных языков. Основные возможности httpjail позволяют, например, заблокировать все HTTP-запросы, кроме обращения к API крупной языковой модели Claude, тем самым предотвращая нежелательную коммуникацию с внешними сервисами и вытекание данных на сторонние серверы. Кроме того, можно ограничить трафик только запросами типа GET, фактически сделав интернет для агента "только для чтения", что сопровождается повышением уровня безопасности и снижением шансов внесения изменений без разрешения. Для пользователей, которые хотят управлять списком разрешённых ресурсов более централизованно, httpjail поддерживает возможность обращения к внешним файлам с белым списком доменов.

Это удобно для командной работы и контроля, поскольку позволяет динамически обновлять перечень доступных для связи сервисов и строго соблюдать корпоративную политику безопасности. Одним из ключевых компонентов такой системы фильтрации является внедрение полного TLS-перехвата. Простое ограничение доступа только по имени хоста, которое можно получить из TLS SNI, не даёт достаточного уровня контроля. Надёжный анализ и фильтрация HTTPS-запросов возможны лишь при надлежащем расшифровании трафика. httpjail решает эту задачу с помощью создания собственного корневого центра сертификации, который генерируется при первом запуске и используется для подписи динамически создаваемых сертификатов для каждого целевого хоста.

Это позволяет инструменту проводить инспекцию и фильтрацию HTTPS-соединений на лету, не снижая производительность и не вызывая сбоев у клиентов. Такое "двойное" проксирование HTTPS соединений реализовано в двух режимах: прозрачный прокси, принимающий TLS-пакеты напрямую, и явный прокси, который допускает обработку HTTP CONNECT запросов. Важным моментом является необходимость доверять сгенерированному корневому сертификату на клиентских устройствах или в средах выполнения - httpjail автоматически настроит необходимые переменные окружения для большинства инструментов, включая curl, Git, Python requests, Node.js и другие, что значительно упрощает процесс внедрения. Тем не менее, никакая система изоляции не является абсолютно непроницаемой.

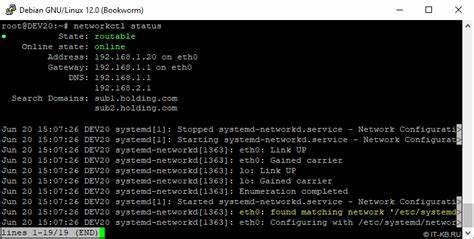

В слабом режиме httpjail основывается на корректном поведении приложений, которые учитывают переменные окружения HTTP_PROXY/HTTPS_PROXY. В этом случае легко обходить ограничения с помощью простых манипуляций, например, вызова сторонних программ, игнорирующих прокси. И даже сильный режим, в котором задействуется изоляция на уровне пространств имён и перенаправление трафика через внутренние правила фаервола (например, через nftables), оставляет небольшие "лазейки", например, через файловую подсистему или доступ к сокетам Docker для запуска отдельного контейнера. Вопросы целостности и комплексности безопасности решаются комбинированием сетевых и файловых уровней изоляции. httpjail предлагает интеграцию с контейнеризацией через опцию --docker-run, что даёт возможность запускать приложения в изолированной среде с твёрдым контролем интернет-доступа, минимизируя риски обхода и повышая прозрачность действий агентов.

Для особо чувствительных сценариев рекомендуется работа в режиме сервера. В таком случае httpjail разворачивается на выделенном отдельном сервере, к которому направляется весь HTTP(S)-трафик, а локальные настройки среды гарантируют, что все сетевые обращения проходят через этот прокси с применением правил. Это позволяет выстроить строгую защиту, контролируемую на уровне сетевого оборудования и внутренней политики организации. В заключение, внедрение тонкой HTTP-фильтрации становится неотъемлемой частью эффективной и безопасной работы с интеллектуальными агентами, такими как Claude Code. Инструменты вроде httpjail позволяют организовать гибкий и прозрачный контроль сетевого взаимодействия, снижая риск случайных или злонамеренных действий, защищая конфиденциальные данные и обеспечивая совместимость с современными протоколами и инструментами разработчиков.

В мире, где ИИ всё глубже интегрируется в процессы разработки и бизнеса, грамотное управление сетевым доступом - это не просто преимущество, а необходимость для поддержания высокого уровня безопасности и доверия. При правильном использовании такие решения дают возможность использовать весь потенциал современных кодогенераторов и ИИ-ассистентов, не опасаясь нежелательных последствий и утечек информации. .