Современный научный мир сталкивается с новой реальностью, связанной с быстрым развитием искусственного интеллекта и языковых моделей. Машинное обучение и особенно крупные языковые модели (LLM) все активнее проникают в академическую сферу, оказывая влияние на процесс написания научных статей, рецензирования и проверки качества исследований. Однако вместе с новыми возможностями возникают и серьезные вызовы, в частности, связанные с прозрачностью и честностью публикаций. Именно здесь на помощь приходят инновационные ИИ-инструменты, способные обнаруживать тексты, сгенерированные языковыми моделями, и тем самым помогать научному сообществу выявлять несанкционированное использование подобных технологий в научных публикациях и рецензиях. В последние годы концентрация внимания на искусственном интеллекте в науке заметно выросла.

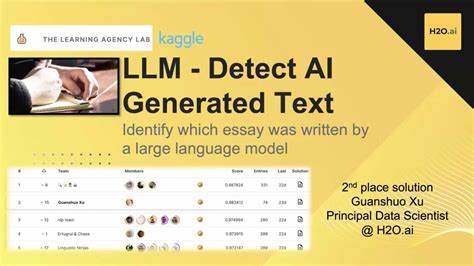

Одним из центральных вопросов стало соблюдение этики публикаций с учетом использования ИИ. Многие научные журналы ввели политики, ограничивающие или требующие обязательного раскрытия информации о применении языковых моделей в создании статей и отзывов, однако практика показывает, что часть авторов и рецензентов пренебрегает такими требованиями. В случае если использование ИИ остается скрытым, это ставит под угрозу не только репутацию научных изданий, но и надежность и достоверность самой науки. В ответ на возникшие проблемы, несколько научных издательств и исследовательских групп разработали и внедрили автоматизированные системы для мониторинга и выявления фрагментов текста, созданных с помощью LLM. Эти инструменты анализируют особенности стилистики, семантики и структуры текста, используя передовые алгоритмы машинного обучения для определения вероятности его генерации искусственным интеллектом.

Благодаря таким технологиям раскрываются тенденции внедрения языковых моделей в академический процесс. Исследования, проведенные на основе анализа десятков тысяч научных статей и рецензий, продемонстрировали резкий рост доли текстов с элементами ИИ-го происхождения за последние несколько лет. Это феномен, который нельзя игнорировать, и который требует комплексной реакции со стороны научного сообщества. Использование языковых моделей предоставляет значительные преимущества авторам и рецензентам. Среди них - повышение скорости подготовки материалов, улучшение грамматической и стилистической составляющей текста, помощь в переводе и структурировании информации.

Тем не менее, эта технология не является универсальным решением и сопряжена с рисками и ограничениями. Одним из ключевых критических моментов является возможное снижение качества научного анализа при чрезмерном доверии к генеративным моделям, которые не всегда способны выявить тонкие научные нюансы или ошибочно воспроизводят информацию. Кроме того, использование ИИ без прозрачного раскрытия его участия подрывает доверие в системе научных коммуникаций. Важной стороной внедрения детекторов LLM-генерированных текстов стало укрепление этических норм и практик в научной публикационной среде. Авторы и рецензенты теперь сталкиваются с необходимостью большей ответственности, а журналы - со все более четкими механизмами контроля.

Новые инструменты позволяют выявлять попытки использования языковых моделей без соответствующих уведомлений и справедливо реагировать на выявленные нарушения. Распознавание ИИ-сгенерированного содержания способствует не только борьбе с недобросовестным поведением, но и служит стимулом для разработки новых правил взаимодействия между учеными и искусственным интеллектом. Постепенно формируются представления о том, каким образом искусственный интеллект может поддерживать исследовательскую деятельность, при этом не заменяя, а дополняя человеческий интеллект и критическое мышление. Однако внедрение таких технологий вызывает и ряд сложных вопросов, требующих обсуждения на всем уровне научной сферы. Как определить грань допустимого использования ИИ в научной работе? Нужно ли создавать обязательные стандарты по раскрытию участия языковых моделей в написании статей? Как справиться с риском появления плагиата или фабрикации данных в эпоху генеративного ИИ? Множество ученых, издателей и этиков активно дискутируют на эти темы, формируя новые нормы, которые будут важны для обеспечения честности и прозрачности науки в будущем.

Одно из ключевых направлений текущих исследований - совершенствование самих детекторов ИИ-генерированного текста. Поскольку языковые модели быстро развиваются, становится все сложнее отличить человекообразный контент от машинного. Поэтому исследователи занимаются разработкой методов анализа вероятностных распределений слов, синтаксических шаблонов, а также искусственных артефактов, которые могут указывать на машинное происхождение. Аналогично совершенствуются и подходы к обучению новых языковых моделей с целью минимизации рисков использования их для нарушения этических норм. В дальнейшем ожидается интеграция таких инструментов непосредственно в процессы подачи и рецензирования статей, что позволит своевременно выявлять проблемы и предупредить возможные злоупотребления.

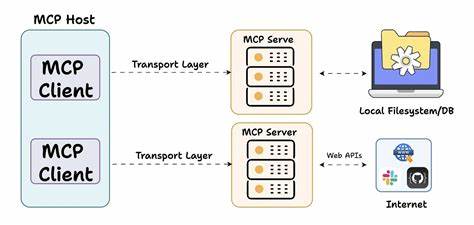

Эффективное применение ИИ-инструментов в академической сфере создает предпосылки для повышения качества научных публикаций и справедливости в рассмотрении работ. Это особенно актуально на фоне продолжающейся цифровой трансформации науки, роста объема информации и необходимости быстро получать достоверные сведения. Благодаря новым технологиям издатели смогут оперативно выявлять тексты с элементами ИИ, оценивая при этом не только оригинальность, но и соответствие научным стандартам. Таким образом, искусственный интеллект оказывается не только источником новых вызовов, но и мощным помощником для повышения прозрачности и эффективности научного процесса. Важно, чтобы внедрение таких инноваций сопровождалось активным диалогом между исследователями, редакторами и разработчиками технологий.

Совместная работа и обмен опытом помогут сформировать баланс, который позволит максимально использовать преимущества ИИ, одновременно сохраняя фундаментальные ценности науки. Необходимо помнить, что несмотря на возможности, искусственный интеллект не заменит человеческий ум и творческую составляющую. Его роль должна быть вспомогательной, помогая ученым достигать новых горизонтов без ущерба для этики и достоверности результатов. На фоне развития и расширения практического применения языковых моделей в научных публикациях возрастают задачи по борьбе с недобросовестным использованием этих технологий. Использование специализированных детекторов уже дало первые результаты в выявлении случаев несоблюдения правил, что способствует поддержанию порядочности и профессионализма.

В совокупности с усовершенствованием политики и повышением осведомленности научного сообщества, эта тенденция открывает путь к более ответственному и прозрачному научному исследованию, в котором искусственный интеллект служит не источником проблем, а инструментом прогресса. .