Современные языковые модели, основанные на архитектуре трансформеров, произвели революцию в области искусственного интеллекта, демонстрируя выдающиеся способности к генерации текста, пониманию контекста и сложному рассуждению. В основе их успеха лежит механизм внимания, который позволяет моделям учитывать взаимосвязи между всеми словами во входной последовательности. Однако с ростом длины текста вычислительные затраты на классический механизм внимания возрастают квадратично, что создает серьезные трудности для масштабирования и эффективности моделей при работе с большими объемами данных. Квадратичная сложность внимания означает, что при удвоении длины текста объем вычислений увеличивается в четыре раза. Это становится критической проблемой при обработке текстов из тысяч, а тем более десятков тысяч токенов.

Хранение и вычисление матрицы внимания, размер которой равен квадрату количества токенов, требует огромных ресурсов памяти и времени. В результате производительность моделей падает, а требования к аппаратному обеспечению становятся чрезмерно высокими. Низкоранговое внимание предлагает элегантное решение этой проблемы, позволяя сохранять преимущества классического внимания при значительном сокращении вычислительных затрат. Концепция основана на идее компрессии матрицы внимания - снижения её ранга, то есть сложности, без существенной потери важной информации. В терминологии линейной алгебры это означает аппроксимацию большой, высокоразмерной матрицы с помощью произведения двух меньших матриц с меньшим количеством параметров.

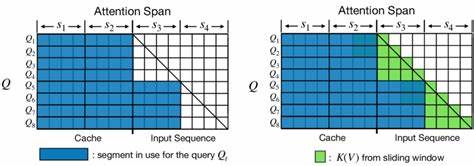

Такое преобразование можно сравнить с упрощением фотографии: если исходное изображение содержит большое количество пикселей, то сжатая версия сохраняет основные детали, делая файл гораздо меньше по размеру. Аналогично, низкоранговое внимание уменьшает количество необходимых вычислений, выделяя наиболее значимые взаимодействия между токенами и устраняя избыточность. На практике это достигается путем проецирования ключевых и значимых векторов модели в пространство меньшей размерности. Например, вместо того, чтобы сравнивать каждое слово со всеми остальными, модель сначала уменьшает размерности ключей и значений, создавая более компактное представление последовательности. Таким образом, матрица внимания переходит от размера N на N к размеру N на k, где k значительно меньше N - рангу аппроксимации.

После этого вычисления внимания происходят в этом сжатом пространстве, что значительно экономит ресурсы. Обучаемость такого подхода также очень важна. Параметры матриц проекций оптимизируются вместе со всем модельным весом посредством обратного распространения ошибки, благодаря чему модель адаптируется к наиболее релевантному сжатию информации. Это позволяет достичь результата, близкого к эффекту полной матрицы внимания, но с многократным улучшением производительности. Одним из известных примеров внедрения низкорангового внимания является модель Linformer, разработанная исследователями из Facebook AI.

Linformer доказал, что можно значительно сократить время обработки и расход памяти, одновременно сохраняя при этом качество решения задач понимания естественного языка на уровне стандартных трансформеров. Такая эффективность особенно проявляется при работе с длинными текстами, позволяя обрабатывать заметно больше данных на тех же аппаратных средствах. Преимущества низкорангового внимания выходят за рамки экономии времени и ресурсов. Освобожденная вычислительная мощность позволяет моделям обрабатывать большие контексты, например целые главы книг, комплексные документы или многоходовые диалоги. Это открывает новые горизонты для систем автоматического резюмирования, юридического анализа, генерации кода и других направлений, где длинный контекст критически важен.

Кроме того, снижение нагрузки на вычислительные узлы ведет к уменьшению энергопотребления, что актуально с точки зрения экологической ответственности и экономической выгоды. Учитывая огромный масштаб облачных вычислений, используемых для тренировки и эксплуатации больших моделей, рост энергоэффективности приобретает особую значимость. Однако подход низкорангового внимания не лишен своих ограничений и вызовов. Аппроксимация матрицы внимания неизбежно теряет часть информации, что может повлиять на точность моделей в задачах, требующих учета мелких и детальных взаимодействий между токенами. Выбор оптимального ранга - важный этап настройки, так как слишком малая размерность компрессии приведет к ухудшению качества, а слишком большая не даст ожидаемой оптимизации.

Кроме того, внедрение низкорангового внимания требует изменения архитектуры или обучения моделей с нуля, что повышает сложность разработки и может замедлить этапы экспериментов. В то же время, интеграция с уже существующими оптимизациями классического внимания, такими как FlashAttention или sparse attention, требует тщательного подхода для достижения наилучших результатов. Некоторые современные направления исследований пытаются комбинировать низкоранговое внимание с другими эффективными механизмами, например смешанным использованием разреженного и низкорангового внимания, что позволяет адаптивно выбирать подход в зависимости от характера входных данных и конкретной задачи. Такие гибридные методы обещают повысить универсальность и надежность моделей без существенных потерь в производительности. Сейчас, когда объемы данных и требования к контексту в языковых моделях резко возрастают, а темпы аппаратного прогресса снижаются, оптимизации вроде низкорангового внимания становятся особенно востребованными.

Они позволяют идти в ногу с растущими вызовами, снижая барьеры по памяти и времени обработки, которые раньше считались непреодолимыми. Все больше исследователей и инженеров вводят элементы низкорангового внимания в крупные модели, и есть все основания ожидать, что в ближайшем будущем эта технология станет стандартом в индустрии. Она будет способствовать развитию более масштабируемых, гибких и экологичных ИИ-систем, способных анализировать и генерировать большие объемы информации в реальном времени. Таким образом, низкоранговое внимание представляет собой важный шаг вперед в эволюции трансформеров. Оно демонстрирует, что интеллектуальное сокращение объема вычислений возможно без значительных потерь качества, открывая путь к новым возможностям и уровню производительности.

Для специалистов в области машинного обучения и искусственного интеллекта понимание и освоение концепций низкорангового внимания становится необходимым элементом в развитии современных моделей и приложений. Интерес к этой теме будет только расти по мере того, как требования к обработке длинных и сложных данных увеличиваются, а ресурсы становятся все более ценными. Те, кто успеет освоить и применить эти инновационные методы, смогут создавать более эффективные и мощные инструменты, которые будут задавать тон в будущем цифровых технологий и искусственного интеллекта. .